III. LE GRAND MARCHÉ DE L'IA : UNE CHAÎNE DE VALEUR ÉTENDUE DES MATIÈRES PREMIÈRES AUX CONSOMMATEURS

L'intelligence artificielle dépasse sa dimension de progrès technologique principalement logiciel, il faut aussi la considérer comme source de puissance et comme enjeu géopolitique sur l'ensemble des aspects de la chaîne de valeur qu'elle recouvre. La question des infrastructures matérielles qui permettent de fournir la puissance de calcul permettant d'entraîner et d'utiliser des modèles de plus en plus performants est un aspect important à examiner dans ce cadre.

A. DU SILICIUM AUX APPLICATIONS : LA CHAÎNE DE VALEUR COMPLEXE DE L'INTELLIGENCE ARTIFICIELLE

1. Un schéma souvent simplifié en quatre étapes

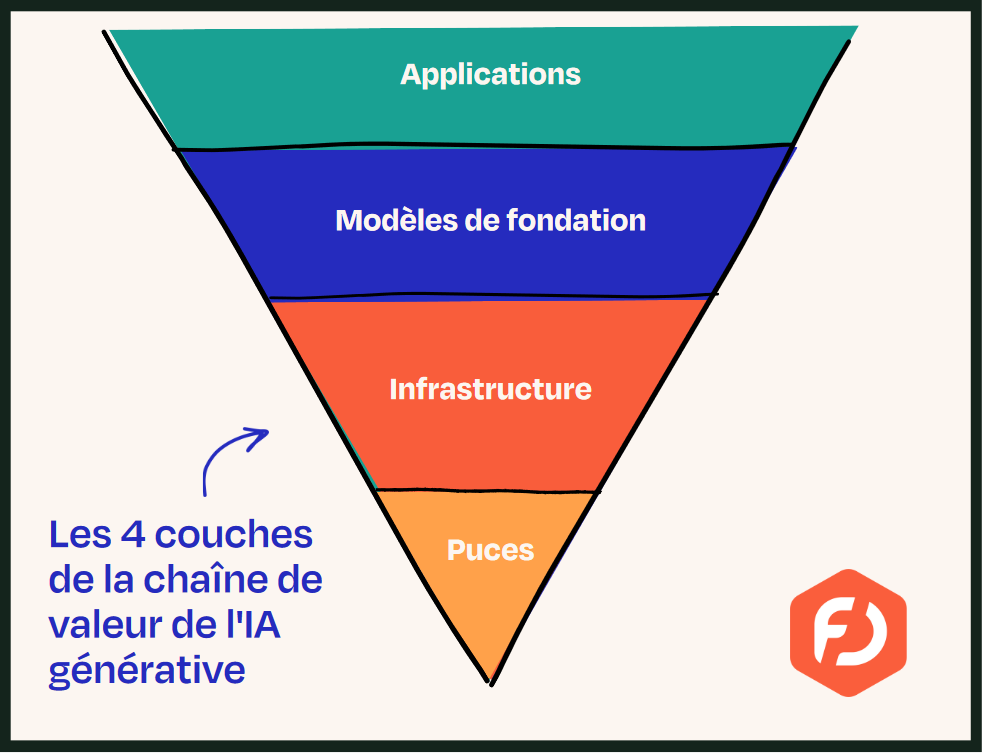

L'association France Digitale, qui représente les intérêts des start-up françaises du numérique a publié en avril 2024 un rapport intitulé « Des puces aux applications, l'Europe peut-elle être une puissance de l'IA générative »157(*). Ce document présente la chaîne de valeur de l'IA de manière simplifiée en quatre étapes :

- premièrement, les puces en silicium, qui comprennent à la fois le matériel physique et les matières premières nécessaires à leur élaboration ;

- la deuxième étape de la chaîne de valeur est l'infrastructure, qui supporte la fabrication du logiciel d'intelligence artificielle. Ce maillon de la chaîne comprend les centres de données dans lesquels sont stockés les microprocesseurs, le réseau qui peut permettre l'accès à des centres de données distants, et les logiciels qui permettent la programmation ;

- vient ensuite l'étape du « modèle de fondation », c'est-à-dire la conception d'un modèle « brut » grâce à une immense quantité de données. Ces modèles ne sont pas réglés pour une utilisation spécifique. C'est par exemple le modèle GPT-4o, utilisé pour construire la dernière version en date de l'agent conversationnel ChatGPT, qui lui, est une application ;

- enfin, la chaîne de valeur se termine par la strate des applications. Il s'agit de l'utilisation des modèles de fondation pour développer des applications qui répondent à des cas d'usage concrets par le biais du processus de réglage fin. Les utilisateurs ont accès aux modèles via des interfaces qui peuvent répondre à leurs besoins.

Schéma simplifié de la chaîne de valeur de l'IA générative

Source : France Digitale

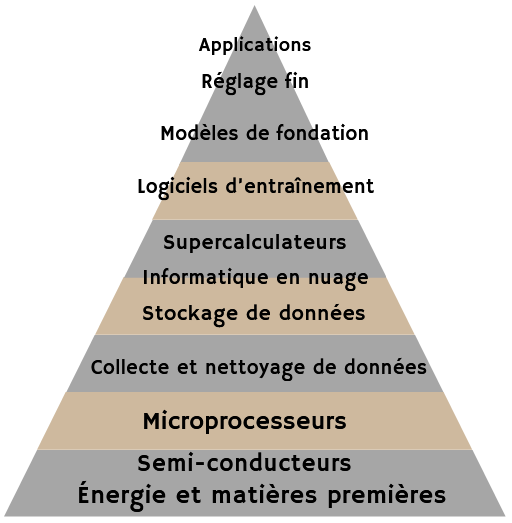

L'Office identifie quant à lui, au terme de ses auditions et déplacements, une dizaine de niveaux en raffinant cette première analyse.

2. La complexité de la dizaine d'étapes de la chaîne

a) L'amont : du silicium aux microprocesseurs

Chacune de ces quatre étapes peut en réalité être elle-même découpée en plusieurs niveaux. Par exemple, la première couche dite des « puces » concerne tout autant l'énergie nécessaire à l'ensemble des processus, dont les besoins sont grandissants158(*), l'extraction et la manipulation de matières premières pour construire les semi-conducteurs en silicium que la construction des puces, les logiciels qui permettent de les concevoir et de les utiliser ou, encore, les machines lithographiques capables de creuser le silicium à l'échelle microscopique.

Le dioxyde de silicium, ou silice, certes abondant sur terre, n'est pas du simple sable ou granit fondu : il s'agit d'un cristal de silice monocristallin, soumis au procédé de Czochralski159(*) pour l'homogénéiser ainsi qu'au dopage (ajout d'impuretés160(*)) pour déterminer les propriétés de conductivité recherchées pour chaque semi-conducteur. Ce dernier est, en effet, à la fois, comme son nom l'indique, isolant et conducteur, il s'agit d'un matériau intermédiaire entre les isolants et les conducteurs électriques. Sa pureté à 99,99 % est donc doublement contrôlée, par le procédé de Czochralski et par le procédé de dopage.

Semi-conducteurs, transistors, circuits intégrés et microprocesseurs

Ces quatre notions, parfois confondues, sont pourtant à distinguer : les premiers sont la base matérielle des transistors, ceux-ci sont regroupés dans des circuits intégrés et ces derniers lorsqu'ils permettent avec une unité unique de faire fonctionner un ordinateur prennent le nom de microprocesseurs.

Dès 1833, Faraday constate qu'à la différence de la plupart des métaux dont la résistance augmente avec la température, certains métaux comme le sulfate d'argent sont de plus en plus conducteurs avec la hausse de la température (coefficient de température négatif)161(*). Un siècle plus tard, en 1931, Wilson théorise les semi-conducteurs : les électrons forment des ondes dans les solides et la conduction électrique de certains matériaux varie en fonction de divers facteurs comme la température, le courant électrique ou la lumière.

Au moment où les travaux se concentrent sur l'utilisation du silicium et du germanium, semi-conducteurs à haut point de fusion, trois chercheurs américains des Bell Labs (Bardeen, Shockley et Brattain) construisent en 1947, à partir de ces semi-conducteurs, le premier transistor.

Cette technologie, qui correspond au contrôle ou à l'amplification du courant électrique par la combinaison de trois électrodes162(*), soit aussi parallèlement développée en France163(*). C'est, en définitive, Texas Instruments qui va à ce moment capter le marché mondial avec la fabrication des premiers transistors en silicium puis des radios à transistor à partir de 1954.

En 1958, c'est encore Texas Instruments, grâce à l'ingénieur Jack Kilby, qui réalise le premier circuit intégré ou « puce », dispositif rassemblant plusieurs transistors interconnectés en circuits microscopiques sur un support alors en germanium et dans un même petit boîtier.

De quelques transistors dans les années 1960 (moins de dix), ces circuits passent le cap du million de transistors à la fin des années 1980, avec les circuits intégrés dédiés aux ordinateurs appelés microprocesseurs. Ces derniers, qui exécutent au sein d'une puce unique des instructions et traitent les données des programmes à l'aide de logiques binaires, ont été inventés par Intel en 1971 (avec un premier système à 2 300 transistors). Le cap des 42 millions de transistors est atteint en 2000 avec le microprocesseur Pentium 4, celui du milliard en 2010, avec le microprocesseur Intel Core i7. En 2024, le microprocesseur Blackwell de Nvidia gravé à 4 nm près164(*) par TSMC et présenté à vos rapporteurs au siège de l'entreprise dans la Silicon Valley compte 208 milliards de transistors.

Le cofondateur de l'entreprise Intel, Gordon Moore, a laissé son nom à la prédiction, qu'il établit dès 1965 et précisa en 1975, du doublement du nombre de transistors présents sur une puce de microprocesseur tous les deux ans. Cette augmentation exponentielle, nommée « loi de Moore », liée à la miniaturisation, est observée empiriquement jusqu'aux années 2010. Pour qu'elle reste valable, il a fallu prendre en compte le traitement parallèle des calculs dans des architectures multicoeurs. Le mur des limites physiques des microprocesseurs, avec le fait d'approcher de la taille moléculaire, est atteint. La contrepartie de cette loi de Moore - fondée sur la réduction de la taille des traits gravés dans le silicium permettant d'augmenter la densité des processeurs et par conséquent leur vitesse - est la « loi de Rock » (du nom d'Arthur Rock) selon laquelle le coût d'une fonderie de semi-conducteurs double quant à lui tous les quatre ans, sous l'effet de procédés de fabrication de plus en plus chers.

Ces différents processus sont assumés par différentes entreprises, même si Nvidia semble être devenu, pour le moment, l'acteur dominant de ce premier maillon de la chaîne. Cette entreprise américaine de la Silicon Valley s'est spécialisée dès sa naissance sur les puces d'accélération pour interface graphique.

Son premier partenariat stratégique est signé en 1994 avec l'entreprise française Thomson et ses premières puces sont commercialisées un an plus tard. Cependant, sa particularité est de produire des puces et des logiciels mais de ne rien fabriquer elle-même : pour ses semi-conducteurs, l'entreprise repose sur l'offre des sociétés de fonderie de semi-conducteurs.

Elle devient ainsi partenaire de l'entreprise de fonderie taïwanaise TSMC à partir de 1998. Puis, un an plus tard, elle commercialise la première carte vidéo GPU grand public. Ces processeurs graphiques dont l'acronyme vient de l'anglais Graphics Processing Units prennent en charge, grâce à des structures de calculs parallèles, l'intégralité des calculs graphiques et optimisent l'affichage 2D et 3D ou encore les vidéos. Leur usage a notamment été accéléré par le succès des jeux vidéo en 3D. Le parallélisme de ces processeurs a conduit à leur utilisation dans le calcul matriciel des nouvelles technologies d'IA des années 2000 et 2010 telles que le Deep Learning.

En 2023, le chiffre d'affaires de Nvidia représentait 71 milliards de dollars, et en juin 2024, avec 3 335 milliards de dollars, l'entreprise était la société avec la plus forte valorisation au monde. En novembre 2024, après avoir été redoublée par Apple quelques mois, sa valorisation de 3 430 milliards de dollars en a refait la première entreprise au monde.

Si Nvidia ne fabrique pas de puces mais les conçoit, comme le font AMD ou Qualcomm, la production de semi-conducteurs en silicium est un marché assez monopolistique, car les coûts fixes sont prépondérants, ce qui le rapproche des conditions d'un monopole naturel.

En dépit de cette caractéristique, cette première étape de la production des puces voit plusieurs entreprises se partager le marché mondial.

Les fabricants de semi-conducteurs sont en effet répartis entre :

- ceux qui conçoivent, fabriquent et commercialisent les puces, que l'on qualifie d'entreprises mixtes ;

- ceux qui ne font que produire les semi-conducteurs et les microprocesseurs (souvent conçus par leurs clients), appelés les fondeurs ;

- et ceux qui conçoivent et commercialisent les microprocesseurs sans les produire (on parle de fabless), choisissant de sous-traiter la fabrication à des sociétés de fonderie.

Le leader mondial de cette dernière catégorie, avec plus de la moitié du marché de la fonderie de semi-conducteurs, est TSMC (pour Taiwan Semiconductor Manufacturing Company Limited), fournisseur de Nvidia, mais aussi d'AMD, d'Apple, de Qualcomm, etc.

Même Intel, Texas Instruments ou STMicroelectronics, qui conçoivent, fabriquent et commercialisent des puces, confient une part de leur production à TSMC. Son chiffre d'affaires représentait 71 milliards de dollars en 2023 et le groupe a rejoint en juillet 2024 le cercle restreint des entreprises valorisées à plus de 1 000 milliards de dollars.

Les trois autres géants de ce marché de la fonderie sont GlobalFoundries (ex-fonderie du groupe américain AMD vendue aux Émirats arabes unis), le taïwanais UMC (United Microelectronics Corporation) et le chinois SMIC (Semiconductor Manufacturing International Corporation).

L'entreprise sud-coréenne Samsung reste quant à elle leader sur la filière semi-conducteurs hors fonderie et fabless, activité dans laquelle elle fait la course en tête avec Intel et qui représente un quart de son chiffre d'affaires.

Le seul Européen qui surnage dans ce contexte oligopolistique, est la société néerlandaise ASML qui s'est spécialisée dans la fabrication de machines de photolithographie nécessaires à la gravure des microprocesseurs sur les galettes de silicium. Elle fournit l'ensemble des fabricants de microprocesseurs, notamment les plus gros comme Samsung, Intel et TSMC, et a pour concurrent les Japonais Nikon et Canon.

b) La couche multiforme des infrastructures

Le deuxième maillon de la chaîne, celui des infrastructures, se subdivise en de nombreuses couches :

- la collecte et le nettoyage de données165(*) ;

- le stockage de données dans de vastes data centers ;

- l'informatique en nuage (cloud) pour les calculs ;

- et, lors de la phase de développement des modèles, le recours spécifique à des supercalculateurs.

La multiplication de ces infrastructures et les progrès qualitatifs de leurs équipements conduisent à des coûts immenses166(*) et à des impacts environnementaux considérables dont il sera question plus loin.

Selon une analyse de Sequoia Capital de juin 2024, intitulée « La Question à 600 milliards de dollars de l'IA », le coût des infrastructures de Nvidia (réparti à moitié entre les GPU et le reste, c'est-à-dire l'énergie, les bâtiments, les générateurs de secours, etc.) devra conduire à un chiffre d'affaires de 600 milliards de dollars pour permettre un retour sur investissement167(*). L'auteur avait estimé ce montant à 200 milliards de dollars en septembre 2023.

c) L'étape de définition des modèles : de leur architecture au réglage fin

Cette couche de la chaîne de valeur de l'intelligence artificielle qui permet de concevoir les modèles d'IA est elle-même subdivisée entre plusieurs étapes :

- la conception de l'architecture du modèle ;

- l'entraînement du modèle à l'aide des infrastructures vues précédemment et d'algorithmes qui sont des logiciels d'entraînement ;

- le réglage fin qui prend les formes d'apprentissages supervisés et d'une phase « d'alignement », cette phase pouvant être sous-traitée comme le montre l'exemple du recours à Sama par OpenAI.

Les modèle de fondation s'intercalent donc entre la définition de l'architecture du modèle et le fine-tuning permettant aux systèmes d'IA d'être déployés pour telle ou telle application spécifique, voire parfois d'être diffusés auprès du grand public.

d) L'aval : les applications

En dernier lieu, les systèmes d'IA ne sont au final accessibles aux utilisateurs qu'avec une couche de services applicatifs (dont les fameux LLM d'OpenAI, de Meta ou de Mistral, comme ChatGPT, Llama et Mistral Large). Cette étape est indispensable pour permettre la diffusion de la technologie des laboratoires de recherche des entreprises vers les consommateurs, voire le grand public.

Comme pour Google en matière de moteur de recherche, Amazon en matière de e-commerce ou Meta en matière de réseaux sociaux, cette couche applicative spécialisée tend aussi à être monopolistique.

ChatGPT, système d'IA commercialisé par OpenAI - entreprise financée par Microsoft qui détient la moitié de son capital -, a ainsi attiré la majorité des utilisateurs de LLM et reste, depuis son lancement en novembre 2022, le produit dominant sur le marché. Cette position devrait être renforcée par son intégration sous le nom de Copilot dans les logiciels Office de Microsoft (Word, Excel, Outlook, Teams et PowerPoint), dans le navigateur Edge de Microsoft et dans le moteur de recherche Microsoft Bing (qui cherche à contester le monopole actuel de Google sur ce type d'applications).

Schéma de la chaîne de valeur complexe de l'IA

La chaîne de valeur de l'intelligence artificielle est donc complexe, composée de couches, chacune souvent proche de conditions de monopole naturel. Aucune puissance n'est en mesure de posséder aujourd'hui l'ensemble de cette chaîne de valeur sur son seul marché intérieur, seule caractéristique à même de donner une véritable souveraineté en IA. Dans l'hypothèse où cela arriverait, l'État concerné disposerait alors d'un contrôle complet sur le développement des systèmes d'intelligence artificielle.

Même les États-Unis, acteur superdominant du secteur, dépendent encore largement de la fabrication des puces en dehors de leur territoire.

Il faut bien avoir conscience que les coûts correspondants au développement de chacune de ces couches sont considérables. Selon l'Index de l'IA publié chaque année par le Stanford Institute for Human-Centered Artificial Intelligence (HAI)168(*), le simple entraînement des modèles prend des mois et coûte de l'ordre d'une centaine de millions de dollars : les calculs ayant abouti à GPT-4 d'OpenAI auraient représenté un coût de 78 millions de dollars et ceux de Gemini Ultra de Google 191 millions de dollars.

Selon le PDG d'Anthropic, Dario Amodei, les modèles en cours de développement auront un coût unitaire approchant désormais le milliard de dollars. Dans cette interview d'avril 2024, il déclare également que les générations de modèles qu'il prévoit de mettre à disposition en 2025 et 2026 coûteront, chacun, entre 5 et 10 milliards de dollars169(*).

Compte tenu de ces coûts très significatifs, les modèles de pointe ne sont et ne seront donc développés, ceteris paribus, que par de très grandes entreprises technologiques. Les petites entreprises, tout comme les universités et les organismes publics de recherche, rencontreront de plus en plus de difficultés à développer des modèles avancés d'IA, du fait de leurs ressources limitées. Les difficultés de l'Université la plus riche en matière technologique, Stanford, à suivre les développements en cours, surtout en termes de nombres de microprocesseurs et donc de capacités de calcul, ont été soulignées à vos rapporteurs lors de leurs rencontres dans la fameuse Université du comté de Santa Clara.

On pourrait dès lors douter de la crédibilité de l'ambition de développer une filière nationale autonome en IA. Pourtant, on compte des entreprises françaises et européennes réparties sur l'ensemble de cette chaîne de valeur.

Dans le domaine des puces, Imerys, société minière française, leader mondial des spécialités minérales et des matériaux avancés, possède ainsi une branche spécialisée dans la production de quartz, à partir duquel peut être obtenu du silicium170(*), essentiel comme il a été vu à la construction de matériaux semi-conducteurs.

La France possède directement sur son sol des entreprises de semi-conducteurs comme Dolphin Designs ou STMicroelectronics, devenue une multinationale franco-italienne de droit néerlandais cotée au New York Stock Exchange et dont le siège social est en Suisse (BPI France et l'Italie restant les premiers actionnaires) mais qui dans le contexte du « plan composants » de 1978 est d'abord issue d'une coopération entre le CEA et Thomson à travers SGS-Thomson. En 2005, STMicroelectronics se classait encore à la 5e place du classement mondial des entreprises de semi-conducteurs, derrière Intel, Samsung, Texas Instruments et Toshiba. Les entreprises françaises Defacto Technologies, Flex.ai ou Sipearl sont également spécialisées dans la conception de puces (CPU pour Sipearl, ASIC pour Flex.ai, plateforme logicielle RTL de conception de circuits intégrés complexes pour Defacto Technologies).

D'autres aspects de cette couche matérielle de l'IA existent en Europe, par exemple l'entreprise néerlandaise Advanced Semiconductor Materials Lithography (ASML), qui produit les machines lithographiques capables de graver le silicium à l'échelle microscopique ; elle est même le leader mondial de cette activité.

Mais dans certains autres secteurs de cette première étape de la chaîne de valeur, ni la France ni l'Europe ne possèdent aujourd'hui d'entreprises.

C'est le cas pour la fabrication de cartes graphiques (graphics processing unit ou GPU), domaine hautement capitalistique dominé par les entreprises américaines Nvidia, AMD et Intel. Il en est de même pour les fonderies de silicium, domaine dans lequel il n'existe actuellement aucune alternative française ou européenne en état d'entrer sur le marché et de rentrer dans la compétition mondiale.

La France et l'Europe n'ont donc aujourd'hui d'autre choix que de se tourner en matière d'intelligence artificielle vers le marché mondial, au moins à court et moyen terme et pour une partie de la chaîne de valeur. Cela rend nécessaire de se pencher sur la place de la France dans ce marché mondial ainsi que sur les rapports de forces et les coopérations en cours ou à venir concernant l'intelligence artificielle.

* 157 Tordeux Bitker, Marianne et al. 2024. Des puces aux applications, l'Europe peut-elle être une puissance de l'IA générative ? France Digitale. https://francedigitale.org/publications/etude-ia-generative.

* 158 Les besoins en énergie vont être croissants et conduisent les acteurs du secteur à se positionner sur le marché de l'énergie, notamment sur celui de l'énergie nucléaire. La Big Tech américaine y est d'ores et déjà un acteur important : avec Constellation Energy, Microsoft prépare la remise en service d'ici 2028 du fameux réacteur de Three Mile Island ; et Alphabet (Google), Amazon ou, encore, OpenAI investissent massivement dans des projets des petits réacteurs nucléaires, les Small Modular Reactors (SMR). Cf. https://www.usine-digitale.fr/article/ia-generative-microsoft-relance-la-centrale-nucleaire-de-three-mile-island-pour-alimenter-ses-data-centers.N2219114

* 159 Ce procédé, utilisé dans l'industrie électronique, consiste à contrôler la croissance de cristaux monocristallins pour les faire grossir et atteindre de grandes dimensions (plusieurs centimètres). Les germes cristallins sont fondus sous atmosphère neutre à une température juste au-dessus du point de fusion, avec un gradient de température contrôlé, puis un germe monocristallin est placé dans une navette suspendue au-dessus du liquide par une tige tournant très lentement. Cette solidification dirigée du liquide sur le germe monocristallin permet par épitaxie de créer des cristaux ayant tous la même structure. Le barreau cylindrique ainsi créé est ensuite découpé pour être utilisé sous forme de galettes (ces tranches de matériau sont appelées wafers).

* 160 Il s'agit en effet d'ajouter aux cristaux de silicium qui composent le support, et après la phase de gravure, des impuretés en petites quantités sous la forme d'atomes d'un autre matériau afin de modifier ses propriétés de conductivité.

* 161 Cf. Guy Renard, 1963, « La découverte et le perfectionnement des transistors », Revue d'histoire des sciences et de leurs applications, tome 16, n° 4 spécial Documents pour l'histoire des techniques. pp. 323-358.

* 162 Le courant électrique est introduit par une électrode (appelée émetteur sur un transistor bipolaire ou source sur un transistor à effet de champ) et contrôlé sur l'électrode de sortie (appelée collecteur sur un transistor bipolaire ou drain sur un transistor à effet de champ) sous l'effet de l'électrode d'entrée (appelée base sur un transistor bipolaire et grille sur un transistor à effet de champ). Si le transistor est isolant sans tension sur la borne base, il devient conducteur avec une tension sur la borne base.

* 163 Le transistor est en effet parallèlement développé en France par deux chercheurs allemands de la Compagnie des Freins et Signaux conduisant à une demande de brevet en 1948. Leur système, plus résistant et plus stable que celui des Américains, permet de mettre sur le marché en 1952 la première radio à transistor, sans l'appui des autorités nationales qui estiment alors prioritaire l'industrie nucléaire. Cf. sur ces points Michael Riordan, 2005, « How Europe Missed The Transistor », IEEE spectrum : https://spectrum.ieee.org/how-europe-missed-the-transistor

* 164 Un nanomètre, de symbole nm, équivaut à un milliardième de mètre (10-9), ce qui représente la taille moyenne d'une molécule.

* 165 La collecte et le nettoyage de données sont des activités à part entière : la data extraction peut prendre la forme du web scraping, le tri ou data indexing peut prendre celle du web crawling, le nettoyage peut prendre celle de la data curation. Les web crawlers ont progressivement construit un référentiel ouvert des données issues d'Internet, appelé Common Crawl. Ces données sont nettoyées grâce à l'utilisation de divers filtres. Ces techniques peuvent par exemple permettre de supprimer des discours de haine, des expressions offensantes et d'autres contenus indésirables. Les IA génératives ont aussi recours au corpus de Wikipédia, aux référentiels GitHub (désormais propriété de Microsoft) ou encore au projet Gutenberg, qui compile plus de 50 000 ouvrages tombés dans le domaine public. Un guide préparé par des développeurs de modèles de fondation pour les développeurs de modèles de fondation existe et va plus loin que les données textuelles en s'intéressant aussi à l'image et au son (via les audiobooks par exemple) : cf. Shayne Longpre et al., 2024, « The Foundation Model Development Cheatsheet », a guide prepared by foundation models developers for foundation models developers, GitHub : https://github.com/allenai/fm-cheatsheet/commits/main/app/resources/paper.pdf

* 166 Cf. https://www.usine-digitale.fr/article/la-bulle-de-l-ia-se-poursuit-avec-une-montee-en-fleche-des-couts.N2215681

* 167 Cf. l'étude de David Cahn de Sequoia Capital : https://www.sequoiacap.com/article/ais-600b-question/

* 168 Pour son édition 2024 parue le jour même du déplacement de vos rapporteurs auprès des chercheurs de l'Université de Stanford, cf. Artificial Intelligence Index Report 2024, Stanford Institute for Human-Centered Artificial Intelligence, disponible au lien : https://aiindex.stanford.edu/report/

Il est aussi loisible de se reporter à des références plus anciennes : Or Sharir et al., 2020, The Cost of Training NLP Models : A Concise Overview, disponible sur Arxiv, https://arxiv.org/pdf/2004.08900 ainsi que Lennart Heim, 2022, Estimating PaLM's training cost, Lennart Heim Blog https://blog.heim.xyz/palm-training-cost/

* 169 Cf. l'interview de Dario Amodei par Ezra Klein retranscrite dans le New York Times du 12 avril 2024 : https://www.nytimes.com/2024/04/12/podcasts/transcript-ezra-kleininterviews-dario-amodei.html

* 170 Pour en savoir plus sur l'extraction et la géopolitique du silicium, voir cet article : https://www.mineralinfo.fr/fr/ecomine/silicium-un-element-chimique-tres-abondant-un-affinage-strategique