C. LA GOUVERNANCE EUROPÉENNE DE L'INTELLIGENCE ARTIFICIELLE

Les réflexions menées au sein de l'UE en termes de régulation de l'IA depuis quatre ans sont très proches de celles conduites par l'OCDE. Mais l'encadrement européen des systèmes d'IA ne se limite pas au régime spécifique les concernant. Le droit de l'Union européenne prévoit en effet différentes dispositions concernant les outils numériques qui peuvent impacter les systèmes d'intelligence artificielle. Depuis le 13 juin 2024, un règlement est totalement consacré à l'encadrement de l'IA ; il s'ajoute à de nombreuses autres dispositions.

Les textes sont très nombreux, parfois d'application sectorielle, il est donc difficile de tous les récapituler ici. Pour mémoire, les plus récents et les plus transversaux viennent compléter le règlement général sur la protection des données (RGPD) du 27 avril 2016 et s'insèrent dans la « Stratégie numérique pour l'Europe pour la décennie 2020-2030 » : à l'instar du règlement sur les marchés numériques du 14 septembre 2022 (dit « DMA », pour Digital Markets Act, empêchant notamment les géants du numérique de privilégier leurs services sur leurs plateformes en laissant chacun choisir librement son moteur de recherche, son navigateur ou sa messagerie) ; du règlement sur les services numériques du 19 octobre 2022 (dit « DSA », pour Digital Services Act, qui responsabilise les plateformes en rendant illégal en ligne ce qui est illégal hors ligne, comme les contenus illicites, et dont l'esprit se retrouve dans la loi du 21 mai 2024 visant à sécuriser et à réguler l'espace numérique (dite loi « SREN ») en interdisant - en ligne - les arnaques, la haine, la désinformation et la publicité ciblée sur les mineurs ou encore en protégeant les mineurs de la pornographie ; du règlement sur la gouvernance des données du 30 mai 2022 ; du règlement sur la cybersécurité du 17 avril 2019, de la directive sur la cybersécurité du 14 décembre 2022 et du règlement sur la cybersécurité du 13 décembre 2023 ; du règlement du 12 mars 2024 sur la cyberrésilience, etc.

Dans ce contexte foisonnant, il est important de noter qu'en 2024, au terme de plusieurs années de travail préparatoire, un cadre visant spécifiquement les systèmes d'intelligence artificielle a été adopté à travers le règlement du 13 juin 2024 établissant des règles harmonisées concernant l'intelligence artificielle335(*), communément dénommé AI Act. Il fait l'objet d'une application progressive d'ici à 2026 avec des règles harmonisées applicables à la mise sur le marché, à la mise en service et à l'utilisation de systèmes d'IA.

Présenté par l'Union européenne comme « premier texte législatif de ce type au monde », cette réglementation, qui se veut pionnière, a donc vocation à devenir un standard mondial concernant la mise sur le marché, la mise en service et l'utilisation de ces systèmes dans le but de garantir que l'IA soit une technologie « axée sur l'humain » et que les systèmes d'IA soient « sûrs, éthiques et dignes de confiance ».

Comme l'assure l'exposé des motifs du projet de règlement, l'AI Act vient compléter le droit de l'Union et ne le remplace pas, en particulier en ce qui concerne les droits fondamentaux ; la protection de la vie privée, des données, des consommateurs et des travailleurs ; l'emploi ; la sécurité des produits. Les droits et les recours existants pour les personnes sur lesquelles les systèmes d'IA sont susceptibles d'avoir des incidences négatives demeurent inchangés et pleinement applicables. L'intelligence artificielle ne suspend pas le droit en vigueur.

1. Le travail préparatoire conduit par les institutions européennes entre 2018 et 2020

La construction des bases de la gouvernance européenne en matière d'intelligence artificielle s'est d'abord appuyée sur trois principales contributions : une communication de la Commission européenne en avril 2018, les différentes recommandations d'un groupe d'experts placé auprès de la Commission européenne en 2019 puis un Livre blanc de la Commission en 2020.

a) La communication de la Commission européenne d'avril 2018

La Commission européenne a tout d'abord publié en avril 2018 une communication pour l'intelligence artificielle en Europe336(*). Elle appelait à la mise en place d'un cadre éthique et juridique conforme aux valeurs de l'Union européenne et à la Charte des droits fondamentaux, mais sans préconiser la création d'une législation contraignante spécifique à l'intelligence artificielle. Au lieu de cela, la communication attirait l'attention sur les cadres juridiques existants (la protection des données personnelles avec le RGPD de 2016, les règles relatives à la sécurité des produits et les régimes de responsabilité civile ordinaires).

Sur la base de cette première communication, un travail de coordination a été conduit avec les États membres et la Norvège en vue d'aboutir rapidement à un plan coordonné pour l'IA en Europe. Le 7 décembre 2018, la Commission européenne a publié une communication sur les objectifs et les initiatives d'un plan coordonné dans le domaine de l'intelligence artificielle, plan actualisé en 2021337(*).

b) Le groupe d'experts de haut niveau sur l'IA

Dans la perspective de ses futurs travaux sur l'IA, la Commission européenne avait entretemps nommé en juin 2018 un groupe d'experts de haut niveau sur l'IA (high-level experts group on artificial intelligence ou HLEG AI en anglais). Ce groupe était composé d'experts des milieux industriels et scientifiques et présidé par Pekka Ala-Pietilä, président du conseil d'administration de Huhtamaki, Sanoma et Netcompany et ex-président de Nokia ainsi que docteur honoraire en technologie à l'université de Tampere en Finlande. Le groupe devait élaborer des conclusions permettant de guider l'action de la Commission ainsi que des colégislateurs en matière d'IA. Pour ce faire, il a d'abord publié en décembre 2018 une définition de la notion d'IA, qui lui a permis de circonscrire le périmètre de ses travaux.

Cette définition reprend et étend la définition de la précédente communication de la Commission338(*) :

« L'intelligence artificielle (IA) désigne les systèmes qui font preuve d'un comportement intelligent en analysant leur environnement et en prenant des mesures - avec un certain degré d'autonomie - pour atteindre des objectifs spécifiques. Les systèmes dotés d'IA peuvent être purement logiciels, agissant dans le monde virtuel (assistants vocaux, logiciels d'analyse d'images, moteurs de recherche ou systèmes de reconnaissance vocale et faciale, par exemple) mais l'IA peut aussi être intégrée dans des dispositifs matériels (robots évolués, voitures autonomes, drones ou applications de l'internet des objets, par exemple). »

Sur la base de cette définition, le HLEG AI a mis au point plusieurs livrables thématiques pour permettre à la Commission européenne de travailler sur la base de définitions et d'objectifs clairement établis.

Le premier livrable, publié en avril 2019339(*), fixe les lignes directrices en matière d'éthique de l'IA qui permettraient d'arriver à une « IA digne de confiance »340(*). Le groupe considère que pour qu'une technologie d'IA soit considérée comme « digne de confiance », il lui faut réunir au moins trois de ces éléments :

- être licite (respecter les législations et réglementations existantes) ;

- être éthique, et assurer l'adhésion à des principes et valeurs éthiques ;

- être équitable, diverse et non discriminatoire ;

- être transparente ;

- permettre un contrôle humain ;

- être robuste techniquement et socialement et sécurisée ;

- être robuste pour ne pas causer de préjudices involontaires ;

- respecter la vie privée et la gouvernance des données ;

- participer au bien-être social et environnemental ;

- savoir qui est responsable sur toute la chaîne de valeur.

Ces exigences sont proches de celles préconisées par l'OCDE pour la mise en place d'une IA éthique.

Le second livrable du HLEG AI est une liste de recommandations en matière de politiques publiques et d'investissements, avec le même objectif de garantir une « IA de confiance ». Le document formule 33 recommandations pour orienter l'IA vers la durabilité, la croissance, la compétitivité et l'action341(*). Les investissements doivent s'appuyer sur quatre bases : le secteur privé, le secteur public, la société civile et la recherche. Le groupe identifie huit leviers que les pouvoirs publics peuvent utiliser pour développer le potentiel de l'IA : l'éducation et la formation, la gouvernance et la régulation, le financement et l'investissement, le secteur privé, la société civile, le secteur public, la recherche ainsi que les données et l'infrastructure. Ce document fait apparaître l'approche pluridisciplinaire que retient l'Union européenne : plutôt que de réguler un secteur en particulier, le HLEG AI estime que l'investissement doit être transversal et intégré.

Après la publication de ces deux premiers livrables, le groupe a mis en place un outil pratique d'évaluation342(*) qui permet de traduire les lignes directrices en techniques d'autoévaluation.

Enfin, le HLEG AI a réalisé un dernier livrable concernant une approche sectorielle de politiques publiques et d'investissement pour l'IA343(*). Ce dernier livrable était particulièrement destiné à l'Alliance européenne pour l'IA (European AI Alliance), une coalition créée par la Commission européenne en 2018 dans le but « d'ouvrir le dialogue sur l'intelligence artificielle ». Cette alliance est composée de 6 000 parties prenantes de la société civile européenne (citoyens, représentants des consommateurs et des entreprises, syndicats, établissements de recherche, autorités et experts).

Après la publication de ce dernier livrable, le mandat de l'AI HLEG est arrivé à son terme en juillet 2020 et seule l'Alliance a continué ses activités.

c) Le Livre blanc de la Commission européenne sur l'IA

La phase de consultation des experts et de la société civile organisée par les institutions européennes a été conclue par la publication par la Commission européenne d'un Livre blanc sur l'IA de 30 pages sous-titré « Une approche européenne axée sur l'excellence et la confiance »344(*) en février 2020. Il a été soumis à consultation publique jusqu'au 19 mai 2020 et discuté lors de la deuxième assemblée de l'Alliance européenne pour l'IA en octobre 2020.

Ce rapport souligne les bénéfices apportés par l'IA, mais aussi les risques de ces technologies. Il appelle donc à un cadre juridique spécifique pour l'IA en Europe, en vue de créer un « écosystème de confiance » unique en son genre, garantissant le respect des principes du droit de l'UE, notamment ceux qui protègent les droits fondamentaux et les droits des consommateurs, en particulier vis-à-vis des systèmes d'IA à haut risque. Avec ce cadre juridique, qui vise aussi à harmoniser les efforts aux niveaux européen, national et régional, par un partenariat entre les secteurs privé et public, l'UE pourra construire un « écosystème d'excellence » tout au long de la chaîne de valeur de l'IA.

Le livre blanc mentionne aussi quelques futures obligations pour les structures développant des systèmes d'IA à haut risque : s'assurer que les jeux de données limitent les risques et évitent les discriminations ; documenter les données utilisées pour entraîner les algorithmes, dont les techniques et méthodologies de conception et d'entraînement ; développer des systèmes robustes dès le stade de la conception puis pendant leur cycle de vie ; une supervision humaine permettant une intervention en temps réel et laissant la possibilité de désactiver le système.

Le Comité économique et social européen (CESE) a rendu un rapport sur ce livre blanc345(*), dont la rapporteure était Catelijne Muller, membre du Comité mais aussi présidente de l'ONG ALL AI et membre de l'AI HLEG de la Commission européenne. Il regrettait la focalisation du document sur la seule intelligence artificielle axée sur les données (l'IA connexionniste) et réclamait une nouvelle génération de systèmes d'IA fondés sur la connaissance et le raisonnement. Cette réflexion fait écho aux préoccupations de vos rapporteurs. Le CESE demandait notamment, outre un renforcement des investissements, une pluridisciplinarité dans la recherche, une approche socio-technique des technologies, une association de toutes les parties prenantes à la discussion et une éducation du grand public.

2. De la proposition de règlement du 21 avril 2021 à la juxtaposition de deux dispositifs à la suite des amendements adoptés

La législation européenne sur l'intelligence artificielle (ou AI Act) a pour origine une proposition de règlement du Parlement européen et du Conseil transmis par la Commission européenne le 21 avril 2021346(*). Après un dialogue entre les deux législateurs de l'Union et la Commission (appelé trilogue), un consensus autour d'un texte est trouvé le 9 décembre 2023.

Ce compromis est adopté par le Parlement européen le 13 mars 2024, puis par le Conseil de l'Union européenne le 21 mai 2024347(*). Ce projet est devenu le règlement du 13 juin 2024 établissant des règles harmonisées concernant l'intelligence artificielle.

Une évolution importante doit être notée entre le texte initial et la version finale du règlement à la suite des amendements adoptés lors de la discussion du projet de la Commission européenne par le Conseil et le Parlement européen. Le dialogue entre les institutions européennes est un processus habituel au sein du processus législatif de l'Union européenne où des compromis doivent être trouvés pour obtenir une position acceptable par la Commission, le Conseil et le Parlement.

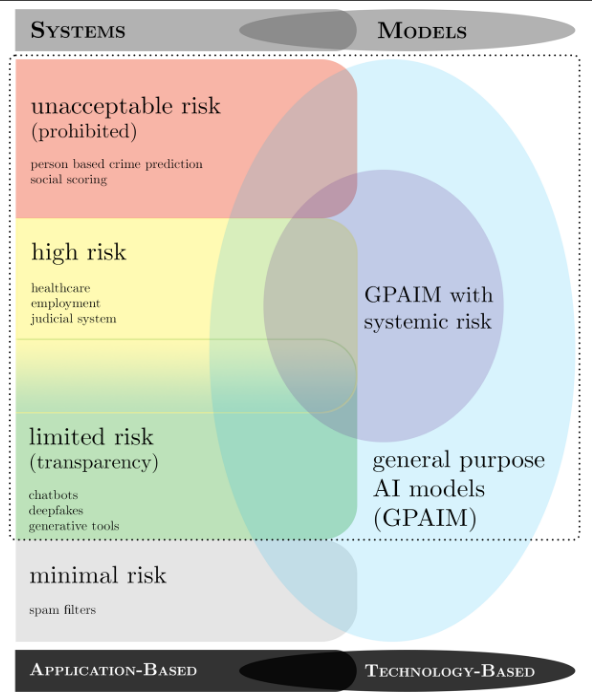

Toutefois, le dialogue entre les institutions européennes a dans ce cas précis mené à un texte final assez différent du texte initialement proposé par la Commission européenne. Alors que le premier texte visait une régulation de l'IA orientée vers les usages de la technologie plutôt que vers la technologie elle-même, selon des niveaux de risques, le Conseil et le Parlement européen ont ajouté des dispositions différentes de cette approche initiale : en effet, il a été décidé que certains « modèles à usage général », en l'occurrence surtout les modèles de fondation les plus puissants, fassent l'objet d'un encadrement plus strict par l'AI Act, parfois du simple fait de la puissance de calcul nécessaire à l'entraînement du modèle. Ainsi, il est possible de séparer au sein des dispositions du texte final les dispositions initialement prévues par la Commission européenne et les ajouts du Parlement européen et du Conseil.

a) Le volet issu du projet initial d'AI Act en 2021 : une régulation des usages selon leurs risques plutôt qu'une régulation de la technologie elle-même

La première partie du texte présente le projet initial de règlement, à savoir une régulation de l'IA basée sur le niveau de risque engendré par son utilisation et non par la technologie elle-même. Ainsi, la technologie n'est pas considérée comme dangereuse ou risquée en elle-même, mais pourrait l'être dans certains contextes d'utilisation. Les obligations pèsent sur les fournisseurs, les déployeurs, les fabricants et les mandataires de fournisseurs de systèmes d'IA348(*).

L'article 5 liste un certain nombre de pratiques totalement interdites en matière d'intelligence artificielle car estimées causer un « risque inacceptable ». Il s'agit notamment de l'évaluation des personnes physiques associée à un système de crédit social ou social ranking, de la reconnaissance faciale, ou encore de la reconnaissance des émotions sur le lieu de travail.

Pour les autres usages des systèmes d'IA, il existe une gradation du niveau de risque lié à leur utilisation, qui implique des règles plus contraignantes à mesure que le niveau de risque augmente.

Les usages licites présentant niveau de « risque élevé » font l'objet des dispositions les plus rigoureuses et sont décrits à l'article 6 du texte. Il s'agit des IA utilisées dans les domaines de biométrie, d'infrastructures critiques, d'éducation et formation professionnelle, d'emploi, de gestion des travailleurs et d'accès à l'emploi indépendant, d'accès et jouissance de services privés essentiels et de services et prestations publiques essentiels, des services répressifs, de gestion de la migration, de l'asile et des contrôles aux frontières ainsi que d'administration de la justice et de processus démocratiques. L'article 7 du règlement donne le droit à la Commission de modifier la liste de ces critères.

Les systèmes d'IA dont les usages ne présentent qu'un « risque limité » sont soumis à des obligations de transparence plus légères : les développeurs et les déployeurs doivent s'assurer que les utilisateurs finaux sont conscients qu'ils interagissent avec une IA (article 50)349(*).

Il est intéressant de noter que le centre de recherche sur les modèles de fondation (Center for Research on Foundation Models ou CRFM) de l'Université de Stanford a publié une analyse évaluant la conformité des différents modèles de fondation existants avec ce premier volet du projet de règlement350(*).

b) Le volet ajouté par les co-législateurs : la régulation des modèles de fondation assortie d'un régime spécifique pour les modèles les plus puissants, dits « à risque systémique »

Le Parlement européen a décidé d'ajouter au texte initial de la Commission une réglementation qui ne vise pas seulement les risques liés aux usages de l'IA mais la technologie et ses modèles en eux-mêmes, ce qui se rapproche de la réflexion conduite au sein de l'université de Stanford ainsi que de la réglementation américaine de 2023. Le Conseil et le Parlement européen ont ainsi introduit la notion de « modèle d'IA à usage général » (general-purpose artificial intelligence model ou GPAIM).

Cette notion est définie au point (63) de l'article 3 du texte :

« Modèle d'IA, y compris lorsqu'il est entraîné à l'aide d'une grande quantité de données en utilisant l'autosupervision à l'échelle, qui présente une grande généralité et est capable d'exécuter avec compétence un large éventail de tâches distinctes, quelle que soit la manière dont le modèle est mis sur le marché, et qui peut être intégré dans divers systèmes ou applications en aval, à l'exception des modèles d'IA utilisés pour des activités de recherche, de développement ou de prototypage avant d'être mis sur le marché ».

Dès lors qu'un modèle d'intelligence artificielle est considéré comme étant à usage général, il doit suivre les règles minimales visées à l'article 50 du règlement.

Au-delà, le régime juridique applicable dépend de son éventuelle catégorisation en « IA à usage général présentant un risque systémique ». L'article 51 prévoit en effet qu'un GPAIM est ainsi catégorisé si l'une des deux conditions suivantes est remplie :

- il a « des capacités d'impact élevées, évaluées sur la base d'outils et de méthodologies techniques appropriés, y compris des indicateurs et des critères de référence », ce qui implique pour le fournisseur du GPAIM de procéder aux évaluations nécessaires et de le notifier à la Commission ;

- sur la base d'une décision de la Commission, d'office ou à la suite d'une alerte qualifiée du groupe scientifique, il a des capacités ou un impact équivalents à ceux visés au point [précédent], compte tenu des critères énoncés à l'annexe XIII ».

Les sept critères de l'annexe XIII351(*) permettant d'évaluer l'impact des modèles d'intelligence artificielle sont les suivants :

- le nombre de paramètres du modèle ;

- la qualité et la taille des données d'entraînement ;

- la quantité de calcul utilisée pour l'apprentissage ;

- les modalités d'entrée et de sortie du modèle ;

- l'évaluation des capacités du modèle ;

- l'impact du modèle sur le marché intérieur ;

- le nombre d'utilisateurs finaux.

L'article 51 établit également une présomption d'impact élevé, donc de risque systémique, lorsque le volume cumulé de calcul utilisé pour l'apprentissage du modèle est supérieur à 1025 opérations à virgule flottante par seconde (FLOPS).

Le droit américain avec l'Executive Order de 2023 a quant à lui prévu des obligations de déclaration plus souples, avec un seuil de puissance de calcul dix fois plus grand, soit 1026.

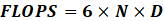

Calculer les FLOPS utilisés pour l'entraînement d'un modèle

Le site Medium352(*) présente une heuristique pour calculer approximativement le nombre de FLOPS utilisés pour l'entraînement d'un modèle sur la base d'une publication scientifique d'OpenAI353(*).

La formule utilisée est la suivante :

avec N correspondant au nombre de paramètres et D au nombre de tokens utilisés pour l'entraînement.

Par exemple, le modèle Llama 3 8B de Meta a huit milliards de paramètres et a été entraîné avec quinze milliards de tokens. En appliquant cette formule, une approximation du nombre de FLOPS utilisés pour l'entraînement du modèle peut faire l'objet d'un calcul :

Sur la base de cette heuristique, le modèle LLama 3 8B se situe juste au-dessous du seuil et ne correspond donc apparemment pas à une IA à usage général présentant un risque systémique au sens de l'AI Act et encore moins au sens de l'Executive order américain. Pour mémoire, les modèles de pointe d'OpenAI ou de Google dépassent depuis 2023 le seuil de 1025 FLOPS, avec GPT-4 d'une part et Gemini d'autre part.

Sur la base de cette condition automatique et des sept critères permettant de juger du niveau d'impact d'un modèle, la Commission européenne peut, d'office ou à la suite d'une alerte qualifiée du groupe scientifique, faire entrer un modèle d'IA dans la catégorie des IA à usage général présentant un risque systémique.

Les modèles à usage général présentant des risques systémiques sont soumis à des obligations particulières. Ces obligations sont au nombre de quatre et sont définies à l'article 55 du règlement. Ainsi, les fournisseurs de GPAIM présentant un risque systémique doivent :

- procéder à l'évaluation du modèle conformément à des protocoles et à des outils normalisés reflétant l'état de l'art, y compris effectuer et documenter des tests contradictoires du modèle en vue d'identifier et d'atténuer les risques systémiques ;

- évaluer et atténuer les éventuels risques systémiques au niveau de l'Union, y compris leurs sources, qui peuvent résulter du développement, de la mise sur le marché ou de l'utilisation de modèles d'IA à usage général présentant un risque systémique ;

- garder trace, documenter et rapporter, sans délai injustifié, au bureau de l'IA et, le cas échéant, aux autorités nationales compétentes, les informations pertinentes concernant les incidents graves et les mesures correctives possibles pour y remédier ;

- assurer un niveau adéquat de protection de cybersécurité pour les modèles d'IA à usage général présentant un risque systémique et pour l'infrastructure physique du modèle.

Dans la pratique, ces obligations seront assurées par l'élaboration et le respect de « codes de conduite » définis à l'article 56 du règlement. Le respect de ces obligations sera également assuré par des normes auxquelles les fournisseurs d'IA présentant des risques systémiques devront se conformer.

Les critiques concernant l'AI Act portent principalement sur cette seconde partie du texte relative aux IA à usage général, qui a provoqué un blocage de la part de la France et de l'Allemagne354(*).

En effet, la France et l'Allemagne, qui accueillent des entreprises créant des modèles de fondation comme MistralAI en France ou Aleph Alpha en Allemagne, craignaient que cette nouvelle portée de la réglementation freine l'innovation et donc la compétitivité de leurs entreprises.

Lors de leurs auditions, vos rapporteurs ont pu remarquer que les critiques de l'AI Act se maintiennent autour de cette partie du texte. Gilles Babinet, coprésident du Conseil national du numérique (CNNum) a par exemple pointé le caractère ex ante de la réglementation, alors qu'à l'heure actuelle on prédit mal les effets des systèmes d'IA sur le marché économique. Il considère qu'une telle réglementation précoce a tendance à favoriser les « gros » acteurs américains face aux entreprises européennes naissantes. Joëlle Tolédano, coprésidente du CNNum et économiste, a rejoint l'avis de Gilles Babinet en pointant du doigt le déséquilibre entre les coûts nécessaires au respect des normes visant à réguler les modèles d'IA à risque systémique et le chiffre d'affaires des nouvelles entreprises de l'IA comme Mistral, moindre que celui des géants américains.

Yoshua Bengio a dénoncé la référence aux FLOPS utilisés pour l'entraînement du modèle comme mesure de calcul alors que les modèles deviendront de plus en plus performants, et de ce fait pourront utiliser beaucoup moins de puissance de calcul pour leur entraînement tout en parvenant à des résultats bien plus impressionnants.

Cette partie du règlement sur l'intelligence artificielle ne soulève toutefois pas que des critiques. Plusieurs personnes auditionnées ont souligné l'intérêt de soumettre les entreprises d'intelligence artificielle à des normes, y compris en termes de régulation des modèles, comme les chercheurs en informatique, IA et robotique Laurence Devillers, Serge Abiteboul ou Raja Chatila.

Florence G'sell, rencontrée à l'Université de Stanford, a résumé l'AI Act dans un graphique qui représente bien la dualité de son dispositif - une dualité non exclusive qui conduit donc à des chevauchements possibles en pratique - rendant encore plus complexe la mise en oeuvre du règlement.

Le double dispositif de l'AI Act : systèmes vs modèles d'IA

Source : Rapport de Florence G'sell, Université de Stanford, op. cit.

c) Les autres aspects de l'AI Act : une polysynodie institutionnelle, une portée extraterritoriale, un calendrier très complexe et une normalisation désinvestie

La polysynodie caractérise le dispositif institutionnel qui accompagne l'AI Act. Ce dernier confie la mise en oeuvre des diverses dispositions du règlement à plusieurs structures dont la majorité aura une fonction de conseil plutôt qu'à la seule Commission européenne, qui aurait pu s'en acquitter elle-même en s'appuyant sur sa DG Connect.

La première sera une structure exécutive, par autonomisation au sein de la Commission européenne d'une de ses directions qui devient le Bureau européen de l'IA ou EU AI Office, composé de cinq unités et de deux conseillers. Ce nouveau centre d'expertise, dont la moitié des agents correspond à de nouveaux recrutements, a la capacité de procéder à des évaluations des modèles d'IA à usage général, de demander des informations et des mesures aux fournisseurs de modèles (y compris les codes sources des modèles et les API, mais le dialogue en amont sera privilégié) et d'appliquer le cas échéant des sanctions. La Commission européenne doit également mettre en place :

- un Conseil européen de l'IA ou European Artificial Intelligence Board, composé de représentants des États membres, qui doit conseiller la Commission européenne ainsi que le Bureau européen de l'IA et les autorités de régulation des États membres ;

- un Forum européen consultatif sur l'IA ou European Artificial Intelligence Advisory Forum qui doit conseiller le Conseil européen de l'IA, la Commission européenne et le Bureau européen de l'IA ;

- un Panel scientifique européen d'experts en IA ou European Artificial Intelligence Scientific Panel of Independent Experts qui doit conseiller le Bureau européen de l'IA spécialement sur les modèles d'IA à usage général et les risques systémiques afin de pouvoir classifier les différents modèles et systèmes d'IA. C'est lui qui aidera à définir les outils, les méthodologies et les tests pertinents. Il pourra aussi éclairer les autorités de surveillance des marchés et les autorités de régulation des États membres. Enfin, il alertera le Bureau européen de l'IA en cas de modèles d'IA à usage général à risque systémique selon la réglementation de l'UE.

S'agissant de la portée extraterritoriale du règlement, il faut souligner que l'AI Act s'applique non seulement à tout acteur qui fournit, distribue ou déploie des systèmes d'IA utilisés dans l'UE, qu'ils soient conçus dans l'UE ou dans un pays tiers, mais couvre aussi le champ des systèmes d'IA conçus et utilisés hors UE si les résultats générés par le système sont destinés à être utilisés dans l'UE.

Le calendrier de mise en oeuvre des dispositions du règlement frappe par sa très grande complexité : de 2024 à 2031, différentes étapes de déploiement de l'AI Act rythment chaque année. Parler d'usine à gaz est à cet égard un euphémisme.

Le calendrier très complexe de mise en oeuvre de l'AI Act

Le règlement du 13 juin 2024 établissant des règles harmonisées concernant l'intelligence artificielle est publié au Journal officiel de l'Union européenne le 12 juillet 2024. Il s'agit de sa notification officielle. Le 1er août 2024 est la date de son entrée en vigueur, donc de son application mais en fait, ses dispositions ne s'appliqueront que plus tard et progressivement. Le 2 novembre 2024 est la date théorique d'expiration du délai au terme duquel les États membres identifient et rendent publique la liste des autorités nationales responsables de la protection des droits fondamentaux et en informent la Commission et les autres États membres.

Les interdictions relatives à certains systèmes d'IA (prévues aux chapitres I et II) commencent à s'appliquer le 2 février 2025. Le 2 mai 2025 les codes de bonnes pratiques de la Commission doivent être prêts. Les règles relatives aux organismes notifiés (chapitre III, section 4), aux modèles d'IA à usage général (chapitre V), à la gouvernance (chapitre VII), à la confidentialité (article 78) et aux sanctions (articles 99 et 100) commencent à s'appliquer le 2 août 2025. À la même date, si le code de pratique ne peut être finalisé ou si l'AI Office le juge inadéquat, la Commission peut fournir des règles communes pour la mise en oeuvre des obligations des fournisseurs de modèles d'IA à usage général par le biais d'actes d'exécution. Toujours le 2 août 2025, les États membres désignent les autorités nationales compétentes (autorités de notification et autorités de surveillance du marché), les communiquent à la Commission et mettent leurs coordonnées à la disposition du public ; fixent les règles relatives aux sanctions et aux amendes, les notifient à la Commission et veillent à ce qu'elles soient correctement mises en oeuvre ; et font rapport à la Commission sur l'état des ressources financières et humaines des autorités nationales compétentes. Les fournisseurs de modèles d'IA à usage général mis sur le marché ou mis en service avant cette date doivent à partir du 2 août 2025 commencer à se conformer aux exigences du règlement, avec l'horizon d'une conformité d'ici le 2 août 2027.

Avant le 2 février 2026, la Commission doit fournir des lignes directrices précisant la mise en oeuvre pratique de l'article 6, y compris le plan de surveillance après la mise sur le marché. Le 2 août 2026, les autres dispositions du règlement sont applicables, à l'exception de l'article 6, paragraphe 1. Le règlement s'applique aux exploitants de systèmes d'IA à haut risque (autres que les systèmes visés à l'article 111, paragraphe 1), mis sur le marché ou mis en service avant cette date. Toutefois, il ne s'applique qu'aux systèmes dont la conception est modifiée de manière significative à partir de cette date. À la même date, les États membres veillent à ce que leurs autorités compétentes aient mis en place au moins un bac à sable réglementaire opérationnel en matière d'IA au niveau national.

Le 2 août 2027, les fournisseurs de modèles d'IA à usage général mis sur le marché avant le 2 août 2025 doivent avoir pris les mesures nécessaires pour se conformer aux obligations prévues par le règlement avant cette date. Les systèmes d'IA composants de systèmes d'information à grande échelle qui ont été mis sur le marché ou mis en service avant cette date doivent être mis en conformité avec le règlement d'ici au 31 décembre 2030.

Le 2 août 2028, la Commission évalue le fonctionnement de l'AI Office et l'impact et l'efficacité des codes de conduite volontaires (puis tous les trois ans). La Commission évalue et fait rapport au Parlement européen et au Conseil sur la nécessité de modifier les rubriques de l'annexe III, le système de supervision et de gouvernance et la liste des systèmes d'IA nécessitant des mesures de transparence supplémentaires à l'article 50. La Commission présente enfin un rapport sur l'état d'avancement des « résultats de la normalisation » qui couvrent le thème du développement économe en énergie de modèles d'IA à usage général. Ce rapport doit être soumis au Parlement européen et au Conseil, et rendu public.

Le 1er décembre 2028 (soit 9 mois avant le 1er août 2029), la Commission doit établir un rapport sur la délégation de pouvoir décrite à l'article 97.

Le 1er août 2029, le pouvoir de la Commission d'adopter les actes délégués prévus par huit articles expire, à moins que cette période ne soit prolongée : la délégation de pouvoir sera alors, par défaut, prolongée pour des périodes récurrentes de 5 ans, à moins que le Parlement européen ou le Conseil ne s'oppose à cette prolongation trois mois ou plus avant la fin de chaque période.

Le 2 août 2029 (puis tous les quatre ans), la Commission présente au Parlement européen et au Conseil un rapport sur l'évaluation et le réexamen du règlement.

Les fournisseurs et déployeurs de systèmes d'IA à haut risque destinés à être utilisés par les autorités publiques doivent avoir pris avant le 2 août 2030 les mesures nécessaires pour se conformer aux exigences et aux obligations du règlement.

Le 31 décembre 2030 est la date limite pour la mise en conformité avec le règlement des systèmes d'IA composants de systèmes d'information à grande échelle qui ont été mis sur le marché ou mis en service avant le 2 août 2027.

Enfin, le 2 août 2031, la Commission procède à une évaluation de l'application du règlement et fait rapport au Parlement européen, au Conseil et au Comité économique et social européen.

Source : d'après le site https://artificialintelligenceact.eu/fr/implementation-timeline/

Le texte du règlement donne une place importante à la normalisation technique des produits utilisant l'IA. Cette normalisation doit garantir des standards de qualité et donc d'assurer une confiance envers ces produits pour lesquels les citoyens semblent, pour l'heure, relativement méfiants. Ces dix normes harmonisées auront aussi pour rôle de vérifier si un système d'IA correspond a priori aux obligations prévues au règlement : un système qui respecte ces normes sera en effet supposé conforme à l'AI Act.

Plusieurs spécialistes entendus par vos rapporteurs ont exprimé leur intérêt pour le processus de normalisation technique introduit par la seconde partie de l'AI Act. Yann Ferguson, sociologue directeur scientifique du LaborIA d'Inria ainsi que Patrick Bezombes, conseiller pour la stratégie et la gouvernance de l'IA à l'Association française de normalisation (Afnor) et représentant de la France au CEN-CENELEC ont défendu ce point de vue.

Selon eux, il faut considérer deux catégories d'entreprises : d'une part, les entreprises industrielles « classiques », Patrick Bezombes parle d'entreprises de la « safety », d'autre part, les nouvelles entreprises du numérique. Ces deux types d'entreprises ne voient pas de la même façon le développement de leurs produits. Les entreprises classiques de l'industrie comme Airbus, Alstom ou Framatome sont habituées à une normalisation stricte de leurs process de production, normalisation nécessaire dans leur propre intérêt pour garantir la sécurité essentielle de leurs produits et leur réputation. Ainsi, lorsque leurs produits arrivent sur le marché, le risque de défaillance est minime : la moindre panne d'un avion, d'un train ou d'un réacteur nucléaire serait catastrophique pour leur image et la confiance des consommateurs.

À l'inverse, les nouvelles entreprises du numérique, notamment les MAAAM, sont moins confrontées à ce type de problèmes, et s'autorisent des marges d'erreur élevées, d'autant plus qu'elles peuvent se permettre la mise sur le marché de produits présentant des défauts qui pourront être corrigés par la suite, grâce à une mise à jour logicielle. Dans ces entreprises, la culture de respect des normes est moins développée que dans les entreprises classiques, surtout celles du secteur industriel, où elle est présente dans toutes les étapes de la conception à la fabrication des produits.

De ce point de vue, le règlement sur l'intelligence artificielle peut être perçu comme un moyen d'encourager les entreprises du numérique à changer de culture et à respecter des normes strictes lorsqu'elles commercialisent un produit. Patrick Bezombes a particulièrement rappelé l'importance de ces normes qui permettent de créer de la confiance envers un produit, ce qui est essentiel pour la présence sur un marché.

Il relativise l'idée selon laquelle cette normalisation pénaliserait les petites entreprises par rapport aux géants du numérique. En effet, une défaillance majeure d'un produit sur le marché provoque une crise de la confiance sur l'ensemble du marché, tant à l'égard des grandes entreprises que des plus petites. Le cas des véhicules autonomes l'illustre. Aussi, en limitant le risque de défaillances sur les produits utilisant de l'intelligence artificielle, la normalisation permet d'éviter ces crises de confiance. La confiance générée par cette normalisation, créatrice de stabilité, bénéficie à l'ensemble des acteurs du marché.

Pour mieux comprendre comment les normes relatives à l'IA sont en train d'être définies, il faut comprendre qui est chargé de cette normalisation.

En Europe, le Comité européen de normalisation (CEN) et le Comité européen de normalisation en électronique et en électrotechnique (CENELEC) sont chargés de préparer les normes relatives à l'IA prévues par l'AI Act. Un comité commun ou Joint Technical Committee (JTC CEN-CENELEC) a été mis en place pour l'IA, le JTC 21.

Il doit produire des livrables normatifs et des lignes directrices à destination des autres comités techniques concernés par l'intelligence artificielle. Ce JTC doit également examiner l'adoption éventuelle de normes internationales pertinentes ainsi que les normes d'autres organisations compétentes, comme celles du JTC ISO-IEC 1 et ses sous-comités, tels que le SC 42.

Patrick Bezombes, responsable IA à l'Afnor représente la France au JTC 21 du CEN-CENELEC, dont il est le vice-président. L'architecture complexe des organismes de normalisation est résumée dans le tableau suivant.

Tableau des agences de normalisation dans le monde, en Europe et en France

|

Normalisation des technologies de l'information |

Normalisation de l'électrotechnique |

Normalisation des télécommunications |

Autres organisations sectorielles |

|

|

Monde |

Joint technical committees (JTC) de l'ISO et de l'IEC. Son sous-comité 42 (SC 42) est chargé de la normalisation de l'IA |

Union internationale des télécommunications (UIT ou ITU), organe chargé de la normalisation des sujets de l'IT et de la communication en réseau |

Institute of Electrical and Electronics Engineers (IEEE) pour l'informatique Society of Automotive Engineers (SAE) pour les voitures autonomes |

|

|

International organization for standardization (ISO), chargée initialement des seuls sujets d'IT mais aujourd'hui chargée d'une normalisation plus large |

International Electrotechnical Commission ou Commission électrotechnique internationale (IEC ou CEI), chargée de la normalisation dans le secteur de l'électrotechnique |

|||

|

Europe |

CEN-CENELEC Management Centre (CCMC), secrétariat commun au CEN et au CENELEC Joint technical committees (JTC) dont le JTC CEN-CENELEC 21 sur l'IA |

European Telecommunications Standards Institute (ETSI), miroir de l'UIT au niveau européen (marginalisé depuis la crise sur les normes du système Galileo, n'intervient pas sur la normalisation prévue par l'AI Act) |

Aucun organisme reconnu officiellement par l'Union européenne |

|

|

Comité européen de normalisation (CEN), miroir de l'ISO au niveau européen |

Comité européen de normalisation en électronique et en électrotechnique (CENELEC), miroir de l'IEC au niveau européen |

|||

|

France |

Association française de normalisation (Afnor), représentant la France à l'ISO et au CEN-CENELEC en matière d'IA |

Union technique de l'électricité (UTE) Centre technique industriel (CTI) |

||

Légende : Les cases grisées sont des instances de normalisation communes, des JTC ISO-IEC ou CEN-CENELEC

La normalisation réalisée dans le cadre du CEN-CENELEC, notamment dans le JTC 21, loin d'être purement technique, reflète aussi des choix politiques et économiques. L'implication de la France et la qualité de sa participation au processus de normalisation dépendent des acteurs qui prennent part à ce processus pour notre pays ainsi que de l'investissement des pouvoirs publics dans ce travail.

Patrick Bezombes de l'Afnor déplore par exemple que le Comité français d'accréditation (Cofrac), chargé de certifier les entreprises respectant les normes, ne s'implique pas davantage dans les discussions relatives à la normalisation prévue par l'AI Act.

Il invite également à se méfier des positions tenues par des pays qui n'ont pas fait le choix d'envoyer des représentants « indépendants » au sein du JTC, soit parce qu'ils n'ont pas d'entreprises nationales de taille importante dans le domaine de l'IA, soit parce que les entreprises étrangères, souvent américaines ou parfois chinoises, ont investi ce champ de la normalisation.

En effet, derrière la représentation des 26 autres États membres dans les comités de normalisation, Patrick Bezombes déplore qu'on retrouve souvent des représentants de grands groupes du numérique extra-européens qui défendent leurs intérêts et tentent d'influencer les discussions en faveur d'une standardisation plus légère, de moins bonne qualité et plus conforme à leurs intérêts et à leurs attentes envers l'UE.

Il a fourni à vos rapporteurs une liste éclairante des liens d'intérêt qui unissent plusieurs des membres du JTC 21 du CEN-CENELEC sur la normalisation de l'intelligence artificielle à des grandes entreprises étrangères du secteur du numérique.

Au total, le chantier stratégique de la normalisation est désinvesti par les gouvernements des États membres et par la Commission européenne alors qu'il devrait être surveillé de très près par les pouvoirs publics, les administrations nationales et les institutions européennes.

3. Une gouvernance européenne de l'IA à compléter

a) Mobiliser les entreprises et élaborer de la Soft Law : l'AI Pact et les bonnes pratiques

En amont de l'opposabilité des dispositions de l'AI Act, la Commission européenne a proposé en septembre 2024 un Pacte pour l'IA ou AI Pact reposant sur les engagements volontaires des entreprises afin de créer une communauté collaborative qui facilite la mise en oeuvre proactive de certaines mesures ainsi que la communication355(*).

Selon la page d'un site officiel du gouvernement, ce « pacte européen sur l'IA ressemble à une vaste blague »356(*). L'UE qui chercherait « par tous les moyens à rallier les entreprises à sa grande cause, à savoir l'application de son règlement sur l'intelligence artificielle » utiliserait ce pacte d'engagements volontaires « dont personne ne vérifiera s'ils sont respectés pour brosser ses signataires dans le sens du poil ». OpenAI serait même un « parfait exemple de l'hypocrisie » des grandes entreprises du numérique puisque « la société la plus en vogue du marché se targue de soutenir les priorités fondamentales du pacte » alors que son propre comité d'éthique, de sûreté et de sécurité est composé de membres de son conseil d'administration357(*).

Vos rapporteurs soulignent que plusieurs entreprises ont tout de même refusé de rejoindre ce pacte pourtant proposé sous la forme de simples engagements volontaires, marquant par-là leur opposition à la démarche de la Commission européenne, à l'instar d'Apple et de Meta358(*).

Parallèlement à ce Pacte pour l'IA, l'UE débute ses travaux sur la rédaction de codes de bonnes pratiques qui doivent aboutir au plus tard le 2 mai 2025. La Commission européenne et son Bureau de l'IA ont ainsi lancé le 30 septembre 2024 ces travaux, qui devraient s'appuyer sur un panel scientifique d'experts indépendants, avec notamment pour objectif de préciser les règles de classification et le cadre applicable aux modèles d'IA à usage général en distinguant parmi eux ceux présentant un risque systémique ; de proposer des outils d'évaluation des risques et des mesures d'atténuation ; d'établir des modalités de transparence et de respect des droits d'auteur.

b) Deux projets de directive complémentaires à l'AI Act : l'intelligence artificielle comme produit sur le marché unique

En parallèle de l'adoption de l'AI Act, les institutions européennes discutent de deux projets de directives pour définir des règles en matière de responsabilité civile extracontractuelle pour l'IA. Ces textes, qui ont pour objet de protéger les utilisateurs, sont complémentaires de l'AI Act - surtout axé sur la prévention des risques - et y renvoient directement359(*).

Alors que les règles nationales en matière de responsabilité pour faute obligent la victime à prouver l'existence d'un acte préjudiciable ou d'une omission de la part de la personne qui a causé le dommage, le fonctionnement des systèmes d'IA rend difficile une telle identification.

Ceci est particulièrement préoccupant pour les TPE et PME qui ne peuvent pas se permettre d'avancer des frais dans une procédure pour obtenir des réparations. Ainsi, il est proposé d'adapter la politique de responsabilité du producteur du fait des produits défectueux en visant une harmonisation des régimes de responsabilité pour l'IA au sein de tous les pays de l'UE.

La directive 2022/0302360(*) est une révision de la directive 85/374/CEE. Elle considère les systèmes d'IA et les biens dotés d'IA comme des « produits » sur le marché. De ce fait, les personnes lésées par un système d'IA défectueux peuvent obtenir des réparations sans qu'elles n'aient à prouver la faute du fabricant. Le demandeur doit prouver la défectuosité du produit, le dommage subi et le lien de causalité entre la défectuosité et le dommage.

La directive 2022/0303361(*) introduit de nouveaux concepts dans le cas de responsabilité civile en réparation de dommages causés par une faute extracontractuelle. La logique de cette directive est proche de celle citée ci-dessus, elle vise aussi à faciliter l'obtention de réparations. D'une part, un demandeur lésé peut demander la divulgation d'éléments de preuve de la part du défendeur qui opère un système d'IA, d'autre part, si cette demande n'est pas satisfaite, il y a présomption de non-respect du devoir de vigilance pour le défendeur.

Le demandeur qui a été lésé peut en effet saisir les juridictions nationales pour qu'elles ordonnent la divulgation d'éléments de preuve pertinents concernant un système d'IA à haut risque soupçonné d'avoir causé un dommage. Pour cela, le demandeur doit présenter des éléments de preuve suffisants pour étayer la plausibilité d'une action en réparation. Un défendeur qui ne divulguerait pas ces informations aux instances compétentes serait présumé avoir manqué à son devoir de vigilance pertinent, ce qui constitue une faute, à moins qu'il ne parvienne à renverser cette présomption.

Par cette présomption réfragable, les juridictions nationales présument le lien de causalité entre la faute du défendeur et le résultat produit par un système d'IA ou son incapacité à produire un résultat. Pour cela, les trois conditions prévues à l'article 4 de la directive doivent être remplies :

- le demandeur ou la juridiction a présumé la faute du défendeur de manquement à son devoir de vigilance ;

- l'influence de la faute sur le résultat du système d'IA ou son incapacité à produire un résultat est « raisonnablement probable » ;

- le demandeur a pu prouver que le dommage a pour origine le résultat du système d'IA ou son incapacité à produire un résultat.

Dans le cas des IA à risque élevé, le manquement du défendeur à son devoir de vigilance est encore plus facile à démontrer pour le demandeur : il suffit que ces systèmes ne respectent pas les obligations fixées par la réglementation sur l'IA. Ces systèmes doivent être transparents, pouvoir être contrôlés, avoir un niveau approprié d'exactitude et pouvoir être rappelés ou retirés.

c) Le soutien européen à la recherche et à l'innovation en IA au-delà du dispositif EuroHPC

EuroHPC est l'entreprise commune pour le calcul à haute performance européen (European high-performance computing joint undertaking ou EuroHPC). Cette entreprise est un partenariat public-privé créé par un règlement de l'Union européenne du 28 septembre 2018362(*), permettant la mise en commun de ressources à l'échelle européenne. L'objectif de l'entreprise est défini à l'article 3 du règlement : « La mission de l'entreprise commune est de créer, de déployer, d'étendre et de conserver dans l'Union une infrastructure intégrée de supercalcul et de données de classe mondiale, ainsi que de mettre en place et de soutenir un écosystème hautement compétitif et innovant en matière de calcul à haute performance ».

Pour financer ces infrastructures, l'Union européenne investit 486 millions d'euros et les États membres s'engagent à contribuer chacun à hauteur de 10 millions d'euros au minimum. Les entreprises privées, quant à elles, doivent financer à due proportion l'EuroHPC. Le texte distingue deux types de supercalculateurs selon leur puissance de calcul : les pétaflopique (de 1 pétaflop, soit 1015 FLOPS, à 100 pétaflops soit 1017 FLOPS), d'une part, et les pré-exaflopique (de 100 pétaflops à un exaflop, soit 1018 FLOPS), d'autre part. L'entreprise permet aux pays de financer 50 % des coûts d'acquisition et 50 % des coûts d'exploitation des supercalculateurs pré-exaflopiques et 35 % des coûts d'acquisition des supercalculateurs pétaflopiques.

En contrepartie de ces financements, l'Union européenne dispose de 50 % du temps d'accès aux supercalculateurs, proportionnellement à sa contribution financière, qu'elle distribue entre chaque État membre participant au consortium européen.

Le soutien européen à la recherche et à l'innovation en IA s'étend également à d'autres initiatives. Le 10 septembre 2024, la Commission européenne a lancé un appel à propositions pour la mise en place de fabriques d'IA ou AI Factories. Un réseau européen d'écosystèmes d'IA conjuguant puissance de calcul, accès aux données et talents des développeurs devrait ainsi éclore en 2026. La Commission européenne compte sur l'accélération du développement d'espaces européens communs des données, mis à la disposition de la communauté de l'IA.

L'Union européenne a également annoncé au début de l'année 2024 un soutien financier à l'IA générative, accordé par la Commission dans le cadre d'Horizon Europe et du programme pour une Europe numérique. Ce paquet mobiliserait environ 4 milliards d'euros d'investissements publics et privés d'ici à 2027.

Dans la continuité du consortium « AI4EU » lancé en 2019, l'initiative « GenAI4EU » devrait soutenir le développement de nouveaux cas d'utilisation et d'applications émergentes liés à l'IA générative dans 14 écosystèmes industriels européens, ainsi que dans le secteur public. Les domaines d'application comprennent la robotique, la santé, les biotechnologies, l'industrie manufacturière, la mobilité, le climat et les mondes virtuels.

L'Union européenne poursuivra par ailleurs la promotion des investissements publics et privés dans les start-up dans le domaine de l'IA, à l'aide de soutien en capital-risque ou en fonds propres, y compris au moyen de nouvelles initiatives dans le cadre du programme d'accélération du CEI et d'InvestEU.

En outre, deux consortiums pour une infrastructure numérique européenne (EDIC) sont mis en place : d'une part, une Alliance pour les technologies du langage (ALT-EDIC qui doit promouvoir la diversité linguistique et la richesse culturelle de l'Europe et soutenir l'élaboration de grands modèles de langage européens par une infrastructure commune remédiant à la pénurie de données langagières européennes pour l'entraînement des IA), d'autre part l'EDIC «CitiVERSE», qui utilisera des outils d'IA de pointe pour les Smart Cities afin de mettre au point des jumeaux numériques, aidant les villes à simuler et à optimiser certaines de leurs politiques, notamment la gestion des transports et des déchets.

* 335 Journal officiel de l'Union européenne (JOUE) le 12 juillet 2024 : https://eur-lex.europa.eu/legal-content/FR/TXT/?uri=OJ:L_202401689

* 336 Communication de la Commission européenne, au Parlement européen, au Conseil, au comité économique et social européen et au comité des régions « L'intelligence Artificielle Pour l'Europe », avril 2018 : https://digital-strategy.ec.europa.eu/en/library/communication-artificial-intelligence-europe

* 337 Communication sur le plan coordonné dans le domaine de l'intelligence artificielle actualisée en 2021 : https://digital-strategy.ec.europa.eu/en/library/coordinated-plan-artificial-intelligence-2021-review et première version de 2018 : https://eur-lex.europa.eu/legal-content/FR/TXT/?uri=COM:2018:795:FIN

* 338 Cf. la communication d'avril 2018 de la Commission précitée.

* 339 « Lignes directrices en matière d'éthique pour une IA digne de confiance », 2019 : https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai

* 340 La notion d'IA digne de confiance est souvent utilisée, particulièrement par les organisations internationales qui peuvent traduire ce terme ou conserver le terme anglais de Trustworthy AI

* 341 « Policy and investment recommendations for trustworthy AI », 2019, https://digital-strategy.ec.europa.eu/en/library/policy-and-investment-recommendations-trustworthy-artificial-intelligence

* 342 « Évaluation finale pour une IA digne de confiance (ALTAI) », 2019 : https://digital-strategy.ec.europa.eu/en/library/assessment-list-trustworthy-artificial-intelligence-altai-self-assessment

* 343 « Considérations sectorielles sur les recommandations en matière de politique et d'investissement », 2019, https://futurium.ec.europa.eu/en/european-ai-alliance/document/ai-hleg-sectoral-considerations-policy-and-investment-recommendations-trustworthy-ai

* 344 Livre blanc de la Commission européenne, 2020, « Intelligence artificielle. Une approche européenne axée sur l'excellence et la confiance » : https://commission.europa.eu/publications/white-paper-artificial-intelligence-european-approach-excellence-and-trust_en

* 345 Rapport du Comité économique et social européen en 2020 : https://www.eesc.europa.eu/fr/our-work/opinions-information-reports/opinions/livre-blanc-sur-lintelligence-artificielle

* 346 Proposition de règlement du Parlement européen et du Conseil du 21 avril 2021 établissant des règles harmonisées concernant l'intelligence artificielle et modifiant certains actes législatifs de l'Union : https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:52021PC0206

* 347 Rectificatif à la position du Parlement européen arrêté en première lecture le 13 mars 2024 en vue de l'adoption du règlement du Parlement européen et du Conseil établissant des règles harmonisées concernant l'intelligence artificielle : https://www.europarl.europa.eu/doceo/document/TA-9-2024-0138-FNL-COR01_FR.pdf

* 348 Cf. le champ d'application de l'AI Act défini dans son article 2 et les définitions des notions dans son article 3 : https://eur-lex.europa.eu/legal-content/FR/TXT/?uri=OJ:L_202401689

* 349 Cf. https://artificialintelligenceact.eu/fr/high-level-summary/

* 350 Cf. Rishi Bommasani et al., 2023, « Do Foundation Model Providers Comply with the Draft EU AI Act ? », Center for Research on Foundation Models, Stanford University : https://crfm.stanford.edu/2023/06/15/eu-ai-act.html

* 351 Cf. https://artificialintelligenceact.eu/fr/annex/13

* 352 Stevens, Ingrid. 2024. « Regulating AI: The Limits of FLOPs as a Metric ». Medium. https://medium.com/@ingridwickstevens/regulating-ai-the-limits-of-flops-as-a-metric-41e3b12d5d0c

* 353 Kaplan, Jared, Sam McCandlish, Tom Henighan, Tom B. Brown, Benjamin Chess, Rewon Child, Scott Gray, et al. 2020. « Scaling Laws for Neural Language Models ». http://arxiv.org/abs/2001.08361

* 354 Cf. Luca Bertuzzi, 2023, « AI Act : négociations bloquées à cause de divergences sur les modèles de fondation », in Euractiv : https://www.euractiv.fr/section/intelligence-artificielle/news/ai-act-negociations-bloquees-a-cause-de-divergences-sur-les-modeles-de-fondation/

* 355 La citation originale : « the Commission is promoting the AI Pact, to help stakeholders prepare for the implementation of the AI Act. The AI Pact, is structured around two pillars : gathering and exchanging with the AI Pact network, facilitating and communicating company pledges », cf. https://digital-strategy.ec.europa.eu/en/policies/ai-pact

* 356 Cf. la page suivante : https://www.bercynumerique.finances.gouv.fr/le-pacte-europeen-sur-lia-signe-par-une-centaine-dentreprises-ressemble-une-vaste-blague

* 357 Cf. cet article du 29 mai 2024 « Le Board d'OpenAI s'approprie les questions de sécurité et balaie les critiques d'anciens salariés » : https://www.usine-digitale.fr/article/le-board-d-openai-s-approprie-les-questions-de-securite-et-balaie-les-critiques-d-anciens-salaries.N2213540

* 358 Cf. cet article du 26 septembre 2024 « Apple and Meta snub AI safety pact. Amazon, Google, Microsoft and OpenAI among signatories of EU pact » : https://www.independent.co.uk/tech/apple-and-meta-snub-ai-safety-pact-b2619542.html

* 359 La prévention et la protection à l'égard des risques forment deux volets classiques des politiques de la maîtrise des risques.

* 360 Proposition de directive du Parlement européen et du Conseil relative à La responsabilité du fait des produits défectueux, 2022, https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A52022PC0495

* 361 Proposition de directive du Parlement européen et du Conseil relative à l'adaptation des règles en matière de responsabilité civile extracontractuelle au domaine de l'intelligence artificielle (directive sur la responsabilité en matière d'IA), 2022, https://eur-lex.europa.eu/legal-content/FR/ALL/?uri=CELEX:52022PC0496

* 362 Règlement (UE) 2018/1488 du Conseil du 28 septembre 2018 établissant l'entreprise commune pour le calcul à haute performance européen, 2018, http://data.europa.eu/eli/reg/2018/1488/oj/fra