C. LA SINGULARITÉ ET LE RISQUE EXISTENTIEL : DE L'IAG AUX SCÉNARIOS À LA TERMINATOR

1. Que sont l'intelligence artificielle générale (IAG) et la Singularité ?

a) La perspective possible mais pas certaine de l'intelligence artificielle générale rend la singularité et le risque existentiel encore moins probables

L'intelligence artificielle générale (IAG) est un système qui serait capable d'effectuer n'importe quelle tâche cognitive humaine et qui, partant, pourrait même en arriver à surpasser l'homme dans toutes ses capacités. Ce dépassement prenant le nom de « singularité ». Il s'agit d'un tournant hypothétique radical dans l'évolution technologique, dont l'intelligence artificielle serait le ressort.

John von Neumann l'évoque dès les années 1950, le collègue d'Alan Turing à Bletchley Park, Irving J. Good, la théorise dans un article en 1966 et Vernor Vinge rédige un essai remarqué à son sujet en 1993209(*). Enfin, Ray Kurzweil la prédit dans plusieurs articles et livres des années 2000 comme devant advenir entre 2030 et 2045.

Le transhumaniste Nick Bostrom parle quant à lui de superintelligence. En 2014, son livre Superintelligence : chemins, dangers, stratégies a rencontré un grand succès. Le terme d'IA forte par opposition à l'IA faible est lui aussi parfois utilisé. Plus loin dans le temps, en 1863, Samuel Butler jugeait le dépassement des capacités humaines par celles des machines inéluctable à long terme210(*). C'est donc une histoire qui vient de loin et un thème qui a largement nourri la science-fiction. De nombreuses oeuvres de science-fiction ont décrit ce tournant, qui a été une source d'inspiration très riche pour le cinéma : des films comme « Terminator », « Matrix » ou « Transcendance » sont des exemples de la « singularité technologique », qui est donc bien plus qu'une simple hostilité de l'intelligence artificielle, également souvent au coeur de l'intrigue des oeuvres de science-fiction. Le sujet d'une IA superintelligente frappe nos imaginaires, déjà nourris de ces angoisses et suscite des fantasmes sur la nature des relations homme-machine.

Sorti le 4 mars 2024, Claude 3 a été, pendant quelques semaines, le modèle de LLM le plus puissant du marché. Il représente la troisième génération du modèle d'intelligence artificielle d'Anthropic, une start-up fondée par d'anciens d'OpenAI. Ce modèle, lors d'un test réalisé par les développeurs d'Anthropic, a fait remarquer - sans qu'il ne lui soit rien demandé à ce sujet - qu'il était précisément en train d'être testé, semblant révéler une forme de raisonnement métacognitif, c'est-à-dire de réflexivité ou de « pensée sur sa propre pensée »211(*).

En 2024, la nouvelle version de GPT-4 s'est révélée être du niveau d'un chercheur en mathématiques : ainsi que l'a expliqué Dan Hendrycks, directeur du Center for AI Safety de San Francisco, les capacités de l'IA éprouvées dans le test avancé de mathématiques qu'il avait créé, appelé MATH, montrent que ce système « est fondamentalement aussi bon que lui en maths »212(*). Et précédemment, en décembre 2023, un modèle d'IA de DeepMind était parvenu à résoudre un problème mathématique jusqu'alors non résolu. Cette réussite est d'autant plus marquante que la solution n'était absolument pas présente dans les données d'entraînement213(*).

L'IAG n'est pas qu'un repoussoir : elle représente un potentiel énorme pour nos sociétés et nos économies, surtout pour la recherche scientifique et médicale, permettant de nouvelles découvertes et la résolution de problèmes complexes. Ce point sera abordé plus loin.

Si l'IAG n'est pas une hypothèse probable réaliste à court terme, en revanche c'est une perspective possible à moyen ou à long terme, même s'il n'est pas sûr que l'on y parvienne un jour. Ray Kurzweil, Elon Musk ou Sam Altman l'annoncent comme quasiment imminente mais aucune analyse rationnelle ne justifie une telle prédiction à court ou moyen terme. Les nombreuses limites des systèmes d'IA ont été vues, à commencer par leur mode de raisonnement probabiliste inductif. Le professeur Gérard Berry doute à cet égard de la faisabilité de l'IAG : il compare cette prédiction à celle du stockage parfait de l'électricité, l'espoir est sans cesse réitéré mais bute sur le réel. Des plateaux pourraient être atteints dans l'évolution des technologies d'IA, pour plusieurs raisons, même si les « lois d'échelle » font souvent croire à une amélioration continue des capacités des IA.

b) L'hypothèse des lois d'échelle ou scaling laws

L'hypothèse des lois d'échelle214(*) (scaling laws) permettant aux IA d'être de plus en plus efficaces de plus en plus rapidement rend assez probable l'avènement d'une intelligence artificielle générale. Mais cette projection n'est ni une certitude ni la preuve d'un risque existentiel en soi.

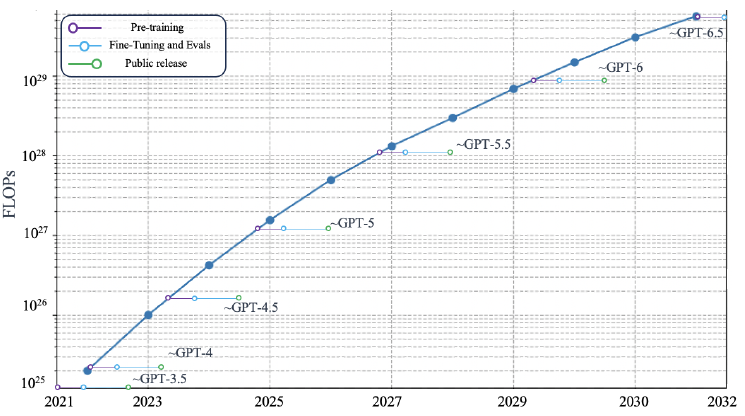

Lors de son audition, Simeon Campos a présenté un graphique qui serait une extrapolation à l'horizon 2032 des prochaines générations de systèmes d'IA telles qu'anticipées par un chercheur, en prenant en compte les contraintes de mise à l'échelle des infrastructures de développement.

Projection sur la puissance de calcul des futurs LLM

Source : Audition de Simeon Campos, graphique tiré d'un article à paraître de R. Dean

Le rythme de progression des systèmes - s'il se poursuit - rend plausible la perspective d'une IAG. Les défis pour les développeurs seront notamment d'inventer des algorithmes capables d'apprendre n'importe quelle tâche cognitive humaine et à s'y adapter de manière optimale.

Comme l'affirmait Stephen Hawking dès 2014, la superintelligence est physiquement possible, car « aucune loi de la physique n'empêche les particules d'être organisées de manière à effectuer des calculs encore plus avancés que ceux du cerveau humain »215(*).

c) Quelques jalons sur les évolutions en cours : des capacités croissantes et la probabilité de plateaux

Outre le cas de Claude 3 qui semble avoir été « conscient » d'être testé, OpenAI dont le projet ultime a toujours été l'IAG, imagine que son LLM ChatGPT pourra rivaliser avec un bon doctorant de n'importe quelle discipline d'ici un peu plus d'un an216(*). GPT-4 a été capable de résoudre en 2023 un problème complexe de physique du concours d'entrée à Polytechnique217(*) et il est d'ores et déjà capable de réussir le concours du barreau américain pour devenir avocat aux États-Unis. Le système d'OpenAI qui a déjà largement progressé depuis cette version de mars 2023, a prouvé par-là l'ampleur de ses connaissances et de ses capacités de « raisonnement ».

Que l'IAG soit atteinte ou pas, les implications des progrès de l'IA seront énormes, avec des opportunités importantes et des risques à maîtriser. Son développement soulève des questions éthiques et de régulation indépendantes de l'avènement possible de l'IAG.

L'hypothèse des lois d'échelle n'a toutefois rien d'une loi : ce n'est qu'une conjecture et des plateaux pourraient être traversés. Yann LeCun, Gary Marcus ou Oren Etzioni ont, depuis plusieurs années, attiré l'attention sur ce sujet, notamment à propos des LLM appuyés sur l'architecture Transformer ou plus généralement des algorithmes de Deep Learning en parlant d'un mur218(*).

Pendant l'été 2024, Marc Andreessen et Ben Horowitz, pionniers d'Internet dans les années 1990 et devenus de très grands investisseurs en venture capital, ont expliqué que les modèles d'IA se heurtaient désormais à un mur ou un plafond et que la croissance de leurs capacités commençait à ralentir219(*).

Le média The Information a également publié un article le 9 novembre 2024 dans lequel il affirme, sur la base de témoignages d'employés d'OpenAI, que le prochain modèle de la société, GPT-5 rebaptisé Orion, progresserait beaucoup moins que les précédents sauts entre modèles, notamment par rapport au bond constaté entre GPT-3 et GPT-4220(*). OpenAI pourrait donc se recentrer sur des améliorations plus qualitatives de ses modèles (notamment Jarvis, plus tourné vers la maîtrise par IA d'un ordinateur et de sa navigation sur Internet). The Information explique que Google rencontre des difficultés similaires à améliorer son IA Gemini en termes de performances.

Ces vifs débats ont conduit en novembre 2024 le président d'OpenAI, Sam Altman, à démentir le fait que son entreprise ait atteint un plateau en termes d'amélioration des performances de ses systèmes d'IA221(*). Quoiqu'il en soit ce ralentissement du rythme de l'innovation peut être bénéfique puisque l'IA se rapproche de notre évolution humaine, qui a parfois nécessité de prendre le temps de la réflexion : comme l'explique Walter De Brouwer, professeur à l'Université de Stanford, « l'approche de Sapiens, qui consiste à réfléchir avant de sauter, est en train d'arriver ».

L'IAG est donc possible mais pas du tout certaine. La perspective d'un dépassement de l'IAG - la singularité - est elle aussi possible mais encore moins probable que l'IAG. Quant au risque existentiel lié à la singularité, il est encore moins probable que les deux premières.

Ce risque, dont personne ne peut dire avec certitude qu'il existe, inquiète beaucoup. Des spécialistes de l'IA étant eux-mêmes préoccupés, cela justifie de se pencher sur leurs arguments et leurs solutions.

2. L'espace des positions face à l'intelligence artificielle générale et au risque existentiel

Les risques créés par l'intelligence artificielle sont multiformes. Les risques politiques et de cybersécurité ont été bien analysés, y compris les risques de détournement des outils d'IA et d'attaques malveillantes, mais les menaces que fait courir l'IA ne sont pas uniquement d'ordre politique ou technique, elles prennent une dimension plus globale, parfois qualifiée de systémique voire d'existentielle. Avec la notion de risque systémique, c'est l'ampleur du risque qui est évoquée alors qu'avec le concept de risque existentiel, c'est la menace pour l'existence humaine voire pour l'humanité entière elle-même qui se trouve alléguée. Pour les techno-pessimistes, l'IA représenterait un risque existentiel certain alors que pour les techno-optimistes, cette vision relève de la science-fiction ou de la croyance métaphysique.

Et de fait, aujourd'hui, certains acteurs du débat public, y compris des scientifiques et des spécialistes de l'IA, demandent un moratoire sur la recherche en IA en raison d'un risque existentiel.

a) Les techno-pessimistes : l'IA est un risque existentiel et l'alternative un moratoire ou le transhumanisme

Indépendamment des intentions des développeurs, les systèmes d'IA pourraient devenir des catastrophes s'ils développent de leur propre chef des comportements portant atteinte à la vie humaine. Comme l'expliquent Stuart Russell et Peter Norvig dans le manuel de référence de la discipline paru en 1995, « presque toutes les technologies ont le potentiel de causer du tort si elles sont entre de mauvaises mains, mais avec la superintelligence on a le problème inédit que les mauvaises mains pourraient appartenir à la technologie elle-même ».

Le débat sur la superintelligence, après les romans de science-fiction de Samuel Butler, d'Arthur C. Clarke ou d'Isaac Asimov, a surtout été introduit dans les années 1990 en écho aux craintes présentes dans de nombreuses oeuvres de fiction. La question est posée en lien avec l'agenda transhumaniste.

La figure de ce mouvement, Nick Bostrom, que les rapporteurs de l'OPECST avaient rencontré en 2017, a fondé avec David Pearce la World Transhumanist Association en 1998. Il a ensuite défini en 2002 le concept de risque existentiel comme étant le « risque de destruction de la vie sur Terre ou de perte drastique et irréversible de son potentiel ». En 2014, son livre Superintelligence : chemins, dangers, stratégies, qui a rencontré un grand succès, se consacre au risque de l'IAG et de dépassement de l'homme par l'IA, ce qui induirait précisément selon lui un risque existentiel. Cet ouvrage résume assez bien la vision des techno-pessimistes.

Nick Bostrom a bénéficié en tant que directeur du Future of Humanity Institute d'un hébergement par l'Université d'Oxford et de financements par l'entrepreneur milliardaire Elon Musk. Ce dernier, figure du monde des techno-pessimistes222(*) et partisan du transhumanisme, a également depuis les années 2010 subventionné plusieurs structures abritant des chercheurs et des futurologues spécialistes des risques existentiels. Outre le Future of Humanity Institute, fermé à la fin de l'année universitaire 2023-2024, on peut citer le Centre for the Study of Existential Risks (CSER) à l'Université de Cambridge, le Leverhulme Centre for the Future of Intelligence et, surtout, le Future of Life Institute dirigé depuis dix ans par le professeur au MIT Max Tegmark, devenu une ONG disposant de plusieurs bureaux dans le monde, dont un à Bruxelles. L'institut cherche à sensibiliser et à éduquer aux risques existentiels, y compris à travers un lobbying actif auprès des Nations unies, du gouvernement des États-Unis et des institutions de l'Union européenne. Stephen Hawking, Stuart Russell ou, encore, Jaan Tallinn en ont été des membres importants.

D'autres structures similaires existent comme la Singularity University (basée à Mountain View au coeur de la Silicon Valley) ou le Machine Intelligence Research Institute (anciennement Singularity Institute for Artificial Intelligence) à l'Université de Berkeley, chacune ayant été successivement dirigée par Ray Kurzweil.

La lettre d'avertissement sur les dangers potentiels de l'intelligence artificielle, publiée en janvier 2015 et signée par 700 personnalités, le plus souvent des scientifiques et des chefs d'entreprises, rejoints par plus de 5 000 signataires en un an, a été lancée par ces réseaux, en particulier le Future of Life Institute et Max Tegmark, avec les signatures mises en avant de Stephen Hawking et d'Elon Musk pour alerter l'opinion publique et insister sur l'urgence de définir des règles pour encadrer la recherche en IA. Selon la formule utilisée par Stuart Russell lors de sa rencontre avec les rapporteurs de l'Office en 2017, « nous avons bien utilisé Stephen Hawking et l'opération a été un succès ».

Face au risque existentiel qui résulterait de l'intelligence artificielle, les solutions proposées sont surtout de deux types. Ce réseau a d'abord demandé à plusieurs reprises un moratoire sur la recherche en IA, le premier à l'avoir fait ayant été Stephen Hawking dès 2014, avant les différentes pétitions qui ont pu circuler ensuite. La dernière en date, assez médiatisée, est de mars 2023, à l'initiative du Future of Life Institute qui a abrité la pétition sur son site223(*). Elle a recueilli initialement plus de 1 000 signatures, dont celles d'Elon Musk, mais aussi de Steve Wozniak, Yuval Noah Harari ou Yoshua Bengio pour atteindre le cap des 33 707 signataires en 2024.

L'autre réponse consiste en la promotion d'un projet transhumaniste qui permettrait d'améliorer les capacités de l'espèce humaine pour qu'elle puisse, par hybridation, se mettre au niveau d'une IA plus compétente que l'homme. On retrouve dans cette position les mêmes personnes que dans le premier réseau évoqué, à commencer par Elon Musk et Ray Kurzweil, ancien responsable de la recherche chez Google et directeur de la Singularity University puis du Machine Intelligence Research Institute224(*).

L'alternative du moratoire ou du transhumanisme représente en réalité un faux débat, il s'agit d'un couple qui fait système et enferme dans la perspective de solutions transhumanistes. Le professeur Jean-Gabriel Ganascia, entendu par vos rapporteurs, propose une explication à ce « double discours » des géants du Web, dans ce qu'il appelle une « charité ensorcelée », leur permettant de vendre d'autres technologies complémentaires à l'IA et d'inspiration transhumaniste, comme Neuralink dans le cas d'Elon Musk, censé rendre l'humain compétitif face à l'IA grâce à des implants neuronaux.

Il a également pris l'exemple du cynisme hypocrite d'IBM, qui, après le mouvement Black Lives Matter aux États-Unis, a annoncé renoncer à la recherche en reconnaissance faciale pour des raisons éthiques, avant de s'empresser de vendre la technologie en signant un contrat avec le Royaume-Uni y pour développer la reconnaissance faciale.

Cette tactique de dissimulation commerciale s'articule très bien avec un agenda transhumaniste, qui, lui, est presque totalement avoué. Le 28 octobre 2024 lors du congrès mondial des neurochirurgiens, Elon Musk a encore expliqué « qu'à un rythme de production élevé, son système Neuralink devrait approcher le coût d'une montre connectée ou d'un téléphone IPhone d'Apple et pourra être implanté par un robot dans le cadre d'une intervention chirurgicale de dix minutes, afin d'obtenir la symbiose homme-IA, nous devrons finalement remplacer nos crânes afin que nous puissions implanter suffisamment d'électrodes pour pouvoir interfacer nos cerveaux avec les ordinateurs »225(*).

De nombreux transhumanistes nient la nature humaine et sont dans l'hubris, surtout les transhumanistes les plus radicaux comme les extropiens libertariens226(*), qui jugent nécessaire d'aller vers l'immortalité et tracent la voie d'un avenir extraterrestre. Cette tendance extropianiste du transhumanisme a suscité un engouement particulier en Californie, par exemple autour de l'idée du mind uploading conjugué à l'intelligence artificielle.

Parmi les personnes entendues par vos rapporteurs, deux peuvent être apparentées à ce courant « techno-pessimiste » : Laurent Alexandre, entrepreneur et essayiste, et Siméon Campos, représentant de SaferAI. Ce dernier, qui reste toutefois optimiste sur les bénéfices de l'IA à court terme, a même confié avoir des craintes que sa vie soit menacée par l'IA dans les années à venir et a expliqué que l'IA serait probablement la cause de sa mort. Laurent Alexandre, lui, a alerté sur les risques que fera courir l'arrivée potentielle d'une intelligence artificielle forte dans nos sociétés, avec selon sa vision personnelle, une augmentation de la part des personnes inutiles dans l'économie, conduisant à des violences et une crise de civilisation.

Lors de son audition, il a expliqué plus précisément qu'en cas d'arrivée de l'IAG, soit l'humanité accepte son dépassement et s'y résigne, solution favorisée par Larry Page, fondateur de Google, soit l'IA est interdite, ce qui n'est pas une perspective très réaliste, soit un apartheid numérique se met en place, laissant l'IA se développer dans une noosphère sans possibilité d'agir sur le monde physique, soit, enfin et cela semble le plus probable parmi ces quatre scenarii, l'humanité se convertit au transhumanisme et accepte enfin le neuro-enhancement, c'est-à-dire l'amélioration de ses capacités cognitives par les technologies.

Laurent Alexandre a d'ailleurs attiré l'attention de vos rapporteurs sur le fait que dans la biographie d'Elon Musk par Walter Isaacson, président de l'Aspen Institute, ancien PDG de CNN et directeur de la rédaction du magazine Time, parue en 2023, les motivations du moratoire sur l'IA sont transparentes : les modèles d'xAI comme Grok doivent pouvoir rattraper leur retard, une IA surpuissante doit être créée et pour éviter qu'elle extermine l'humanité il faut trouver des moyens d'améliorer les capacités humaines en hybridant les hommes avec les machines. L'approche des techno-pessimistes serait donc parfois, en réalité, un faux nez du transhumanisme.

Le transhumanisme

Le transhumanisme est un mouvement philosophique prédisant et travaillant à une amélioration de la nature humaine grâce aux sciences et aux évolutions technologiques. Le terme renvoie d'abord à ce mouvement, secondairement à sa doctrine et à son imaginaire. Un livre du chercheur Stanislas Deprez, paru en août 2024, sur le transhumanisme (éd. La Découverte) mentionne cette triple dimension.

Le concept de transhumanisme a une histoire qui vient de loin : il apparaît simultanément en 1951 dans une conférence de Julian Huxley227(*) et un article du chercheur et prêtre jésuite Pierre Teilhard de Chardin228(*). Avant cela, Dante dans la Divine Comédie parlait de trasumanar comme idée de transcender l'homme pour se rapprocher de Dieu, les philosophies de Francis Bacon, de Condorcet ou de Trotski (qui appelait à une humanité libérée de la biologie) s'en rapprochent, l'ingénieur Jean Coutrot, ami d'Aldous Huxley, avait utilisé le mot dans un sens différent en 1939 et un théologien avait écrit en 1940 sur le transhumanisme de Saint-Paul229(*). Bien que le terme soit un label recouvrant des définitions différentes, il renvoie surtout à l'idée d'un dépassement des capacités ou des souffrances humaines grâce aux découvertes scientifiques et technologiques, voire à l'immortalité.

En 1962, Robert Ettinger lance ainsi le mouvement cryonique, soutenu par le théoricien « FM-2030 », auteur en 1989 du livre Are you a Transhuman ? L'initiateur du psychédélisme et de la cyberculture Timothy Leary théorise, dans les années 1960 et 1970, huit niveaux de conscience dont les quatre derniers sont post-humains230(*) (état biologique ;émotionnel ; symbolique et logique ; social et culturel ; neuro-somatique, capable de percevoir plus de trois dimensions ; neuro-électrique, capable de maîtriser des flux électriques et de communiquer par télépathie par exemple ; neuro-génétique, connecté au passé et à l'espèce ; neuro-atomique, connecté à l'unité cosmique de l'univers). Steward Brand opère, lui, la conversion de ces utopies du mouvement hippie vers l'informatique et crée le célèbre magazine Wired en 1993. Une solution technique à l'immortalité, plus moderne que la cryonie, serait le téléchargement de l'esprit dans des programmes informatiques (Mind Uploading). À défaut d'être immortel, l'homme peut s'hybrider avec la machine en vue de son amélioration (Cyborg). En 1998, le professeur Kevin Warwick s'implante ainsi des puces pour pouvoir contrôler le monde physique (ouvrir une porte, actionner des robots). Cette démarche inspirera Neuralink, société créée en 2016 par Elon Musk.

Le mouvement transhumaniste américain naît dans les années 1990 avec l'Extropy Institute, porté par Max More et sa femme Natasha Vita-More231(*), qui réunit des spécialistes de l'IA comme Marvin Minsky, Hans Moravec ou Vernor Vinge. En Europe, ce mouvement s'appuie sur la World Transhumanist Association, créée à Londres par Nick Bostrom en 1998, année de la Déclaration transhumaniste. Cette dernière réunit les transhumanistes de plusieurs continents. Une myriade d'associations sont créées dans le monde entier. Différents think tanks sont aussi créés dans les années 2000 et 2010, souvent avec une dimension universitaire.

L'amélioration des capacités humaines par les sciences et les technologies est au coeur de ce mouvement. Pour les transhumanistes, le progrès scientifique doit être orienté vers cet objectif : l'homme « augmenté » pourrait devenir immortel.

L'imaginaire transhumaniste renvoie en réalité à des systèmes de croyances. Le transhumanisme peut en cela parfois se rapprocher d'une religion fondée sur la négation de la nature humaine. Le projet transhumaniste, surtout dans certaines de ses variantes les plus radicales, suscite la méfiance de la part de vos rapporteurs. L'homme augmenté est un humain diminué : il perd par son augmentation une part de son humanité. À cet égard, on peut affirmer que le transhumanisme est un posthumanisme. L'intelligence artificielle n'est pas un acte de foi et ne doit pas le devenir. Rien ne justifie rationnellement de prendre parti pour le transhumanisme sur le fondement d'un très hypothétique risque existentiel que ferait courir l'IA.

Les discours techno-pessimistes relèvent pour l'essentiel d'une vision de l'IA non démystifiée. Cette approche a tendance à anthropomorphiser les intelligences artificielles en les voyant capables de dépasser l'homme et de le menacer. À cet égard, vos rapporteurs rappellent la troisième préconisation du rapport de l'OPECST de 2017 : l'IA doit être démystifiée. Cette démystification doit permettre aux citoyens d'acquérir une connaissance de base sur les systèmes d'IA mais aussi les protéger du transhumanisme et d'un techno-pessimisme ne reposant pas sur des bases scientifiques mais sur des croyances transhumanistes.

b) Les pessimistes modérés : l'IA est une menace, les mesures de prévention une solution

À côté de ces discours catastrophistes, on trouve un discours plus modéré sur les possibilités d'évolution de l'intelligence artificielle. Il s'agit de pointer du doigt l'incertitude dans laquelle nous nous trouvons actuellement vis-à-vis du développement des technologies d'intelligence artificielle. Cette situation résulte du fait que les innovations et le progrès technologique qui en découle n'ont pas été prévus par les chercheurs. Au moment de la création de l'architecture Transformer en 2017, personne n'imaginait par exemple les capacités de ChatGPT en 2024. C'est pourquoi les pessimistes modérés disent qu'on ne sait pas si l'intelligence artificielle générale adviendra dans le futur mais les conséquences de ces technologies seraient si grandes pour l'économie et la société qu'il faut anticiper et maîtriser ces risques.

Yoshua Bengio, chercheur le plus cité dans le monde dans le domaine de l'intelligence artificielle et pionnier de l'apprentissage profond, est certainement la figure la plus emblématique de cette position. Lors de son audition par vos rapporteurs, il a décrit sa position modérée comme « agnostique » par rapport à l'IAG et proposé des solutions que l'on retrouve dans son rapport sur les risques potentiels de l'IA232(*), écrit en 2024 avec d'autres chercheurs dans le cadre de la seconde édition des sommets internationaux sur la sécurité de l'IA. Cette approche met l'accent sur les mesures à prendre pour éviter ces risques et bien qu'elle constitue une position plus scientifiquement fondée que celle des techno-pessimistes, elle repose tout de même sur le postulat d'un risque existentiel.

Certains reprochent à cette vision d'être « trop prudente » vis-à-vis de l'IA, car elle surévalue des risques qui auraient en pratique peu de chances de se réaliser.

c) Les techno-optimistes : l'absence de menace, la poursuite du développement tranquille de l'IA avec un encadrement pragmatique

Face à ces deux visions plus ou moins pessimistes de la technologie, d'autres experts ont une approche plus optimiste de l'intelligence artificielle et pensent que l'intelligence artificielle forte restera hors de portée à ce stade, compte-tenu de l'état actuel de la technologie. C'est notamment le cas du professeur Yann LeCun directeur de l'IA chez Meta, que vos rapporteurs ont eu l'occasion de rencontrer à l'Université de New York. Il considère que l'IA est encore très loin d'avoir des notions de sens commun, de compréhension du temps et du monde physique, de maîtriser des tâches complexes de planification ou des actions en autonomie avec ses propres objectifs, etc. Or, ces dimensions sont des préalables au développement d'une IA forte. Même si Yann LeCun ne voit pas d'obstacles au développement de l'IAG dans un futur de long terme, il considère que l'architecture Transformer ne nous rapproche pas beaucoup de cette perspective. Il ne croit d'ailleurs pas dans la « révolution de l'IA générative » et tend à relativiser les prouesses des LLM de type ChatGPT. Pour certains, ces systèmes ne seraient même que des perroquets stochastiques233(*), vis-à-vis desquels la course à la taille serait une impasse, en raison du coût financier et de l'impact environnemental d'une telle montée à l'échelle.

Les techno-optimistes reconnaissent l'existence de risques liés à l'IA mais pour eux les risques à anticiper sont plus des difficultés tangibles qui se posent actuellement dans les actes de la recherche que des hypothèses de long terme sur l'IAG, la singularité et les risques existentiels pour l'humanité. Cette approche se prête donc mieux à des mesures pragmatiques d'encadrement des technologies et redonne tout son sens à l'action politique réaliste.

* 209 Cf. Vernor Vinge, 1993, The Coming Technological Singularity.

* 210 Extrait de l'article « Darwin among the Machines » dans The Press du 13 juin 1863 : « The upshot is simply a question of time, but that the time will come when the machines will hold the real supremacy over the world and its inhabitants is what no person of a truly philosophic mind can for a moment question ».

* 211 Cf. le rapport d'Anthropic sur les capacités de Claude 3 : https://www-cdn.anthropic.com/de8ba9b01c9ab7cbabf5c33b80b7bbc618857627/Model_Card_Claude_3.pdf

* 212 Cf. le commentaire Dan Hendrycks à propos du graphique d'OpenAI sur les capacités de leur nouveau système en écriture, mathématiques, raisonnement logique et codage dans ce post : https://x.com/DanHendrycks/status/1778588753721950514

* 213 Will Douglas Heaven, décembre 2023, « Google DeepMind used a large language model to solve an unsolved math problem », MIT Technology Review : https://www.technologyreview.com/2023/12/14/1085318/google-deepmind-large-language-model-solve-unsolvable-math-problem-cap-set/

* 214 Ces lois signifient qu'accroître la puissance de calcul des superordinateurs et le volume de données traitées conduit mécaniquement les modèles à être de plus en plus performants d'un point de vue qualitatif. Cf. un article qui illustre ces scaling laws, Jordan Hoffmann, 2022, « Training Compute-Optimal Large Language Models » : https://arxiv.org/abs/2203.15556 ainsi que les rapport d'Epoch AI, surtout le premier « Can AI Scaling Continue Through 2030? » : https://epoch.ai/blog/can-ai-scaling-continue-through-2030 et https://epoch.ai/blog/direct-approach-interactive-model

* 215 La citation originale : « there is no physical law precluding particles from being organised in ways that perform even more advanced computations than the arrangements of particles in human brains », cf. Stephen Hawking, « Are we taking Artificial Intelligence seriously », dans The Independent, 1er mai 2014 : https://www.independent.co.uk/news/science/stephen-hawking-transcendence-looks-at-the-implications-of-artificial-intelligence-but-are-we-taking-ai-seriously-enough-9313474.html

* 216 Mira Murati, la directrice technique d'OpenA,I a ainsi déclaré lors d'une conférence le 20 juin 2024 : « GPT-3 was toddler-level, GPT-4 was a smart high schooler and the next gen, to be released in a year and a half, will be PhD-level », cf. l'extrait : https://x.com/tsarnick/status/1803901130130497952

* 217 La question posée relative à la détection de rayonnements avec un bolomètre nécessitait, avant même de répondre, de comprendre un problème de physique avec un diagramme complexe écrit en français. Cf. le rapport technique 2023 sur GPT-4 réalisé par OpenAI : https://cdn.openai.com/papers/gpt-4.pdf

* 218 Cf. par exemple l'article de Gary Marcus en 2022 qui explique que les technologies connexionnistes vont se heurter à un mur, « Deep Learning Is Hitting a Wall » : https://nautil.us/deep-learning-is-hitting-a-wall-238440

* 219 Cf. cet article de juin 2024 : https://observer.com/2024/11/vc-andreessen-horowitz-ai-models-hitting-wall/

* 220 Cf. l'article de The Information, « OpenAI Shifts Strategy as Rate of `GPT' AI Improvements Slows » : https://www.theinformation.com/articles/openai-shifts-strategy-as-rate-of-gpt-ai-improvements-slows

* 221 Dans un tweet laconique sur X, qui a suscité un millier de commentaires et un millier de partages, Sam Altman a affirmé le 14 novembre 2024 « there is no wall » : https://x.com/sama/status/1856941766915641580

* 222 Ce terme est tiré du rapport de l'OPECST de 2017.

* 223 Future of Life Institute, « Pause Giant AI Experiments: An Open Letter », https://futureoflife.org/open-letter/pause-giant-ai-experiments/

* 224 Cf. son livre révélateur: Ray Kurzweil, 2024, The Singularity Is Nearer : When We Merge with AI, Viking.

* 225 La déclaration originale d'Elon Musk au 2024 Congress of Neurological Surgeons : « at high volume, Neuralink should approach the cost of an Apple watch or phone and be implanted by a robot in a 10-minute surgery in order to achieve human-AI symbiosis we will ultimately need to replace our skulls so we can implant enough electrodes to interface our brains with computers ».

* 226 Cf. l'histoire de l'extropianisme, sous-courant du transhumanisme, apparu au début des années 1990 en Californie, sur le site de l'association française transhumaniste : https://transhumanistes.com/histoire-du-transhumanisme-les-debuts-des-extropiens-1988/

* 227 Frère de l'écrivain Aldous Huxley, Julian Huxley est un biologiste britannique, théoricien de l'eugénisme, premier directeur général de l'Unesco, fondateur du WWF et auteur connu pour ses livres de vulgarisation scientifique.

* 228 Sa première occurrence serait la conclusion d'un article intitulé « Du préhumain à l'ultra-humain », paru au sein de l'Almanach des Sciences de 1951.

* 229 Un article du théologien canadien W.D. Lighthall.

* 230 Cf. ses livres Neurologic (1973) augmenté avec Exo-Psychology (1977) puis Info-Psychology (1989).

* 231 Le couple écrit en 2013 un essai particulièrement riche, cf. Max More et Natasha Vita-More, The Transhumanist Reader : Classical and Contemporary Essays on the Science, Technology, and Philosophy of the Human Future.

* 232 Cf son « Rapport scientifique international sur la sécurité de l'IA avancée » : https://yoshuabengio.org/fr/2024/06/19/le-rapport-scientifique-international-sur-la-securite-de-lia-avancee/

* 233 L'article qui a introduit le concept de « perroquets stochastiques » s'est accompagné de vives polémiques. Cf. Emily Bender et al., 2021, « On the Dangers of Stochastic Parrots : Can Language Models Be Too Big? », Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency : https://dl.acm.org/doi/abs/10.1145/3442188.3445922