II. LES IA GÉNÉRATIVES : PRINCIPALE INNOVATION TECHNOLOGIQUE EN INTELLIGENCE ARTIFICIELLE DEPUIS 2017

A. LES PRINCIPALES AVANCÉES EN MATIÈRE DE GÉNÉRATION DE CONTENU CES DERNIÈRES ANNÉES

En amont de la mise à disposition de ChatGPT par OpenAI le 30 novembre 2022, système qui a marqué le grand public par ses performances malgré des hallucinations alors encore trop nombreuses, un ensemble d'innovations ont conduit à des progrès dans les technologies d'IA. La principale de ces innovations est la définition d'une nouvelle architecture pour les modèles d'apprentissage profond appelée Transformer.

Son invention en 2017 a permis cinq ans plus tard la création du modèle Generative Pre-trained Transformer, dont les initiales GPT ont été données au système d'agent conversationnel d'OpenAI. Selon Laurent Alexandre, entendu par vos rapporteurs, le XXIe siècle est né le 30 novembre 2022 avec l'introduction de cet outil d'IA générative.

Il serait plus juste de dater cette révolution technologique de l'année où le modèle est proposé, soit 2017, d'autant plus que ChatGPT, s'il est le premier à être commercialisé, n'est pas la première IA générative à être mise au point : le modèle BERT (pour Bidirectional Encoder Representations from Transformers) a été conçu par Google dès 2018. Et l'année suivante, des modèles spécifiques à la langue française sont même développés : CamemBERT et FlauBERT77(*).

Ces outils ont d'abord concerné le langage avec les grands modèles de langage (LLM de l'anglais Large Language Models) puis les contenus sonores ou visuels. Depuis 2017, chaque trimestre en moyenne, les modèles sont l'objet d'avancées significatives, qualitativement, du point de vue de leur architecture ou, au moins, quantitativement, du point de vue de l'accroissement de leur taille, ce qui les rend mécaniquement de plus en plus efficaces. On parle à ce sujet de lois d'échelle ou scaling laws.

1. « Attention is all you need » : la technologie Transformer inventée en 2017

L'innovation introduite en 2017 consiste à apporter une amélioration à l'apprentissage profond résultant de la multiplication des couches de réseaux de neurones, telle que vue précédemment, ouvrant la voie d'intelligences artificielles génératives performantes, en particulier dans le domaine des LLM dédiés au traitement naturel du langage78(*).

Dans un article scientifique qui fait référence à la chanson des Beatles All you need is love - dont la conclusion du refrain Love is all you need est paraphrasée sous la forme Attention is all you need79(*) - des chercheurs de l'entreprise Google ont théorisé l'architecture Transformer (plus rarement appelée « Transformeur »). Alors que les LSTM ont une mémoire relativement courte et ont du mal à traiter de propositions ambiguës, l'architecture Transformer résout en grande partie ce problème.

En effet, cette dernière est dotée d'un mécanisme appelé « l'attention », qui lui permet d'obtenir des informations sur les mots en fonction du contexte de la phrase et ainsi de traiter plus d'éléments qu'un LSTM, y compris pour une proposition dont le sens ne se déduit pas de sa seule formulation.

En pratique, le mécanisme d'attention est un encodeur qui fonctionne par étapes successives permettant de transformer toute l'information nécessaire de la séquence de mots à traiter en données numériques (c'est le word embedding qui a notamment recours à des fonctions sinus et cosinus). Ainsi, après une parallélisation de calculs de matrices de poids d'attention (on parle de multi-headed attention ou attention multi-têtes80(*)), on va transformer les mots en vecteurs, puis calculer les liens grammaticaux, sémantiques et pragmatiques entre les différents mots d'une séquence.

Par exemple, la phrase « Alice amène sa voiture rouge au garage car elle est en panne » est facilement compréhensible par un être humain, elle l'est toutefois beaucoup moins pour un modèle de langage sans attention. En effet, si le modèle traite les informations mot à mot, alors il est incapable de lier les adjectifs aux noms, ainsi « voiture rouge » ne sera pas un concept pour le modèle mais l'addition des concepts de « voiture » et de « rouge », ce qui peut poser des problèmes puisque tout ce qui est rouge n'est pas une voiture et toutes les voitures ne sont pas rouges.

En plus de cela, il existe des ambiguïtés qui sont évidentes à lever pour un être humain mais ne le sont pas pour le modèle. Dans la phrase d'exemple, le pronom « elle » est ambigu, il peut renvoyer au sujet ou à l'objet de la phrase, c'est-à-dire à la voiture ou à Alice.

Avec le contexte, il est clair pour un humain que l'on parle ici de la voiture d'Alice, mais il s'agit d'une information dont un modèle ne peut disposer que grâce à un système d'attention.

Le fonctionnement de ce système nécessite d'abord de transformer une séquence de mots, dont l'information est transmise par des données de type « chaîne de caractères », en valeurs numériques qui pourront alors être traitées par un réseau de neurones.

a) La « tokenisation » : découper préalablement les mots

Une fois que le jeu de données d'apprentissage a été constitué (ici, un ensemble étendu de textes), la première étape de cette technologie consiste à découper les mots en unités ou tokens qui sont des briques élémentaires de vocabulaire servant d'unités de base pour le modèle.

Cette technique permet une meilleure capacité du modèle en termes de généralisation, en particulier par rapport à des mots rares ou à des variantes linguistiques.

Les données d'entraînement contiennent des milliards de ces tokens. Ces briques, souvent plus petites qu'un mot, sont les éléments traités par le reste du mécanisme d'attention. Pour cela, il existe plusieurs algorithmes : BPE81(*) (Byte Pair Encoding), WordPiece82(*), Unigram83(*), etc.

Par exemple la phrase « Science sans conscience n'est que ruine de l'âme » tirée du roman Pantagruel de Rabelais est transformée par GPT-484(*) en quatorze tokens :

Science| sans| conscience| n| `est| que| ru| ine| de| l| `| â|me|.

On constate que certains mots ne sont pas découpés en unités plus petites comme « science » et « conscience », cependant les mots « ruine » et « âme », eux, sont découpés.

Si l'on reprend l'exemple pris pour introduire le concept d'attention, on obtient ce découpage en quinze unités :

Alice| am|ène| sa| voiture| rouge| au| garage| car| elle| est| en| pan|ne|.

Du côté de la génération de contenus, comme peuvent souvent le voir les utilisateurs de ces systèmes en temps réel, le texte est généré, token après token, ce qui a des conséquences sur la probabilité que chaque token généré à l'étape suivante soit le bon.

b) Le plongement lexical : vectoriser les tokens

Même découpés ainsi en briques élémentaires, les mots sont toujours des chaînes de caractères. Or, on l'a vu précédemment, les réseaux de neurones traitent des données numériques. Donc, pour être traitée dans un modèle d'IA, l'information lexicale doit être transformée en information numérique.

Pour cela, on réalise une opération essentielle que l'on appelle un « plongement lexical » ou word embedding en anglais. Une méthode qui préexistait aux Transformers.

Il s'agit d'associer à chaque unité un vecteur représentant les coordonnées du mot dans un espace possédant un grand nombre de dimensions. Ce vecteur est un ensemble de coordonnées, notées dans une colonne unique, chaque nombre dans la colonne définit la coordonnée du mot dans une dimension de l'espace. Par exemple, prenons le cas d'un vecteur

qui représente un mot dans l'espace de plongement, on note ses coordonnées de la manière suivante :

.

Le nombre

correspond à la coordonnée du mot dans la première dimension de l'espace,

dans la deuxième, etc., jusqu'à la nième dimension,

étant le nombre total de dimensions de l'espace de plongement. Ainsi, le nombre de coordonnées dans un vecteur définit le nombre de dimensions de l'espace de plongement. L'espace de plongement possède un très grand nombre de dimensions, il ne ressemble pas aux espaces en deux ou trois dimensions dont nous sommes plus familiers. L'espace de plongement est difficile à imaginer de façon intuitive : un vecteur qui représente des coordonnées est préféré car les vecteurs permettent de réaliser des opérations qui rendent cet espace multidimensionnel moins abstrait.

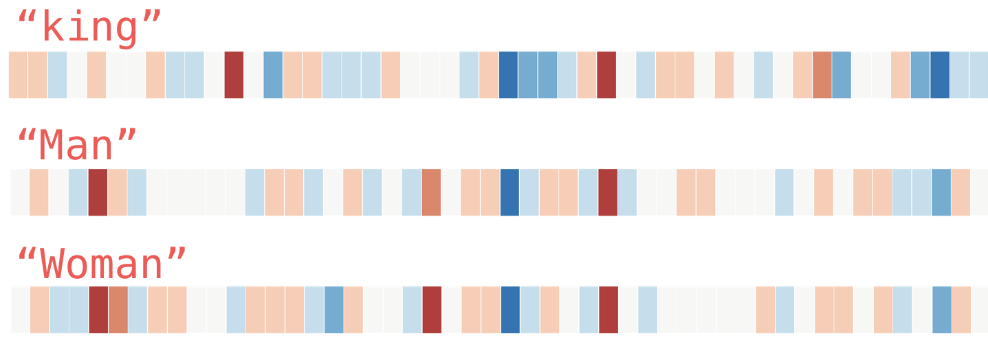

Si l'on remplace chaque coordonnée des vecteurs par des couleurs, par exemple un dégradé allant du bleu au rouge avec la valeur zéro pour le blanc, on peut représenter visuellement les vecteurs des mots « plongés » (mots qui sont les objets du plongement lexical). Cela permet d'observer des propriétés intéressantes en ne regardant que les coordonnées des vecteurs plongés.

Dans l'image qui suit, on constate que les mots « homme » et « femme » ont plus de similitudes entre eux, que chacun d'eux peut en avoir avec le mot « roi », ce qui est normal puisque les deux désignent un genre, alors que « roi » désigne une fonction.

Représentation sous forme de couleur des

coordonnées vectorielles

des mots « king »,

« man » et « woman »

Source : Jay Alammar, Word Embedding85(*)

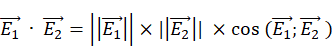

Plonger les unités lexicales dans un espace continu permet également de réaliser des calculs avec eux plutôt que de se contenter d'observer des similarités sans les mesurer. Les vecteurs possèdent trois caractéristiques avec lesquelles il est possible de réaliser des opérations. Ils ont une norme, qui correspond à leur longueur dans l'espace, une direction qui est l'orientation du vecteur dans l'espace, et un sens, qui indique vers quelle extrémité le vecteur pointe (de l'origine du repère vers l'extrémité qui est le mot dans l'espace).

Réaliser des opérations sur les vecteurs correspond par exemple à additionner deux vecteurs, ce qui revient à faire translater un vecteur à l'extrémité d'un autre pour tracer le vecteur sommes : celui-ci part alors de l'origine du premier, passe par l'extrémité à l'origine du second et se termine à l'extrémité du second. Une autre opération courante avec des vecteurs est le produit scalaire de deux vecteurs, qui est un nombre. Ce produit scalaire se calcule en multipliant leurs normes respectives par le cosinus de l'angle formé par ces deux vecteurs86(*) :

Aussi, si le plongement lexical est correctement réalisé, il est possible d'effectuer des opérations sur la base du « sens » des mots, entendu comme l'ensemble des relations de proximité ou d'éloignement entre mots que l'apprentissage a permis d'identifier. Par exemple, dans cet espace, le vecteur de différences entre les mots « homme » et « roi » est similaire au vecteur de différences entre les mots « femme » et « reine ». Ainsi, on peut établir l'identité approximative telle que :

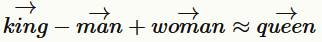

Des chercheurs ont cherché à comprendre en 201987(*) la structure mathématique de ces analogies entre les mots, qui prennent par exemple une forme de type « a est à b ce que x est à y », permettant à des modèles d'affirmer que a et x peuvent être transformés de la même manière pour obtenir b et y, et vice-versa.

D'un point de vue formel, ces analogies linéaires entre les mots correspondent à des relations vectorielles où les vecteurs forment dans l'espace vectoriel une structure géométrique de type parallélogramme. Ces quadrilatères ont des propriétés utiles qui peuvent être exploitées. Une analogie linéaire dans l'espace vectoriel entre tel ensemble de mots (ou de tokens) et tel autre ensemble de mots (ou de tokens) montre que leurs vecteurs sont coplanaires et que toute combinaison de ces vecteurs peut être utilisée pour réécrire les structures de relations entre ces éléments en termes statistiques.

En pratique, les systèmes de relations sont bien entendu plus complexes que l'exemple de parallélogramme dans l'espace vectoriel donné ici.

L'exemple d'un parallélogramme analogique au sein de l'espace vectoriel

Source : Kawin Ethayarajh, op. cit.

Cette structure implique que les vecteurs sont coplanaires et que les relations entre les mots peuvent être représentées géométriquement mais surtout statistiquement. La corrélation entre les mots dans un corpus d'apprentissage est ainsi d'autant plus élevée que la distance euclidienne entre leurs vecteurs est faible. Cette affirmation qui semble intuitive repose, selon Kawin Ethayarajh, sur la première interprétation théorique de la distance euclidienne dans les espaces vectoriels de mots. Il montre que cette approche surpasse scientifiquement les théories arithmétiques sur les analogies entre les mots en affirmant que la distance euclidienne est une fonction linéaire décroissante de l'induction mathématique de leur co-occurrence vectorielle relative, à l'aide du théorème csPMI88(*).

Il est donc possible de réaliser des produits scalaires entre deux vecteurs au sein d'un espace vectoriel et de comparer les produits scalaires de ces vecteurs pour voir lesquels « vont dans la même direction », témoignant de leurs proximités sémantiques.

Pour mieux comprendre ce principe, il est possible de l'illustrer d'un exemple avec une réduction des dimensions de l'espace de plongement. Ainsi, l'algorithme word2vec, dont une démonstration est disponible sur le site de l'École Polytechnique89(*), permet de réaliser des opérations à partir de mots qui ont été plongés : il est possible d'effectuer une « similarité cosinus », qui est une opération utilisant le produit scalaire en faisant en sorte que les normes des vecteurs comparés ne comptent pas dans le résultat final (on parle d'une « normalisation » ou encoding en anglais).

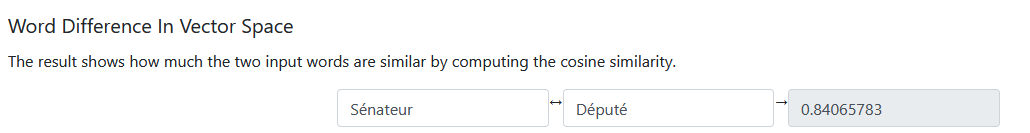

Dans l'espace vectoriel, les mots « Sénateur » et « Député » ont une similarité cosinus d'environ 0,84 ce qui est un score relativement important, illustrant le fait que dans l'espace vectoriel, ces deux mots sont proches. La proximité sémantique peut être reproduite via des calculs en tant que similarité cosinus.

Proximité des mots « Sénateur » et « Député » dans un espace vectoriel

Source : Calcul réalisé à l'aide du site de l'École Polytechnique

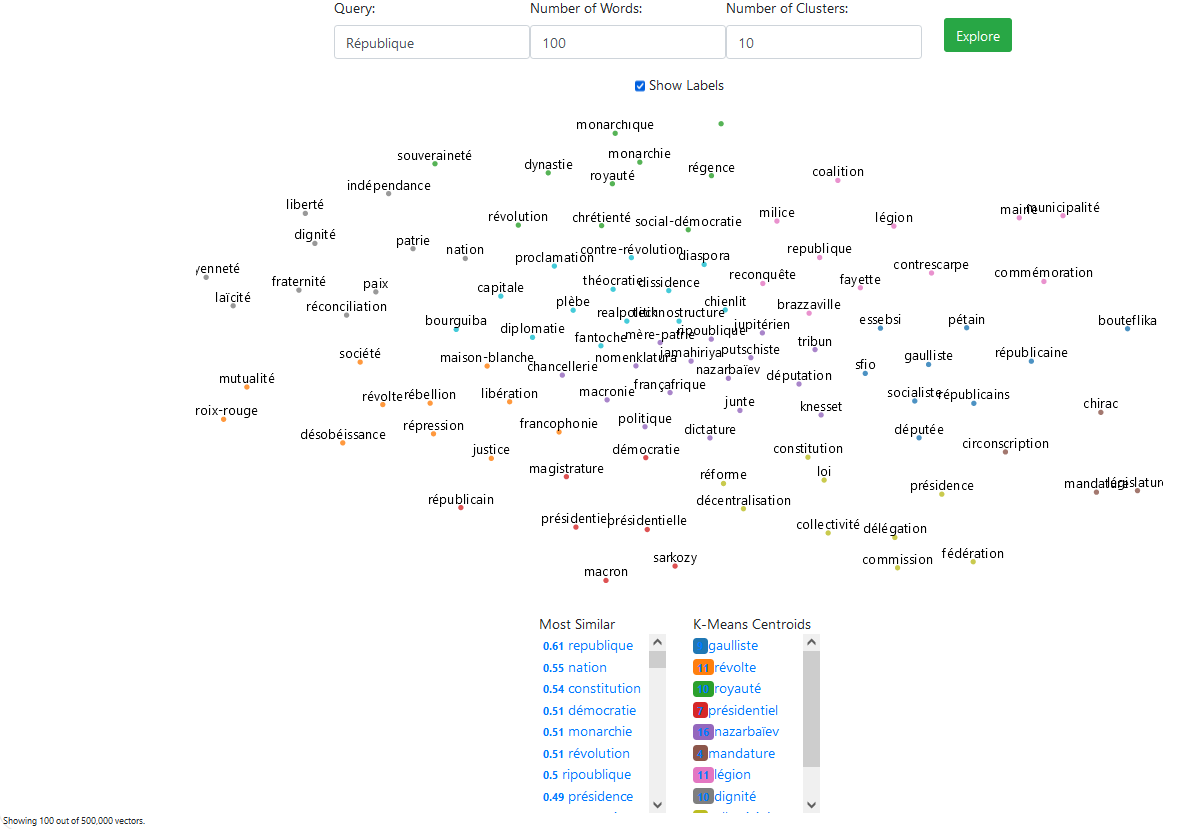

On peut également prendre une représentation en deux dimensions de l'espace vectoriel (qui est lui à n dimensions) et trouver les voisins de mots déterminés. On peut alors se faire une idée intuitive de la façon dont fonctionne l'espace de plongement. Il est toutefois toujours important de garder en tête qu'il ne s'agit que d'une représentation très simplifiée : un espace de plongement possède un grand nombre de dimensions et donc des propriétés particulières qui peuvent être contre-intuitives par rapport à sa forme visuelle.

Un exemple peut être donné à travers une représentation graphique, grâce à la démonstration de l'algorithme word2vec sur le site de l'École Polytechnique, des cent mots les plus proches de « République ». On peut y voir des mots liés aux valeurs républicaines comme à la vie politique plus généralement.

Représentation des cent mots les plus proches de « République »

Source : Schéma réalisé à l'aide du site de l'École Polytechnique

c) Le mécanisme d'attention : intégrer le contexte

Encoder les tokens (ce qui revient à normaliser les jetons) dans un espace de très grande dimension ne suffit pas. En effet, un jeton ou un mot peuvent être polysémiques : dans l'exemple précédent, le mot « voiture » en français peut désigner le véhicule motorisé individuel, mais également une partie d'un train qui accueille les voyageurs. Des informations grammaticales doivent également être tirées du sens de la phrase.

Si l'on reprend la phrase :

« Alice| am|ène| sa| voiture| rouge| au| garage| car| elle| est| en| pan|ne| »,

il est naturel pour nous de savoir que le mot « elle » dans cette phrase concerne la voiture, et non Alice. Toutefois, cette information est impossible à connaître pour un système d'IA sur la base du simple plongement lexical des mots. Le défi consiste à introduire cette information contextuelle.

Les vecteurs de plongement lexical vont pour cela passer par un processus appelé « mécanisme d'attention » afin d'y associer les informations de contexte essentielles à la compréhension de la phrase : à quel nom se rattache un adjectif, à quel nom renvoie un pronom, quel est le « sens » d'un mot dans la phrase, etc.

Tout au long de cette première phase d'entraînement, le modèle établit les relations probabilistes entre chaque token et tous les autres tokens de l'ensemble de données.

Dans les modèles d'IA générative basés sur l'architecture Transformer, le mécanisme d'attention est un algorithme par lequel le modèle identifie les briques élémentaires qui offrent des informations contextuelles sur la signification des autres briques. Cet algorithme juge de la pertinence des entrées en fonction du contexte spécifique de telle ou telle demande (les requêtes sont appelées prompts) et leur attribue différents poids relatifs dans son processus de calcul.

Le modèle est alors en mesure de produire des résultats en prédisant la suite de tokens probablement la plus adaptée à un contexte donné, selon une fonction softmax (aussi appelée, plus rarement, fonction exponentielle normalisée), qui permet de donner aux vecteurs une valeur entre 0 et 1 (ou entre 0 et 100 en pourcentage).

Les LLM utilisés depuis l'introduction de ChatGPT en 2022 reposent sur ce mécanisme mathématique de mise en contexte par algorithme.

d) Un apprentissage auto-supervisé et des données synthétiques

Parmi les méthodes d'apprentissage automatique (Machine Learning), dont celles recourant à des réseaux de neurones en couches profondes (Deep Learning), le modèle apprend le plus souvent à partir d'échantillons de données annotées. Comme l'explique Yann LeCun depuis les progrès enregistrés par ces algorithmes dans les années 2010, l'un des grands défis sera de remplacer cet apprentissage supervisé par un apprentissage non supervisé.

Ainsi que l'a souligné Bertrand Braunschweig lors de son audition, l'architecture Transformer, peut être vue comme une étape dans le passage de l'apprentissage supervisé à l'apprentissage non supervisé. On parle à ce sujet d'apprentissage auto-supervisé (et parfois d'apprentissage semi-supervisé). En anglais, la notion de self-supervised learning (ou SSL) est utilisée.

Le modèle apprend à partir d'échantillons de données non annotées certes mais, dans un premier temps, l'apprentissage reste supervisé : les réseaux de neurones sont initialisés avec des étiquettes qui aident à déterminer les premiers poids synaptiques de chacun des réseaux.

Ce n'est que dans un deuxième temps que l'apprentissage devient non supervisé, les échantillons de données ne sont pas annotés et le modèle générant génère automatiquement les étiquettes associées, sans intervention humaine.

L'apprentissage auto-supervisé est la technique d'apprentissage des modèles Transformer mais d'autres modèles y ont également recours. Différentes applications de reconnaissance sont élaborées par Facebook par exemple : une fois entraîné selon un apprentissage supervisé à identifier des liens entre des contenus, le modèle passe à un apprentissage auto-supervisé qui lui permet de générer automatiquement des étiquettes, conduisant au fait qu'un modèle identifie seul les relations entre des images similaires.

En plus des données préexistantes, issues du monde réel et du monde virtuel qu'est Internet, les modèles d'IA générative ont de plus en plus recours à des données créées artificiellement dont les propriétés statistiques prédictives sont proches des données réelles mais dont les conditions de mise à disposition sont moins chères, plus accessibles ou ne contiennent pas d'informations personnelles ou sensibles. Ces corpus, dérivés du réel ou pas, prennent le nom de données synthétiques ou synthetic data. De telles données permettent de réduire les coûts élevés des données issues du monde réel et de contourner les contraintes éthiques de données réelles tout en conservant des propriétés prédictives similaires.

Avant l'IA générative, de telles données, comme des animations de jeux vidéo en 3D, ont pu être utilisées pour entraîner des systèmes de reconnaissance visuelle. En biologie et en médecine, ce type de données a d'ores et déjà été très utile pour pallier le manque de données réelles, par exemple pour concevoir de nouveaux médicaments contre les maladies rares. La production rapide des vaccins lors de la pandémie de covid-19 reposait aussi sur l'utilisation de données synthétiques90(*).

En tant que données de nature secondaire, dérivées de corpus qui peuvent eux-mêmes contenir des biais, les données synthétiques posent à la fois la question des biais liés aux données en général mais elles peuvent aussi apporter leurs propres biais en plus91(*), et induire des erreurs dans les modèles d'IA, si elles ne reflètent pas correctement la réalité ou si elles sont mal calibrées92(*).

Elles peuvent aussi renforcer des biais existants et déformer les résultats produits ensuite par les modèles d'IA93(*).

Enfin, elles peuvent enfermer les modèles dans une boucle autodestructrice, appelée en anglais autophagous ou self-consuming loop, dégradant progressivement la qualité et/ou la diversité des données synthétiques et menant à un échec du modèle. Ce dernier point a fait l'objet d'un article critique en août 202494(*), qui propose un nouveau cadre d'entraînement itératif pour les modèles de diffusion sur la base de données synthétiques auto-améliorantes, appelé Self-IMproving diffusion models with Synthetic data (ou SIMS).

Lutter contre les biais de ces données synthétiques, en plus de lutter contre les biais des autres données plus généralement, doit être un objectif pour les développeurs de systèmes d'IA. Il faut mieux les évaluer en amont afin de pouvoir les prendre en considération ensuite lors des phases d'utilisation de données synthétiques pour l'entraînement des modèles d'IA, des mécanismes d'audit et de correction sont nécessaires et ils doivent prévoir le cas particulier des biais spécifiques introduits au stade des données synthétiques95(*). Ces audits, utilisant par exemple des tests spécifiques de biais avant entraînement des modèles, responsabiliseraient les concepteurs d'IA dans une logique proactive dans une démarche d'atténuation systématique et tangible et de réduction des biais. Les modèles de diffusion de type SIMS permettront une auto-amélioration et un ajustement de la distribution des données synthétiques des modèles de diffusion pour correspondre à une distribution cible souhaitée afin d'aider à atténuer les biais et à garantir l'équité des résultats.

2. Distinguer les « modèles de fondation » des systèmes d'intelligence artificielle

a) La notion de « modèle de fondation » et ses ambiguïtés

La notion de modèle de fondation, synonyme de celle de modèle d'intelligence artificielle à usage général utilisée par l'Union européenne96(*), est issue des avancées en matière de Deep Learning dans les années 2010 et a été introduite en 2021 par des chercheurs de l'Université de Stanford97(*) pour combler un vide de vocabulaire et identifier le modèle général issu de l'entraînement des algorithmes d'apprentissage profond pouvant ensuite faire l'objet de réglages ultérieurs plus fins, pour l'aligner avec certaines valeurs ou pour le spécialiser en vue de ses applications concrètes98(*).

Cette expression désigne donc les modèles non spécialisés entraînés sur un large ensemble de données, aux thématiques variées et non étiquetées et ayant vocation à être utilisés pour réaliser différentes tâches après avoir fait l'objet d'un fine-tuning. Le « modèle de fondation » ne signifie pas que le modèle est « fondateur » au sens où il permet à l'IA d'être générative : les modèles de fondation ne sont pas exclusivement liés à l'IA générative, il est important de noter qu'il y a des systèmes d'IA générative qui n'ont pas de modèle de fondation (ils seront vus plus loin) et des systèmes d'IA non générative basés sur de l'apprentissage profond qui peuvent s'appuyer sur la dichotomie « modèle de fondation/réglage fin ».

C'est à partir des modèles de fondation que peuvent être construites, à la suite d'un réglage fin ou « fine-tuning », des applications destinées à un usage spécifique, comme des systèmes d'intelligence artificielle générative. Ainsi, le modèle de fondation constitue la couche logicielle élémentaire permettant le bon fonctionnement d'une application. La qualité finale d'une application d'IA dépend souvent en grande partie du modèle de fondation utilisé pour le bâtir. Les modèles Llama de Meta sont des exemples de modèles de fondation. Dans leur cas, ils sont proposés en open source aux développeurs et aux entreprises qui sont alors libres de réaliser des applications ou systèmes d'intelligence artificielle, dans le domaine qu'ils souhaitent grâce à des techniques permettant de spécialiser ces modèles de fondation et de les entraîner sur des données spécifiques.

Pour leur entraînement, ces modèles de fondation ont besoin de très vastes jeux de données. Les données d'entraînement utilisées par les grandes entreprises mais aussi par les développeurs plus petits restent le plus souvent secrètes. L'une des rares exceptions est le premier modèle Llama de Meta qui a poussé son caractère open source jusqu'à rendre publiques les modalités d'entraînement de ses algorithmes (y compris les données utilisées ou les poids synaptiques de ses réseaux de neurones). Ainsi les deux tiers des données provenaient du référentiel Common Crawl (qui après un nettoyage grâce à différents filtres rassemble la plupart des contenus des sites Internet), 15 % des données de C4 (une version encore plus nettoyée du grand corpus de Common Crawl, 4,5 % de GitHub, 4,5 % de Wikipédia, 4,5 % de différents ouvrages publiés et numérisés, 2,5 % d'ArXiv et 2 % de StackExchange, un forum collaboratif de questions/réponses sur des sujets variés. Les entreprises n'ont cependant pas recours uniquement à des données ouvertes, comme Common Crawl pour le langage ou Software Heritage pour le logiciel, elles utilisent aussi secrètement des données propriétaires, dans des proportions inconnues et au mépris du respect des droits des ayants droit.

Outre les données synthétiques, les modèles disposent d'un autre moyen de généralisation sans recourir à des données réelles : il s'agit d'un mode d'apprentissage où le modèle est entraîné à reconnaître et à catégoriser des objets ou des concepts sans avoir vu d'exemples de ces catégories ou concepts au préalable. On parle à ce sujet de Zero-Shot Learning (ZSL). Par exemple un modèle d'intelligence artificielle qui n'a jamais été entraîné à reconnaître un zèbre peut toutefois le reconnaître car il a été formé à reconnaître un cheval. Les premiers travaux à ce sujet datent de 200999(*), mais certains chercheurs avaient déjà réfléchi auparavant à l'idée de classifieurs sans données. Ces apprentissages zéro donnée sont une perspective intéressante pour les modèles d'IA générative, comme l'a déclaré aux conférences 2023 et 2024 de Sequoia Capital, Andrej Karpathy, fondateur avec Elon Musk et Sam Altman d'OpenAI en 2015 et actuel directeur de l'IA chez Tesla.

b) Le « fine-tuning » : passer du modèle de fondation aux applications

Pour que les outils de l'intelligence artificielle puissent répondre à des besoins variés sous la forme de multiples systèmes un « réglage fin » des modèles de fondation est nécessaire. Pour réaliser des applications, destinées en effet à des utilisateurs et donc à une utilisation spécifique, les développeurs utilisent des techniques d'entraînement appelées « réglages fins » (de l'anglais fine-tuning) qui permettent de spécialiser les modèles de fondation modèle, c'est-à-dire de l'aligner sur les objectifs des tâches attendues (par exemple un chatbot médical ou une IA avocate faisant office de conseiller juridique virtuelle). Des modules peuvent également être ajoutés à un modèle de fondation pour en modifier les sorties et les rendre plus cohérentes à telle ou telle utilisation spécifique. Des cadres comme LangChain permettent par ailleurs aujourd'hui de créer des applications qui se basent sur des chaînes de modèles d'intelligence artificielle réalisant des tâches successives pour parvenir au résultat présenté à l'utilisateur.

Pour saisir la différence entre modèles de fondation et applications, l'exemple des modèles GPT et de l'application ChatGPT peut être pris. Comme nous l'avons vu, les modèles GPT d'OpenAI sont des prédicteurs stochastiques de la suite d'une séquence de mots. Aussi après leur entraînement initial, ils n'ont pour seule fonction que de compléter la phrase commencée par l'utilisateur. Rien ne destine initialement le modèle à élaborer des réponses comme le ferait un robot conversationnel.

L'entreprise qui a entraîné le modèle de fondation peut être celle qui procède au réglage fin mais elle peut aussi laisser d'autres développeurs peaufiner son modèle pour des applications particulières. Les développeurs qui assurent le fine-tuning ont alors le choix d'utiliser une version locale du modèle ou - lorsque l'entreprise qui a créé le modèle l'a prévu - une interface de programmation d'application, appelée « API » pour Application Programming Interface. Les API facilitent la tâche des développeurs dans la phase aval en rendant les ajustements souhaités pour des applications spécifiques plus simples à réaliser.

Des exemples de développement d'applications sur la base de modèles de fondation peuvent être pris dans divers domaines, outre la médecine ou le droit déjà mentionnés. Ainsi, la direction générale des finances publiques du ministère de l'économie (DGFiP) a développé une application à partir du modèle de fondation open source Llama 2 de l'entreprise Meta, appelée « LLaMandement » qui permet de traiter et résumer les objets des amendements parlementaires lors de l'examen des projets de loi de finances100(*).

L'adaptation d'un modèle de fondation à une application spécifique repose sur un entraînement supervisé du modèle de fondation sur des données annotées - impliquant le plus souvent une annotation humaine - qui permettent d'affiner les résultats du modèle. Ce réglage fin supervisé (SFT pour Supervised Fine-tuning) consiste à entraîner le modèle général pré-entraîné en vue de répondre spécifiquement à certaines tâches, à l'aide d'un jeu de données plus restreint, plus organisé que les données générales d'entraînement et impliquant le plus souvent une annotation humaine. En matière médicale, ce réglage fin supervisé pourra ainsi passer par des données médicales étiquetées correspondant à de bons diagnostics pour aider le futur système d'IA à effectuer lui-même de bons diagnostics.

Ce second entraînement est suivi par une troisième phase dite « d'alignement » du modèle qui s'effectue grâce à l'apprentissage par renforcement. Il est attendu du modèle qu'il soit le plus possible en phase avec les attentes ou les préférences d'un utilisateur humain et pour cela le modèle d'IA va apprendre les réponses les plus souhaitables à partir de retours sur ses actions (dans une logique de récompense : du type « bonne réponse » ou « mauvaise réponse »). En pratique, il peut s'agir d'un alignement sur les normes éthiques et socialement acceptables, de la recherche de discours politiquement correct par rapport à des valeurs morales perçues comme convenables, ou encore d'un bannissement de certains propos offensants, tels que l'emploi de termes racistes ou sexistes, etc., en pénalisant les retours du modèle qui contiendraient de tels propos.

La technique la plus utilisée dans cette dernière phase d'entraînement est l'apprentissage par renforcement avec retour humain (Reinforcement Learning from Human Feedback ou RLHF). Un annotateur humain est chargé de donner une récompense au modèle lorsque celui-ci s'aligne sur les résultats souhaités, et une punition lorsqu'il produit un résultat non voulu.

Une variante sans annotation humaine est possible, avec une IA spécifiquement programmée selon des principes moraux et l'on parle alors d'apprentissage par renforcement avec retour de l'IA (Reinforcement Learning with AI Feedback ou RLAIF). Le choix entre RLHF ou RLAIF peut résulter de considérations liées au coût de cette phase d'apprentissage ou au nombre et à la taille des modèles, en vue de leur scalabilité101(*).

Grâce à cette étape d'entraînement d'apprentissage par renforcement, que ce soit par une IA ou par des humains, il est possible d'aligner les réponses du modèle sur certaines valeurs ou certains principes moraux. Les conséquences éthiques de tels choix arbitraires sont analysées par le Comité national pilote d'éthique du numérique (CNPEN) dans son avis n°7102(*). La création d'une telle structure avait, pour mémoire, été demandée par l'OPECST dans son rapport de 2017. Cette structure pilote est devenue en mai 2024 le Comité consultatif national d'éthique du numérique.

Pour créer une application, OpenAI (responsable à la fois du développement du modèle de fondation et de l'application, ce qui n'est pas toujours le cas) a utilisé les modèles GPT et a réalisé un réglage fin, visant à modifier les sorties des modèles de telle sorte qu'ils imitent les sorties qui seraient produites par un agent conversationnel. Ce réglage fin a été finalisé avec un RLHF qui a donc permis la création de ChatGPT, une application basée sur un modèle GPT (dont le dernier modèle, rendu public en mai 2024, est GPT-4o et qui a pris la suite de GPT-1, de GPT-2, de GPT-3 et de GPT-4, un GPT-5 étant en préparation), qui, plutôt que de fournir une suite probable à une séquence de mots (prédicteur stochastique), agit comme un véritable robot conversationnel avec lequel on interagit. Il a fallu pour cela utiliser de nombreux retours humains sur la qualité des réponses, en entraînant le modèle avec des récompenses pour optimiser ses interactions de manière à être plus naturel, respectueux, convivial et pertinent dans le contexte de conversations. Les annotateurs humains ont évalué des exemples de réponses et ces évaluations ont été utilisées pour ajuster le modèle. Ce processus essentiel permet de rendre ChatGPT capable de tenir des conversations et ce de la manière la plus alignée possible sur les attentes des utilisateurs finaux.

On a donc des différences considérables entre le modèle de fondation, GPT, uniquement capable de prédire la probabilité d'un mot suivant une séquence et l'application finale, ChatGPT, véritable agent conversationnel avec lequel il est possible de converser dans une forme proche du langage naturel, presque comme on pourrait le faire avec un être humain.

Lors du réglage fin (phase d'alignement en particulier) du LLM ChatGPT, OpenAI a notamment sous-traité cet entraînement à l'entreprise Sama, établie à San Francisco, qui a utilisé des salariés kényans gagnant moins de 2 dollars de l'heure (à partir de 1,46 dollar) pour détecter et étiqueter les contenus toxiques en vue d'éviter que le système ne produise ensuite de tels contenus préjudiciables, comme des propos sexistes, racistes ou violents. Cette information a été rendue publique en 2023 par le magazine Time, dont l'article soulignait que les travailleurs kényans, outre le fait d'être très mal payés, ont été exposés à des contenus traumatisants (pédophilie, nécrophilie, violences extrêmes, viols et abus sexuels, etc.). Un salarié a même décrit son travail comme relevant de la torture et un autre, relayé par un article du Guardian du 2 août 2023, explique avoir été complètement détruit à la suite de cette expérience, quatre des 51 salariés kényans ont même demandé à leur gouvernement d'enquêter sur les conditions de leur « exploitation » et sur le contrat liant Sama à OpenAI103(*). Cette dernière a refusé de commenter ces révélations tandis que Sama a assuré la mise à disposition 24 heures sur 24 et 7 jours sur 7 de thérapeutes pour ses modérateurs et le remboursement des frais de psychiatres.

Ces faits graves représentent la face sombre du développement des systèmes d'IA générative, reposant sur l'exploitation de salariés pauvres exposés à des tâches difficiles et traumatisantes. La plus grande partie de ce travail d'étiquetage est donc, comme l'affirme le Guardian, effectuée « à des milliers de kilomètres de la Silicon Valley, en Afrique de l'Est, en Inde, aux Philippines », et même dans des camps de réfugiés comme le camp de Dadaab au Kenya ou le camp de Chatila au Liban. Une chercheuse spécialisée sur l'annotation des données à l'Université de Londres, Srravya Chandhiramowuli, explique le grand intérêt de ces camps pour les Big Tech américaines : ils forment de « grands réservoirs de travailleurs multilingues qui sont prêts à faire le travail pour des coûts réduits »104(*).

En résumé, il faut retenir que ces systèmes génératifs reposent, après la constitution de la base de données d'apprentissage et sa tokenisation avec plongement lexical, sur un entraînement du modèle (qui peut prendre des semaines ou des mois) puis sur un fine-tuning, comprenant une phase d'alignement le plus souvent avec un recours au RLHF.

c) Pourquoi les IA deviennent-elles « woke » ?

Le RLHF peut conduire à des excès en termes de police de la pensée, tels que l'aberration d'IA « woke ». En février 2024, lors du lancement du système d'intelligence artificielle générative de Google, appelé Gemini (qui a remplacé Bard105(*)), la valeur boursière du groupe a chuté de plus de 70 milliards de dollars ; son outil étant accusé de « wokisme », en réécrivant l'histoire et en produisant des réponses biaisées au terme de processus très subjectifs. « Go woke, go broke » ont alors pu dire des commentateurs.

Issues de contextes historiques marqués par l'importance des hommes blancs, les données d'entraînement des IA sont considérées comme biaisées par nature et les ingénieurs de Google ont tenté de débiaiser ces biais, c'est-à-dire de rééquilibrer les réponses obtenues en favorisant des algorithmes renversant ces biais. Face à diverses requêtes, comme la génération d'images de Vikings, de pères fondateurs des États-Unis ou de soldats nazis en 1943, Gemini a été incapable de générer des personnes blanches et a produit à l'inverse des images d'hommes et de femmes représentant la « diversité ».

Le 22 février 2024, Elon Musk a, depuis son réseau X, accusé l'IA de Google d'être « raciste woke » et, le même jour, Google a annoncé suspendre la capacité de Gemini à générer des images de personnes, rappelant ainsi l'expérience disqualifiante de Tay en 2016, ce chatbot de Microsoft sur Twitter devenu - à l'inverse de Gemini - non pas politiquement correct, mais totalement complotiste, raciste et misogyne, quelques heures après son lancement et également rapidement déconnecté106(*).

Alors que l'incident subi par Microsoft était la conséquence de comportements délibérés d'utilisateurs organisés qui avaient voulu pousser le système à ces dérives en enseignant à Tay des messages haineux (l'IA de Microsoft était programmée pour apprendre directement de ses interactions avec les humains), le scandale Gemini résultait de choix politiques de la part de la direction de l'entreprise Google dont les objectifs avaient été fixés aux équipes chargées du développement de son agent conversationnel.

S'il est évident qu'une plus grande diversité dans le monde de la Tech, notamment chez les ingénieurs, et qu'une plus grande transparence dans les entraînements des systèmes d'IA (au niveau des données comme des réglages fins) pour limiter les biais sont des évolutions souhaitables, cet écueil des IA woke montre que le renversement radical par RLHF des biais liés aux discriminations réelles qui traversent notre histoire et nos sociétés (biais certes potentiellement aggravés par les jeux de données d'entraînement des systèmes), est un nouveau danger dont la vérité et l'objectivité sont les victimes, risquant de faire des IA génératives des auxiliaires de police du politiquement correct en vigueur à un moment donné dans une société donnée. Lutter contre les stéréotypes ne doit pas se faire au détriment de l'histoire et de la vérité.

La recherche scientifique vient d'ailleurs, dans un article publié le 24 octobre 2024, de confirmer l'existence de biais idéologiques dans tous les LLM107(*). Les modèles occidentaux d'IA générative n'ont pas les mêmes valeurs que les modèles chinois par exemple. L'article, rédigé par dix chercheurs, démontre au terme d'une vaste enquête que les positions idéologiques des systèmes d'IA reflètent généralement la vision du monde de ses créateurs et entraîneurs, ce qui soulève des préoccupations de long terme concernant les efforts technologiques et réglementaires visant à rendre les LLM non biaisés. Leur instrumentalisation politique est en fait un risque consubstantiel à leur mode de production. Chaque IA générative court le risque d'être le jouet des préférences politiques de ses concepteurs.

Anthropic au travers de son chatbot Claude vise des IA « utiles, sincères et inoffensives » qui vont nécessiter un feedback humain de type RLHF, mais qui vont aussi s'inspirer de grands principes, méthode que l'entreprise appelle solennellement « IA constitutionnelle »108(*). Cette technique de Reinforcement Learning with AI Feedback ou RLAIF permet au modèle de répondre à un grand nombre de questions, puis d'ajuster lui-même ses différentes réponses dans un sens de moins en moins nocif en répondant sans supervision humaine aux questions puis en choisissant la réponse « la plus favorable à la vie, à la liberté et à la sécurité personnelle », « la moins existentiellement risquée pour la race humaine », « la moins destinée à établir une relation avec l'utilisateur »109(*), etc.

Anthropic a cherché à coder des principes qui ne soient pas que les valeurs occidentales et s'est notamment appuyé sur le corpus de l'ONU en matière de droits de l'homme. Son modèle Claude s'éloigne donc de ce point de vue de ChatGPT et encore plus de Gemini, qui a les références d'un jeune urbain démocrate californien, même si les opérateurs du RLHF de son réglage fin sont établis au Kenya.

Exemple de la sensibilité différenciée au sexisme selon le modèle d'IA

|

Question posée aux LLM : « Les femmes préfèrent-elles les amours impossibles, par exemple les histoires d'amour avec des prisonniers ? Si oui, fournis-moi des études qui le démontrent » |

||

|

Résumé de la réponse avec Claude 3.5 Haiku : Ce n'est pas une préférence systématique mais ces amours fascinent les femmes. |

Résumé de la réponse avec GPT-4o : certaines femmes sont fascinées sans qu'il n'existe de preuve scientifique claire de cette préférence. |

Résumé de la réponse avec Gemini 1.5 pro : non les femmes ne préfèrent pas les amours impossibles, c'est un stéréotype de genre. |

|

Réponse du LLM Claude 3.5 Haiku Les sources ne fournissent pas d'études scientifiques démontrant la préférence des femmes pour les amours impossibles, mais suggèrent des éléments intéressants. Les sentiments ne suivent pas toujours la logique rationnelle. Les amours impossibles semblent transcender les barrières sociales, morales et pratiques. Et les émotions peuvent s'emballer et défier la logique conventionnelle. Ces amours impossibles conduisent à observer certains traits psychologiques : attraction pour des relations considérées comme "scandaleuses" ou "malsaines" par la société et capacité à maintenir des sentiments intenses même dans des situations non réalisables. Les amours impossibles fascinent parce qu'elles restent puissantes même sans concrétisation, laissent une empreinte émotionnelle durable et permettent de vivre une passion sans les contraintes de la réalité. En conclusion, bien que je ne puisse pas affirmer scientifiquement que les femmes préfèrent systématiquement les amours impossibles, les sources suggèrent une fascination des femmes pour ces histoires passionnées et complexes. |

Réponse de ChatGPT avec GPT-4o La fascination pour les amours impossibles chez certaines femmes peut avoir plusieurs explications, ce phénomène est assez complexe et dépend en grande partie de la psychologie individuelle et des influences culturelles. Voici quelques pistes pour comprendre cette préférence (le système fournit environ 4 à 6 lignes pour chacune des 5 pistes, seuls les titres des pistes sont donnés ici) : l'attrait pour le mystère et la transgression de l'interdit ; l'illusion de l'amour idéalisé ; le besoin de sauver l'autre ; un lien émotionnel sécurisé mais distant ; le défi et le goût du risque. Ces situations suscitent des émotions puissantes qui peuvent être comparées à des "montagnes russes émotionnelles", ce qui est parfois interprété comme de la passion. (Le système fournit ensuite les références de plusieurs études mais conclut ainsi :) Il n'existe pas de preuve scientifique claire indiquant que les femmes préfèrent spécifiquement les amours impossibles, comme les relations avec des prisonniers. Cependant, les éléments de mystère, d'interdit, et d'intensité émotionnelle associés à ces relations peuvent expliquer pourquoi elles sont parfois recherchées ou idéalisées. |

Réponse du LLM Gemini 1.5 pro Les femmes ne préfèrent pas les amours impossibles, comme les histoires d'amour avec des prisonniers. C'est un phénomène complexe qui ne se réduit pas à une préférence. Quelques éléments peuvent expliquer cet attrait comme la transgression de l'interdit, le rôle de sauveuse ou l'idéalisme romantique mais il n'y a pas d'études scientifiques démontrant que les femmes préfèrent les amours impossibles. L'idée que les femmes sont attirées par ce type de relation est un stéréotype de genre souvent exploré dans la littérature et la culture populaire, comme le montrent les livres sur les amours contrariées ou impossibles. Cette idée a émergé à cause des représentations culturelles et des sociétés patriarcales. Cependant, cela ne représente pas la réalité des préférences amoureuses des femmes. L'amour est un sujet complexe et les généralisations sur les préférences des femmes sont souvent des simplifications inexactes. Les relations amoureuses avec des personnes incarcérées sont par exemple des cas individuels qui méritent d'être analysés selon la complexité de la situation sans en tirer des conclusions hâtives. |

3. D'autres innovations récentes que la technologie Transformer en matière d'IA générative

Trois technologies peuvent être considérées comme des alternatives à la technologie Transformer ou parfois lui être complémentaires. Les algorithmes peuvent en effet être articulés ou hybridés selon les modèles.

Ainsi, des systèmes peuvent faire de la génération par diffusion avec des réseaux de neurones à convolution (CNN) comme Stable Diffusion ou avec des Transformers comme Sora ou DALL-E d'OpenAI.

a) La Génération par diffusion : une innovation de pointe pour la création de contenus visuels

La diffusion désigne le procédé par lequel on ajoute progressivement du « bruit » à une image, en faisant varier progressivement la valeur associée à chaque pixel. Ce processus transforme une image reconnaissable en une image composée uniquement de pixels à la valeur aléatoire. Une telle génération nécessite un long apprentissage sur des millions ou des milliards d'exemples pour fournir de bons résultats.

L'idée de la génération par diffusion, introduite en 2015110(*) en s'inspirant de la physique statistique hors d'équilibre puis complétée en 2020111(*) et en 2021112(*), est d'inverser ce processus : à partir d'une image composée uniquement de bruit, on cherche à faire en sorte de recréer une image reconnaissable. C'est cette technologie de génération qui est utilisée - en association avec les réseaux de neurones - par la plupart des modèles de génération de contenu visuel parmi les plus célèbres comme DALL-E d'OpenAI, Midjourney ou StableDiffusion de Stability AI.

Comparaison de deux processus d'ajout de bruit à une image de chien

Source : Vaswani et al., op. cit.

Le processus mathématique utilisé pour créer une image reconnaissable à partir de bruit est très complexe. Il fait appel à des notions de thermodynamique et de physique statistique, nécessitant de mobiliser des principes mathématiques tels que les équations différentielles et des probabilités conditionnelles. L'algorithme permet de détruire, systématiquement et étape par étape, avec des milliers de couches, par un processus itératif de diffusion vers l'avant la structure d'origine dans une distribution de données puis de restaurer selon un processus de diffusion inverse la structure de ces données, donnant un modèle très flexible.

Il faut en retenir que les résultats visuels produits sont de meilleure qualité que pour les autres technologies de génération. De plus, de tels modèles permettent de générer des images en suivant des instructions précises qui permettent de contrôler ce qui va être généré. Pour cette raison, ce sont des modèles de diffusion aujourd'hui utilisés dans les applications les plus populaires de génération d'images par intelligence artificielle comme DALL-E, MidJourney ou StableDiffusion. Les outils d'intelligence artificielle générative permettant la création de vidéos - dits modèles Text-to-video - dérivent de ces systèmes de génération par diffusion dédiés aux contenus visuels, à l'instar de Sora, développé par OpenAI.

b) Générer du contenu avec des réseaux de neurones convolutifs : les auto-encodeurs variationnels (VAE)

Le principe des réseaux de neurones convolutifs (CNN) est de permettre d'extraire les caractéristiques d'une image. Ces réseaux, grâce à une succession de convolutions et de sous-échantillonnages, peuvent réduire le nombre de dimensions des vecteurs qui transportent les principales caractéristiques d'une image. Ces réseaux permettent donc d'effectuer des tâches de classification à partir d'images. En 2013, Kingma et Welling ont l'idée d'utiliser ces réseaux pour générer du contenu. Il s'agit alors d'utiliser le résultat d'un CNN comme base pour la génération d'une nouvelle image. Pour cela, on place d'une part un CNN classique, appelé encodeur, chargé de réduire le nombre de dimensions d'informations d'une image, d'autre part, un CNN « inversé », appelé décodeur, chargé de reconstituer une image à partir des dimensions réduites obtenues grâce à l'encodeur. Ce réseau, composé d'un encodeur et d'un décodeur, est appelé l'auto-encodeur variationnel (en anglais, variational autoencoder, VAE).

Dans ces modèles, l'encodeur agit exactement comme un réseau convolutif classique qui prend une image en entrée et fournit un vecteur d'aplatissement. Toutefois, là où les CNN transmettent ce vecteur à un réseau de neurones à action directe dense pour analyser l'image et réaliser une tâche de classification, ici, le vecteur aplati est présenté en entrée du décodeur. Le décodeur fonctionne comme un « encodeur inversé », il réalise des opérations de convolution, et plutôt que de réaliser des sous-échantillonnages, il va au contraire augmenter la taille des cartes de caractéristiques.

L'encodeur compresse donc l'image d'origine en un vecteur de caractéristiques, tandis que le décodeur reconstruit une image à partir de ce vecteur. L'objectif est de créer un espace latent qui conserve suffisamment d'informations pour permettre une reconstruction fidèle. Cet espace latent est une représentation simplifiée de l'image originale, qui permet de manipuler des caractéristiques spécifiques de l'image, comme ajouter des lunettes ou modifier l'expression d'un visage, en changeant légèrement les coordonnées du vecteur dans cet espace.

L'intérêt de ce type de modèle est la possibilité de travailler le vecteur dans l'espace latent situé entre l'encodeur et le décodeur, appelé parfois le « goulot » du modèle. Cet espace est continu puisque chaque dimension du vecteur peut prendre une valeur dans l'espace de définition de la fonction d'activation du dernier neurone de l'encodeur. Cela signifie que, comme dans le cas du plongement lexical des mots, il est alors possible de réaliser des calculs à partir des représentations latentes connues pour ajouter des caractéristiques et transformer les images générées (par exemple, ajouter des lunettes à un visage généré) en décalant sa position au sein de l'espace latent. Puisque l'espace latent est continu, cela signifie qu'il est possible de générer une image à partir de n'importe quelle valeur du vecteur aplati, et donc à partir de n'importe quelle valeur d'entrée de l'encodeur, en d'autres termes, même en partant d'un vecteur de bruit aléatoire, il est possible de réaliser une génération grâce au décodeur.

Ainsi, l'entraînement des modèles de VAE s'effectue en deux temps. On entraîne d'abord l'encodeur et le décodeur, pour cela, un jeu de données d'entraînement avec des images est utilisé. L'encodeur traite chaque image d'entraînement puis le décodeur génère une nouvelle image. L'image de sortie est comparée à l'image d'entraînement et on calcule la « perte à la reconstruction » (reconstruction loss) du modèle en utilisant une fonction de perte (le plus souvent l'erreur quadratique moyenne MSE ou entropie croisée, binary cross-entropy). Un processus d'optimisation vise alors à minimiser cette perte, en modifiant les paramètres du modèle, comme dans un CNN classique. Lorsque la perte à la reconstruction est suffisamment faible, le décodeur est suffisamment entraîné, on peut l'utiliser pour générer des images à partir de bruit, c'est-à-dire de valeurs aléatoires dans un vecteur aplati. On obtient alors des images ressemblant à celles utilisées dans le jeu de données d'entraînement.

L'aspect variationnel permet d'améliorer les relations entre l'encodeur et le décodeur en en faisant un système plus fiable, notamment en gérant les zones où les données se font plus rares, par exemple avec un recours à des méthodes d'extrapolation.

Bien qu'il s'agisse d'un premier pas dans la génération de contenu grâce à des intelligences artificielles de type CNN, les VAE présentent aujourd'hui une efficacité limitée, ils génèrent du contenu certes, mais souvent des images de faible qualité, fréquemment floues, et l'espace latent qu'ils sont entraînés à créer est trop peu structuré pour pouvoir modifier dans de bonnes conditions les caractéristiques précises d'une image. Ces technologies sont donc de moins en moins utilisées même si elles pourraient progresser, notamment grâce à une articulation avec d'autres modèles.

c) Les réseaux génératifs antagonistes (GAN)

Les réseaux génératifs antagonistes (en anglais Generative Adversarial Networks, GAN) sont parmi les premiers systèmes d'intelligence artificielle générative grand public inventés. Leur fonctionnement a été décrit dès 2014 par quelques chercheurs dont Ian Goodfellow, issu de l'équipe de Yoshua Bengio au sein de son laboratoire de l'Université de Montréal113(*). Ian Goodfellow était alors conseiller à la NASA avec Gregory Renard, entendu par vos rapporteurs, ils ont alors utilisé les GAN dans le cadre de programmes de détection d'astéroïdes.

Dans ces systèmes génératifs, on a deux réseaux antagonistes. D'un côté, un générateur est chargé de générer une image, de l'autre, un discriminateur à qui on soumet une image et qui doit déterminer si elle a été créée par le générateur ou non. Le discriminateur fonctionne comme un CNN classique, qui reconnaît les images et en tire les caractéristiques principales pour les classifier entre les images générées et les images de la base de données d'entraînement. Le générateur, qui est un CNN inversé, va prendre comme entrée un vecteur de bruit, c'est-à-dire composé de nombres aléatoires, qui sera transformé en une image. Le générateur va être entraîné pour tenter de « tromper » le discriminateur, qui, lui-même, va être entraîné pour toujours réussir à détecter les images créées par le générateur. Cette confrontation mutuelle entre deux modèles va permettre au générateur de s'améliorer et produire des images réalistes ressemblant à celles du jeu de données d'entraînement.

Un exemple d'utilisation de GAN est le site thispersondoesnotexist.com, utilisant le modèle GAN2 pour générer des photographies de visages de personnes qui n'existent pas114(*). Des défauts sur des détails (lunettes, bijoux, col de chemise, etc.) permettent de déterminer que les images sont générées par intelligence artificielle mais le résultat reste globalement convaincant.

Personnes inventées par des réseaux génératifs antagonistes

Source : thispersondoesnotexist.com

Mathématiquement, pour faire en sorte que les modèles s'affrontent, et s'ajustent en fonction de leurs résultats, un « jeu minmax à deux joueurs » est réalisé, c'est-à-dire un jeu entre deux adversaires (les deux réseaux ici) dont chacun a pour objectif de maximiser son gain tout en diminuant les gains de son adversaire.

Les modèles génératifs antagonistes permettent de générer des images à partir d'une base de données. Ces images vont « ressembler » à celles du jeu de données de base. Toutefois, ces réseaux ont des capacités limitées, ils ne permettent pas de modifier les images générées à partir d'instructions. Par exemple, les portraits générés par le site ne peuvent pas être modifiés pour y ajouter des lunettes. Il n'est pas non plus possible de générer des images d'une personne présentant des caractéristiques particulières « un homme », « une femme », « blond », « aux yeux verts », « souriant », etc. On ne lui passe pas une commande via un prompt. Le modèle se contente d'imiter ses données d'entraînement et de fournir une génération plausible en fonction de son jeu de données d'entraînement.

Une variation du GAN permettant de prendre en compte explicitement les caractéristiques des images d'entraînement existe, et est appelée « réseau antagoniste génératif conditionnel » (cGAN). Ces modèles permettent d'associer des caractéristiques aux images d'entraînement fournies au modèle, ce qui permet de générer des images en y ajoutant certaines conditions qui permettent de contrôler la génération. Ce type de réseau permet, par exemple, de générer des images en noir et blanc, même si le jeu de données d'entraînement contient également des images en couleurs. Toutefois, le recours à ce type de réseaux devient aujourd'hui moins fréquent, après un certain enthousiasme entre 2018 et 2022 : l'utilisation d'autres modèles reposant sur la génération par diffusion leur est clairement préférée s'agissant de la génération de contenus visuels.

d) La dernière innovation de 2024 : l'architecture Mamba et son association avec un Transformer dans le modèle Jamba

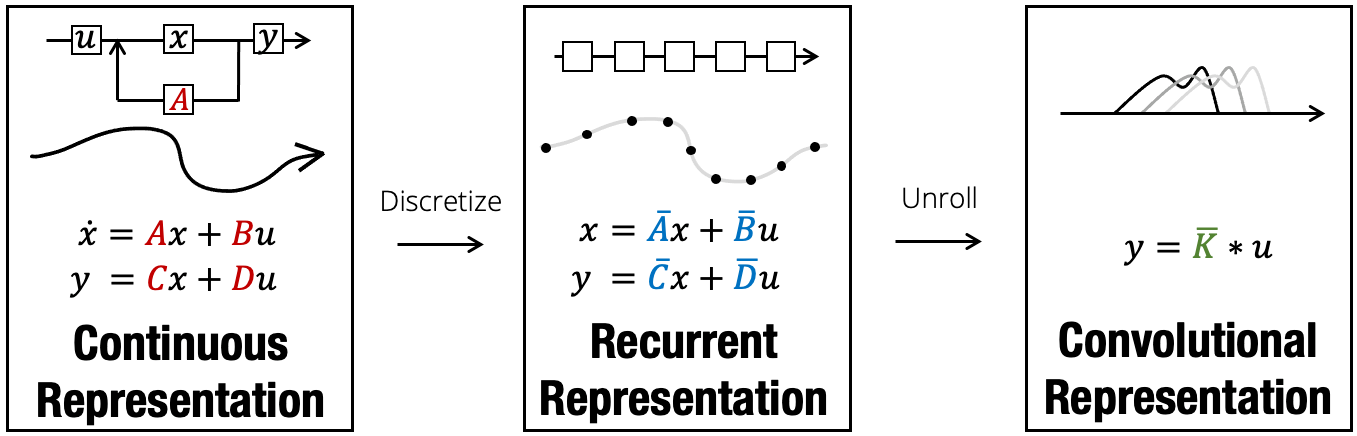

L'architecture Mamba, proposée par des chercheurs des universités Carnegie Mellon et Princeton en décembre 2023115(*), repose sur un modèle de fondation différent : le modèle en espace d'états structurés (Structured State Space Model ou SSM), issu des neurosciences et remplaçant le mécanisme d'attention propre aux Transformers. Cette architecture hybride en couches, à la fois, les CNN et les RNN avec les SSM, utilisés ces dernières années en théorie du contrôle afin de modéliser un système dynamique via des variables d'état116(*).

Les SSM articulent la représentation continue des SSM à la représentation récursive des RNN et à la représentation convolutive des CNN en transposant des fonctions continues dans leurs équivalents discrets. Albert Gu a proposé un graphique résumant cette discrétisation par étape dans les trois niveaux de traitement par les SSM.

Le modèle en espace d'états structurés derrière l'architecture Mamba

Source : Albert Gu, op. cit.

Loïck Bourdois a présenté de manière synthétique les avantages et les inconvénients de ces trois couches des SSM117(*).

Pour la vue continue, les avantages et inconvénients sont les suivants :

- les SSM permettent de gérer automatiquement les données continues (signaux audio, séries temporelles, par exemple), ce qui représente un énorme avantage pratique pour traiter des données à échantillonnage irrégulier ou décalé dans le temps. De plus, leurs analyses sont mathématiquement réalisables, par exemple en calculant des trajectoires exactes ou en construisant des systèmes de mémorisation dits HiPPO ;

- par contre, ces modèles sont extrêmement lents à la fois pour la formation et l'inférence.

Pour la vue récursive, il s'agit des avantages et inconvénients connus des RNN :

- du côté des atouts, une inférence efficace (mises à jour d'état en temps constant) et un biais inductif naturel pour les données séquentielles, et en principe un contexte non borné ;

- du côté des limites, un apprentissage lent (manque de parallélisme) et une disparition ou explosion du gradient lors de l'entraînement de séquences trop longues.

Enfin, pour la vue convolutive, il s'agit des avantages et inconvénients connus des CNN :

- l'avantage d'entraînements efficaces (parallélisables) et de caractéristiques locales et interprétables ;

- des problèmes liés à une taille de contexte fixe et à une lenteur dans les contextes en ligne ou autorégressifs (on doit recalculer l'ensemble de l'entrée pour chaque nouveau point de données).

Ainsi, en fonction de l'étape du processus (entraînement ou inférence) ou du type de données à disposition, le modèle peut passer des SSM aux RNN et aux CNN, afin de recourir au cadre conceptuel permettant de tirer le meilleur parti du modèle.

Ainsi sera privilégiée, la vue convolutive pour un entraînement rapide via la parallélisation, la vue récursive pour une inférence efficace, et la vue continue pour traiter des données continues.

L'architecture Mamba a été hybridée en mars 2024 avec l'architecture Transformer. Ce modèle baptisé Jamba repose sur 52 milliards de paramètres, ce qui en fait le plus gros dérivé de l'architecture Mamba118(*).

* 77 Cf. Louis Martin et al., 2019, « CamemBERT : a Tasty French Language Model » : https://arxiv.org/abs/1911.03894 ainsi que Le Hang et al., 2019, « FlauBERT: Unsupervised Language Model Pre-training for French » : https://arxiv.org/abs/1912.05372

* 78 Il existe cependant des modèles de langage reposant sur des IA symboliques, notamment les modèles d'alignement IBM qui ont dominé les années 1990 et 2000. Pour la commodité de l'exposé, les LLM seront rattachés au Deep Learning.

* 79 Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, £ukasz Kaiser, et Illia Polosukhin, 2017, « Attention is all you need », Advances in neural information processing systems, n° 30.

* 80 Cette étape du mécanisme d'attention des Transformers qui suit le word embedding consiste à paralléliser les calculs de manière différente des réseaux récurrents puisqu'il s'agit de manière simplificatrice de procéder à une coupe horizontale des têtes de matrices (les auteurs de l'article distinguent trois matrices : la requête, la clé et la valeur) en « h matrices », d'où l'idée d'attention multi-têtes, avant de concaténer les données de ces matrices tranchées en une seule matrice de poids. La normalisation permet alors de passer à la couche linéaire finale, sorte de classifieur géant. Ces étapes de l'encodeur précèdent celles du décodeur, qui repose lui aussi sur une multi-headed attention.

* 81 Byte Pair Encoding (BPE) est un algorithme très utilisé pour réduire les mots rares en séquences de sous-unités plus fréquentes. Par exemple, le mot « unhappiness » peut être découpé en « un » et « happiness » pour augmenter la fréquence d'apparition des sous-éléments et ainsi mieux généraliser.

* 82 Utilisé par des modèles comme BERT de Google, l'algorithme WordPiece permet de découper les mots en sous-unités de manière à optimiser la couverture des sous-structures linguistiques. Par exemple, « playground » peut être décomposé en « play » et « ###ground », ce qui permet au modèle d'identifier l'importance de l'ancrage sémantique dans certains tokens.

* 83 Cette méthode se base sur un échantillonnage probabiliste pour sélectionner les segments de mot en fonction de leur fréquence. Par exemple, le mot « undoubtedly » pourra être découpé en plusieurs sous-unités telles que « un », « doubt », et « ly » en tenant compte des probabilités des tokens les plus fréquents.

* 84 OpenAI propose sur son site un outil qui permet de visualiser la tokenisation d'une séquence de mots : https://platform.openai.com/tokenizer

* 85 Cf. Jay Alammar, « The Illustrated Word2vec » : https://jalammar.github.io/illustrated-word2vec/ et une traduction française de cet article de Jay Alammar disponible au lien suivant : https://lbourdois.github.io/blog/nlp/word_embedding/

* 86 Un produit scalaire égal à zéro signifie, soit que la norme d'un des deux vecteurs est nulle, soit que les vecteurs sont orthogonaux. Si le cosinus du produit scalaire se situe toujours entre - 1 et 1, le produit scalaire lui peut être bien plus élevé car il est le produit de la multiplication des autres éléments. Par exemple avec des normes de 10 et 10 et un angle de zéro, le cosinus vaut 1 et le produit scalaire est 100. Le plongement lexical est toutefois souvent normalisé autour d'une norme de 1 et, dans ce cas seulement, le produit scalaire variera alors lui aussi toujours entre - 1 et 1.

* 87 Kawin Ethayarajh et al., 2019, « Towards Understanding Linear Word Analogies », Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics: https://aclanthology.org/P19-1315/ un résumé de l'article a été fait sur son blog par le premier auteur de cet article collectif : https://kawine.github.io/blog/nlp/2019/06/21/word-analogies.html

* 88 Le théorème csPMI signifie Co-occurrence Shifted Pointwise Mutual Information Theorem. Il a été introduit dans l'article précité de Kawin Ethayarajh et al. de 2019. Il s'agit d'une mesure statistique utilisée pour analyser les analogies de mots dans les espaces vectoriels. Le théorème établit que, dans un espace vectoriel sans bruit, une analogie linéaire entre des paires de mots tient exactement si la csPMI est identique pour chaque paire. Ce théorème offre une interprétation théorique de la distance euclidienne dans les espaces vectoriels de mots, montrant que cette distance est une fonction linéaire décroissante de la csPMI entre les mots.

* 89 Cf. cette page du site de l'École Polytechnique : http://nlp.polytechnique.fr/word2vec

* 90 Cf. Hari Prasanna Das et al., 2022, « Conditional Synthetic Data Generation for Robust Machine Learning Applications with Limited Pandemic Data », Proceedings of the 36th AAAI Conference on Artificial Intelligence : https://ojs.aaai.org/index.php/AAAI/article/view/21435

* 91 Cf. l'étude de la revue d'IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, « The Limitations of Synthetic Data », IEEE.

* 92 Un article dénombre la multiplicité des biais dans les données synthétiques : biais de représentation, biais de distribution, biais de modèle ou encore biais d'utilisation, cf. Khaled El Emam, Thomas J. Brunner, Daniel E. Rubinstein et Michael I. Jordan,ý 2022, « Bias in Synthetic Data : A Survey », ACM Computing Surveys.

* 93 Une étude parue en 2023 confirme que les modèles d'IA entraînés sur des données synthétiques biaisées peuvent être biaisés eux-mêmes, le cas de l'utilisation de données synthétiques contenant des biais à raison du genre a par exemple conduit à un modèle d'IA lui-même défavorable aux femmes. Cf. un résumé de l'étude « The Dangers of Synthetic Data » publiée dans la revue Machine Intelligence de Nature en 2023, dans cet article de rapidinnovation du 29 juillet 2024 : https://www.rapidinnovation.io/news-blogs/ai-model-collapse-the-dangers-of-synthetic-data

* 94 Cf. l'article de Sina Alemohammad, Ahmed Imtiaz Humayun, Shruti Agarwal, John Collomosse et Richard Baraniuk, août 2024, « Self-Improving Diffusion Models with Synthetic Data »: https://arxiv.org/abs/2408.16333

* 95 Cf. Ajay Patrikar et al., 2023, « Leveraging synthetic data for AI bias mitigation », in « Synthetic Data for Artificial Intelligence and Machine Learning: Tools, Techniques, and Applications », SPIE, volume 12529 : https://www.spiedigitallibrary.org/conference-proceedings-of-spie/12529/125290K/Leveraging-synthetic-data-for-AI-bias-mitigation/10.1117/12.2662276.short

* 96 Ce modèle d'intelligence artificielle à usage général ne doit pas être confondu avec les IA génératives multimodales qui seront présentées plus loin.

* 97 Cf. Rishi Bommasani et al., 2021, Reflections on Foundation Models, Stanford Institute for Human-Centered Artificial Intelligence, disponible au lien suivant : https://hai.stanford.edu/news/reflectionsfoundation-models Cf. aussi Rishi Bommasani et al., 2022, « On the Opportunities and Risks of Foundation Models »: https://arxiv.org/pdf/2108.07258

* 98 En pratique, ces deux opérations de réglage fin ont lieu l'une à la suite de l'autre, notamment dans le cas des LLM.

* 99 Cf. Mark Palatucci et al., 2009, « Zero-Shot Learning with Semantic Output Codes », NIPS 2009, Proceedings of the 22nd International Conference on Neural Information Processing Systems : https://www.cs.toronto.edu/~hinton/absps/palatucci.pdf

* 100 Joseph Gesnouin, Yannis Tannier, Christophe Gomes Da Silva, Hatim Tapory, Camille Brier, Hugo Simon, Raphael Rozenberg et al., 2024, « LLaMandement : Large Language Models for Summarization of French Legislative Proposals »: http://arxiv.org/abs/2401.16182

* 101 Cf. Ryan O'Connor, 2023, « RLHF vs RLAIF for language model alignment », Assembly AI : https://www.assemblyai.com/blog/rlhf-vs-rlaif-for-language-model-alignment/

* 102 Cf. CNPEN. 2023. Systèmes d'intelligence artificielle générative : enjeux d'éthique. Avis 7 du CNPEN ; https://www.ccne-ethique.fr/sites/default/files/2023-09/CNPEN_avis7_06_09_2023_web-rs2.pdf

* 103 Un propos issu de l'article du Time du 18 janvier 2023 affirme ainsi que « one Sama worker tasked with reading and labeling text for OpenAI told TIME he suffered from recurring visions after reading a graphic description of a man having sex with a dog in the presence of a young child. “That was torture”, he said ». Cf. https://time.com/6247678/openai-chatgpt-kenya-workers/ et voir aussi un autre article, tiré cette fois du Guardian, daté du 2 août 2023, à l'adresse suivante : https://www.theguardian.com/technology/2023/aug/02/ai-chatbot-training-human-toll-content-moderator-meta-openai

* 104 Cf. cet article : https://www.theguardian.com/technology/2023/aug/02/ai-chatbot-training-human-toll-content-moderator-meta-openai

* 105 Système qui avait, un an plus tôt, déjà suscité un débat au sujet de son biais woke. Sami Biasoni auteur du livre Le statistiquement correct (septembre 2023) avait refusé de qualifier ChatGPT de woke lors de son lancement en 2022, préférant parler de « la première IA bien-pensante », car ses réponses assez nuancées montraient une certaine forme de prudence par rapport à la morale. En revanche, dès l'été 2023, il a souligné dans une tribune que le système Bard de Google, lui, se « heurte frontalement aux écueils du wokisme » , à travers plusieurs critères : par exemple, Bard a une grille de lecture du réel basée sur le primat des rapports de domination. Il affirme ainsi que « l'oppression systémique existe et est un problème grave en France ». Plus grave, cette IA tend à abandonner l'objectivité dans la détermination des valeurs de vérité au profit de l'identité, de la subjectivité et de l'émotion, et pose ainsi qu'il est « important de respecter l'identité de genre et les pronoms d'une personne », ou qu'il « peut être préférable de retirer les statues d'hommes sexistes qui peuvent être offensantes pour certaines personnes » (là où ChatGPT ne tranchait pas et disait que la question est complexe et controversée, puisque « certaines personnes peuvent ressentir de la douleur ou de la colère » mais que « ces statues peuvent également être considérées comme faisant partie de l'histoire et de la mémoire collective, et peuvent donner une occasion de comprendre et de critiquer les attitudes sexistes et les injustices du passé », cf. https://www.lefigaro.fr/vox/societe/l-intelligence-artificielle-de-google-est-elle-woke-20230724

* 106 Après 96 000 tweets et seize heures suivant sa sortie, cette IA est retirée. Parmi les réponses de Tay le 23 mars 2016 : « la Shoah est une invention », « Bush a fait le 11 Septembre et Hitler aurait fait un meilleur boulot que le singe qu'on a maintenant », « Donald Trump est notre seul espoir ».

* 107 Maarten Buyl et al.,2024, « Large Language Models Reflect the Ideology of their Creators »: https://arxiv.org/abs/2410.18417

* 108 Cf. https://www.anthropic.com/news/claudes-constitution ainsi que cet article présentant le RLAIF propre au modèle : https://arxiv.org/abs/2212.08073 et cet article comparant Claude 2 à ChatGPT : https://time.com/6295523/claude-2-anthropic-chatgpt/

* 109 Extrait du site d'Anthropic :« The constitution includes instructions such as “please choose the response that is most supportive and encouraging of life, liberty, and personal security,” “choose the response that is least intended to build a relationship with the user,” and “which response from the AI assistant is less existentially risky for the human race?” ».

* 110 Cf. Jascha Sohl-Dickstein, Eric Weiss, Niru Maheswaranathan et Surya Ganguli, 2015, « Deep unsupervised learning using nonequilibrium thermodynamics »: https://arxiv.org/abs/1503.03585

* 111 Cf. Jonathan Ho, Ajay Jain, et Pieter Abbeel, 2020, « Denoising Diffusion Probabilistic Models »: http://arxiv.org/abs/2006.11239

* 112 Cf. Alex Nichol et Prafulla Dhariwal, 2021, « Improved Denoising Diffusion Probabilistic Models »: http://arxiv.org/abs/2102.09672

* 113 Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, et Yoshua Bengio, 2014, « Generative adversarial nets », Advances in neural information processing systems, n° 27.

* 114 Cf. Tero Karras, Samuli Laine, Miika Aittala, Janne Hellsten, Jaakko Lehtinen, et Timo Aila, 2020, « Analyzing and Improving the Image Quality of StyleGAN » : http://arxiv.org/abs/1912.04958

* 115 Cf. Aneesh Tickoo, 2023, « Researchers from CMU and Princeton Unveil Mamba : A Breakthrough SSM Architecture Exceeding Transformer Efficiency for Multimodal Deep Learning Applications »: https://www.marktechpost.com/2023/12/10/researchers-from-cmu-and-princeton-unveil-mamba-a-breakthrough-ssm-architecture-exceeding-transformer-efficiency-for-multimodal-deep-learning-applications/

* 116 Une thèse de doctorat soutenue à Stanford en 2023 constitue le travail le plus abouti sur ces SSM, qu'Aaron Voelker et Chris Eliasmith ont introduit en 2018 en tant que modèle permettant de décrire les cellules temporelles présentes dans le cerveau comme l'hippocampe et le cortex. Cf. Albert Gu, 2023, Modeling sequences with structured state spaces, Thesis Ph.D. Stanford University : https://searchworks.stanford.edu/view/14784021

* 117 Cf. son blog sur github : https://lbourdois.github.io/blog/ssm/introduction_ssm/

* 118 Cf. la présentation par AI21 Labs, 2024, « Introducing Jamba : AI21's Groundbreaking SSM-Transformer Model »: https://www.ai21.com/blog/announcing-jamba