II. UNE DIZAINE DE PROJETS DE GOUVERNANCE INTERNATIONALE NON COORDONNÉS

La gouvernance globale de l'IA est insuffisante en dépit des annonces répétées de nombreuses organisations internationales en la matière. Non seulement les propositions se multiplient de manière stérile car non coordonnée mais l'on assiste au creusement de la fracture numérique mondiale sous l'effet de l'IA, très inégalement distribuée sur notre planète, tant du point de vue de sa production que de son utilisation.

Outre leurs propres investigations, auditions, déplacements et questionnaires, vos rapporteurs ont pu s'appuyer pour cette partie sur les travaux comparatifs de Florence G'sell, rencontrée à l'Université de Stanford387(*).

Ses recherches montrent que plusieurs catégories d'actions internationales peuvent être distinguées :

- le fait de rédiger des traités internationaux ou des lignes directrices mondiales, comme le traité contraignant du Conseil de l'Europe, l'accord non contraignant de l'ONU appelé « Pacte numérique mondial » ou les recommandations de l'Unesco ;

- le soutien aux politiques nationales et internationales par des recommandations et des travaux d'experts, comme l'illustrent les contributions de l'OCDE et du Partenariat mondial sur l'intelligence artificielle ;

- les discussions internationales dans des forums diplomatiques restreints comme le G7, le G20, les BRICS ou le Conseil du commerce et des technologies UE-États-Unis (TTC) ;

- la coordination de l'action des États membres d'organisations supranationales en matière de régulation de l'IA comme l'illustrent les initiatives de l'UE ou de l'Union africaine ;

- ou encore le fait de convoquer des représentants des États et du monde économique autour d'une question spécifique, à l'instar des sommets sur la sécurité de l'IA.

A. LA RÉFLEXION TECHNIQUE LA PLUS ABOUTIE : LES PRINCIPES, RECOMMANDATIONS ET MÉTRIQUES DE L'OCDE

Dès 2016, l'Organisation de coopération et de développement économiques (OCDE) a réuni un forum de prospective sur l'IA puis a organisé en 2017 une grande conférence sur l'IA (« L'IA. Machines intelligentes, politiques intelligentes »). En 2018 et 2019, elle s'est appuyée sur un groupe d'experts sur l'IA pour élaborer, en mai 2019, des principes de l'IA et des recommandations de l'OCDE pour les politiques publiques.

1. Les principes, les recommandations et la classification des systèmes

Adoptés en 2019 et amendés en 2024, les principes et les recommandations sur l'intelligence artificielle de l'OCDE388(*) fournissent des lignes directrices non contraignantes aux États membres et à toutes les parties prenantes dans le cadre d'une approche responsable pour une IA digne de confiance. Certaines des recommandations concernent spécifiquement la gouvernance de l'IA et les politiques publiques de l'IA à mettre en place au niveau national. Une mise à jour des principes a été effectuée en 2024.

Prendre des décisions d'encadrement de l'IA nécessite de savoir de quoi l'on parle : il faut pouvoir décrire ce que l'on souhaite exactement réguler. Ainsi, l'OCDE propose un cadre qui permet de classer les systèmes d'IA selon différentes dimensions aux stades de leur conception et de leur utilisation389(*). Tous les pouvoirs publics devraient prendre en compte cet outil de classification ou une méthode similaire (tournée davantage vers la chaîne de valeur de l'IA par exemple) pour mettre en place des politiques publiques de régulation de l'IA.

L'OCDE fait valoir que tout modèle d'IA se décompose en quatre phases distinctes : le contexte (1), les données d'entrées (2), les modèles d'IA (3), les tâches demandées ainsi que les sorties de l'IA (4). Bien que ces phases soient distinctes, elles s'influencent mutuellement et ne peuvent pas être traitées de manière totalement indépendante.

Le contexte désigne l'environnement socio-économique dans lequel l'IA est déployée. Il désigne aussi bien l'utilisateur potentiel du modèle, que les parties prenantes à son développement, ou le secteur économique qu'il sert. De ce contexte dépendent les données et les valeurs d'entrées du modèle d'IA pour lesquelles il est important de connaître la nature mais également la façon dont elles sont collectées, ou dont elles sont amenées à évoluer, s'il s'agit de données dynamiques. De ces données récoltées dépend le modèle d'IA, qui est lui-même, un critère de classification. Le modèle peut être de type symbolique, donc basé sur une série de règles logiques, ou connexionniste et donc appuyé sur des calculs de type statistique. S'il est connexionniste, le modèle peut être soumis à un apprentissage supervisé ou semi-supervisé par exemple. Enfin, selon le type de modèle, les sorties ne sont pas les mêmes et il est évidemment important d'évaluer les modèles à la lumière de leur production et des tâches qui leur sont demandées.

Par exemple, une IA appliquée au secteur des banques et assurances peut être considérée comme particulièrement sensible car elle prend place dans un contexte (1) pouvant influencer de façon importante la vie des personnes qu'elle concerne. Elle prendrait en entrée des données personnelles, relevés de compte ou données de santé par exemple (2). Selon que le modèle utilisé est symbolique ou connexionniste (3), on n'a pas la même possibilité d'expliquer les choix réalisés en sortie par le système d'IA (4), ce qui peut représenter une injustice pour le client concerné.

L'OCDE pose cinq principes généralistes que doivent respecter les systèmes d'IA tout au long de leur cycle de vie et qui concernent l'ensemble des acteurs concernés par l'IA. Elle formule aussi cinq recommandations spécifiques à destination des décideurs politiques.

Les principes généralistes à destination de tous les acteurs de l'IA sont conçus à partir des valeurs morales nécessaires au développement d'une IA saine. Ces principes sont : « Croissance inclusive, développement durable et bien-être » (1.1), « Droits de l'homme, vie privée, équité » (1.2), « Transparence, explicabilité » (1.3), « Robustesse, sécurité, sûreté » (1.4) et « Responsabilité » (1.5). Ces principes font qu'une intelligence artificielle doit être dédiée à la prospérité et être bénéfique à l'humanité et à la planète (1.1), dans le respect des droits de l'homme, de la dignité humaine, de la vie privée et sans induire de discriminations (1.2). Ses sorties doivent être explicables au mieux et de la façon la plus transparente possible (1.3) tout en protégeant les données des utilisateurs du modèle ou des personnes dont les données ont servi d'entraînement au modèle, la sécurité et la sûreté du système doivent être garanties (1.4). Enfin, les individus et organisations qui déploient des systèmes d'IA doivent toujours être responsables du fonctionnement, donc des résultats de ces derniers et être capables d'en rendre compte (1.5).

Les cinq recommandations pour les décideurs politiques doivent permettre à ceux-ci d'anticiper les transformations liées au développement de l'IA. L'organisation recommande ainsi : un investissement dans la recherche et le développement de l'IA (2.1), l'encouragement d'un écosystème numérique pour l'IA (2.2), la fourniture d'un environnement de politiques publiques propices à l'IA (2.3), la construction et la préparation de capacités humaines pour la transformation du marché du travail (2.4) et la coopération internationale pour une IA de confiance (2.5).

Plus concrètement, cela signifie que les gouvernements devraient envisager des investissements de long terme dans la recherche et le développement d'IA mais également encourager la recherche publique comme la recherche privée, et ce, dans des domaines techniques mais également juridiques ou sociétaux, y compris à travers des investissements dans des systèmes ouverts dits open source (2.1). Les gouvernants devraient également encourager la création d'un écosystème permettant de faciliter le partage de technologies ou d'infrastructures entre les acteurs des systèmes d'IA de confiance (2.2). Un environnement de politiques publiques propices devrait également être construit, permettant de passer de la recherche et développement aux produits en passant, par exemple, par des mécanismes d'expérimentation de type bac à sable (2.3). Il faut également préparer la transition du marché du travail impliquée par l'IA en travaillant avec les parties prenantes à ce changement et en promouvant le dialogue social durant la mise en place de l'IA au travail (2.4). Enfin, plutôt qu'un travail strictement national, la gouvernance de l'IA devrait être le fruit de coopérations internationales permettant le partage d'informations ou le développement de normes internationales (2.5).

Le système de classification proposé par l'OCDE prend en compte l'ensemble du cycle de vie du modèle d'IA et permet de définir précisément ce qu'est un système d'IA et d'en donner des limites claires. Couplé à des principes éthiques également définis, il offre des ressources très utiles pour encadrer l'IA, surtout que l'OCDE y ajoute des recommandations pour le contenu des politiques publiques à mettre en place. L'organisation a aussi proposé de définir des métriques d'analyse et des outils pour corriger les problèmes pouvant subvenir. L'objectif est de maximiser, grâce à ces outils, le respect des principes éthiques par l'ensemble des parties prenantes, dont les gouvernants, tout au long du cycle de conception et d'utilisation de l'IA.

2. La méthodologie des métriques

L'OCDE a commencé par recenser un ensemble de métriques d'analyse et d'outils provenant d'organismes publics ou privés, permettant d'évaluer et de corriger d'éventuels défauts présents dans l'une des quatre phases des systèmes d'IA mentionnées ci-dessus. L'organisation a répertorié des méthodologies pour 104 métriques et 125 outils techniques de correction des systèmes d'IA.

L'utilisation d'une métrique d'évaluation dépend du type de modèle utilisé, le Word Error Rate ne peut s'appliquer qu'aux modèles de reconnaissance de discours par exemple. Elle dépend également de l'objectif évalué lors du passage du test. L'OCDE en répertorie huit, fondés sur les principes éthiques définis dans son cadre d'analyse. Certaines métriques relèvent de plusieurs principes, mais certains principes n'ont aucune métrique : responsabilité (aucune métrique disponible), équité (20 métriques), bien-être humain (aucune métrique), performance (78 métriques), gouvernance des données et de la vie privée (1 métrique), robustesse et sécurité numérique (7 métriques), sûreté (1 métrique) et transparence et explicabilité (11 métriques). On peut remarquer une répartition inégale des métriques selon les catégories, la performance des modèles possédant par exemple bien plus de métriques que les autres catégories.

En plus de ces métriques, le site de l'OCDE propose des outils d'écoute sociale relatifs à l'IA, par exemple celui concernant les tweets sur X (ex-Twitter) mentionnant l'intelligence artificielle.

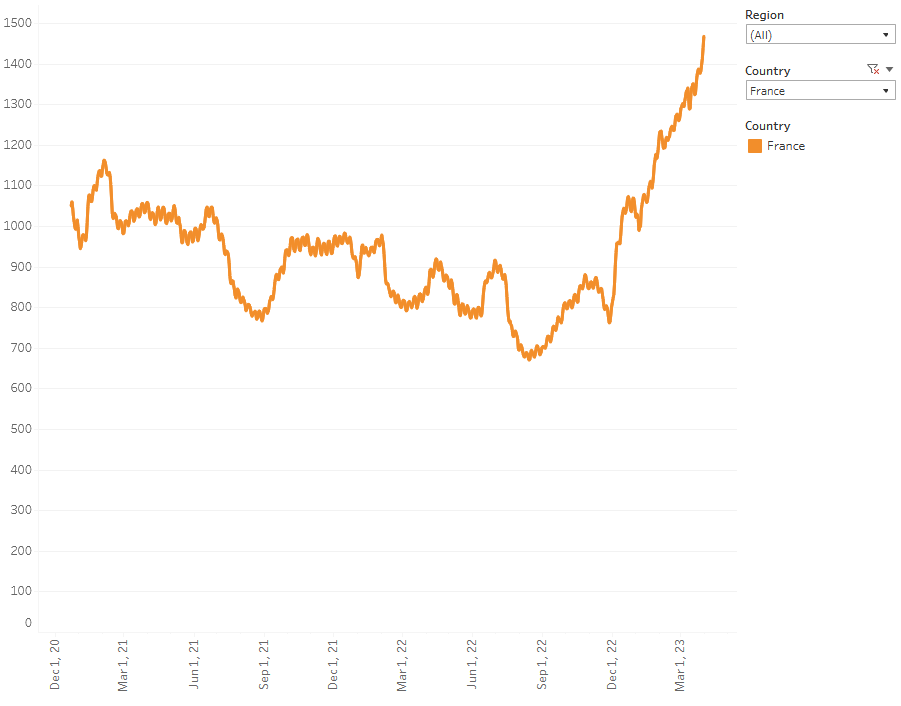

Moyenne mensuelle du nombre de tweets sur X (ex-Twitter) mentionnant l'intelligence artificielle en France

Légende :

- en abscisse, la date

- en ordonnée, la moyenne mobile sur 30 jours du nombre de tweets mentionnant l'IA

Source : OECD.AI

On trouve également une mesure du nombre d'incidents concernant l'IA (AIM) qui est un outil d'écoute sociale puisqu' il s'appuie sur le traitement automatique d'articles de presse dans le monde, et permet de voir quels sont les moments d'engouement médiatique autour de la notion d'intelligence artificielle. La mesure des incidents peut se décliner en fonction de la nature de l'incident (c'est-à-dire en fonction du principe éthique que l'IA n'a pas respecté), mais également de sa sévérité (menace non physique, danger, blessure ou mort), du type de dommage causé (physique, psychologique, etc.) et de la partie prenante victime de l'incident (gouvernement, consommateur, travailleur, minorité, etc.).

Le cadre de travail de l'IA de l'OCDE permet donc de définir l'IA au-delà de sa simple définition technique : la mise en place de politiques publiques selon ses recommandations exige par exemple de s'intéresser aux relations entre l'IA et son contexte ; le contexte influence les données et les résultats influencent l'environnement). Cette définition sociotechnique concerne un grand nombre de parties prenantes lors de la conception et l'utilisation de modèles d'IA.

Toutes les parties prenantes sont concernées par des enjeux éthiques majeurs liés à l'IA : les systèmes d'IA doivent être bénéfiques pour l'homme et son environnement, ils doivent respecter la dignité humaine et faire en sorte qu'aucun biais ne puisse nuire aux utilisateurs. Les données d'entraînement ainsi que les données des utilisateurs doivent être protégées de façon robuste et les organisations doivent toujours être responsables des produits d'un système d'IA. Pour cela, les décideurs publics doivent mettre en place des initiatives qui permettent d'encourager la recherche et développement, ainsi que de créer un écosystème sain. Les décisions doivent être prises en accord avec les multiples parties prenantes lors de la création des systèmes d'IA comme pendant leur phase de fonctionnement, qu'il s'agisse du secteur public comme du secteur privé. La gouvernance mondiale de l'IA doit être mise en place pour permettre la création de normes internationales ainsi qu'un partage plus vaste des bonnes pratiques.

Des métriques et outils sont déjà à disposition pour évaluer et corriger les défauts des systèmes d'IA, toutefois comme il a été vu, tous les principes ne disposent pas de métriques permettant leur évaluation : la performance est clairement le critère le plus évalué alors que les aspects éthiques ou la responsabilité sont difficilement voire pas du tout mesurées. En conclusion, à côté de l'évaluation des modèles eux-mêmes, l'écoute sociale peut faire partie des outils techniques qui permettent d'observer l'environnement de l'IA, notamment le rapport de la société aux technologies.

3. L'Observatoire des politiques publiques de l'IA

L'OCDE a créé un Observatoire des politiques publiques de l'IA390(*) pour aider les décideurs politiques et les experts en IA à travers un centre de ressources complet sur les politiques et les normes applicables à l'IA, tout en promouvant les lignes directrices de l'OCDE puisqu'il surveille aussi la manière dont les pays respectent et mettent en oeuvre les principes et les recommandations politiques de l'organisation.

L'évaluation biennale conduite par l'Observatoire, intitulée « L'état de mise en oeuvre des principes de l'OCDE en matière d'IA », indique qu'en 2024 plus de 50 pays avaient mis en oeuvre des stratégies nationales en matière d'IA, dont beaucoup font directement référence aux principes de l'OCDE391(*). Sur les 46 adhérents aux principes de l'OCDE en matière d'IA, 41 avaient mis en place une stratégie nationale et trois étaient en train d'en élaborer une. Le rapport indique qu'en mai 2024, plus de 1 020 programmes d'action avaient été initiés dans 70 pays membres et non membres, ce qui témoigne de l'attention accrue portée à la gouvernance de l'IA depuis 2019.

Le site de l'Observatoire des politiques de l'IA de l'OCDE propose également un référentiel en temps réel qui suit les paysages réglementaires de l'IA de 69 pays différents392(*). Il fournit également des outils pour l'audit des systèmes d'IA393(*) et un Global AI Incident Monitor (AIM)394(*). Pour soutenir davantage l'AIM et les travaux de l'OCDE visant à recueillir des rapports sur les incidents liés à l'IA, l'Observatoire des politiques de l'IA a publié un rapport sur la définition des incidents liés à l'IA et des termes associés qui propose des distinctions importantes entre les incidents liés à l'IA et les dangers de l'IA395(*).

* 387 Cf. son rapport précité d'octobre 2024.

* 388 Recommandations de l'OCDE sur l'IA de 2019 : https://oecd.ai/en/assets/files/OECD-LEGAL-0449-en.pdf ; Principes sur l'IA : https://www.oecd.org/en/topics/ai-principles.html ; Mise à jour des principes en 2024 : https://www.oecd.org/newsroom/oecd-updates-ai-principles-tostay-abreast-of-rapid-technological-developments.htm

* 389 Cf. cette classification si utile sur le site de l'OCDE : https://oecd.ai/en/classification une vidéo a également été réalisée : https://youtu.be/-S5dCR9z5rI

* 390 Cf. cette présentation de l'Observatoire des politiques publiques de l'IA :

https://oecd.ai/en/about/background

* 391 OCDE, 2024, « Report on the Implementation of the OECD Recommendation on Artificial Intelligence » : https://one.oecd.org/document/C/MIN(2024)17/en/pdf

* 392 Cf. OCDE, « National AI Policies & Strategies » : https://oecd.ai/en/dashboards/overview

* 393 Cf. OCDE, « Catalogue of Tools and Metrics for Trustworthy AI » : https://oecd.ai/en/catalogue/tools?terms=audit&approachIds=1&objectiveIds=2&orderBy=dateDesc

* 394 Cf. OCDE, « AI Incidents Monitor » : https://oecd.ai/en/incidents

* 395 Cf. OCDE, « Defining AI incidents and related terms » : https://doi.org/10.1787/d1a8d965-en