II. CLARIFIER LES OBJECTIFS

Une fois les usages possibles identifiés, il faut dire ce que l'on en attend, en fixant des objectifs clairs et assumés.

A. TENIR ENFIN LES PROMESSES DU NUMÉRIQUE

L'IA doit être mise au service de l'intérêt général et de l'amélioration de la qualité du service public, à la fois pour les agents et pour ses usagers. Elle a le potentiel de le rendre non seulement plus efficace, mais aussi plus humain, c'est-à-dire plus simple, plus accessible, plus proche et plus équitable.

B. ASSUMER L'OBJECTIF D'ÉCONOMIES BUDGÉTAIRES

L'IA va permettre d'automatiser certaines tâches, et ces gains de productivité doivent se traduire en économies budgétaires : il en va de la bonne gestion des deniers publics, et donc de l'intérêt général. Cet objectif doit être assumé. Pour autant, il n'implique en tant que tel aucun effet automatique sur l'emploi : ce sont avant tout des tâches qui sont amenées à disparaître, et des métiers qui sont appelés à se transformer, non seulement au bénéfice des usagers, mais aussi des agents eux-mêmes.

C. GARANTIR LA PROTECTION DES DROITS FONDAMENTAUX

Enfin, le recours à l'IA ne doit pas se faire au détriment de la protection des libertés individuelles et des droits fondamentaux, et en particulier de la protection des données personnelles. Il faut ici distinguer les enjeux liés à la technologie - l'IA et l'IA générative - et les enjeux liés à son domaine d'application - l'impôt, les prestations sociales et la lutte contre la fraude.

En ce qui concerne le domaine d'application, et notamment en matière de lutte contre la fraude, le recours croissant à des technologies numériques potentiellement intrusives a conduit le législateur et le juge à mettre en place un régime particulièrement protecteur des droits et libertés individuelles, fondé sur des dispositions spécifiques (cf. encadré), qui s'ajoutent aux garanties plus anciennes dont bénéficie le contribuable (secret fiscal, garanties procédurales, etc.) et aux dispositions d'application générale, notamment la loi Informatique et libertés (loi Cnil) et le règlement général sur la protection des données (RGPD) ainsi qu'aux principes constitutionnels (vie privée, etc.). À l'avenir, l'usage de l'IA à des fins de lutte contre la fraude devra être encadré de la même manière.

L'encadrement des outils de détection de la fraude fiscale : quelques exemples

Le Conseil constitutionnel admet de longue date que la lutte contre la fraude fiscale, objectif à valeur constitutionnelle (OVC), permet au législateur d'apporter des aménagements aux droits et libertés individuelles. Avec l'usage croissant des nouvelles technologies, le juge constitutionnel a toutefois resserré l'encadrement des pouvoirs de l'administration fiscale, notamment en amont de la phase de contrôle, c'est-à-dire au stade de la détection.

Les croisements de données automatisés - qu'ils utilisent l'IA ou non - doivent donc être expressément autorisés et encadrés par la loi et faire l'objet d'une déclaration préalable, voire le plus souvent d'un avis de la Cnil. On peut notamment citer les exemples suivants :

- l'usage du droit de communication à des fins de détection générale (communication des « fadettes » par exemple), qui n'était pas encadré en tant que tel, a été restreint en 2019 : il est désormais limité à la recherche des infractions fiscales les plus graves (majoration de 80 %) et doit être autorisé par un magistrat indépendant saisi par le procureur de la République ;

- la collecte automatisée (webscrapping) de données sur les réseaux sociaux, autorisée à titre expérimental en 2020 et prolongée pour deux ans à partir de 2024, a été limitée par le Conseil constitutionnel et la Cnil aux seuls contenus publiquement accessibles, ce qui excluait toute collecte sur les plateformes où la création d'un compte utilisateur était nécessaire. La loi de finances pour 2024 a cependant levé cette dernière restriction ;

- le datamining et les échanges d'informations entre administrations doivent être expressément autorisés par le législateur et la Cnil. L'encadrement porte sur les données (limitativement énumérées), les finalités (ici la lutte contre la fraude) et la durée.

Des dispositions similaires existent pour la douane (webscrapping sur les sites de vente en ligne de tabac, par exemple) et les organismes de sécurité sociale.

En ce qui concerne la technologie elle-même, les spécificités de l'IA et en particulier des grands modèles généralistes d'IA générative sont susceptibles de faire émerger de nouveaux risques pour les droits et libertés individuelles. C'est tout l'enjeu de l'AI Act : protéger les droits fondamentaux tout en encourageant l'innovation.

Le texte proposé par la Commission européenne avait dans un premier temps suscité les réserves de la France, qui redoutait que les obligations prévues ne pèsent sur les entreprises les plus innovantes, à commencer par la startup française Mistral AI, l'un des rares concurrents européens crédibles aux acteurs américains, et souhaitait donc limiter la publication du résumé des données d'entraînement (en passant par un « tiers de confiance ») et relever le seuil à partir duquel s'appliquent les obligations renforcées. Les réserves de la France ont finalement été levées et un accord a été signé le 2 février 2024, conduisant à l'adoption de l'AI Act le 13 mars.

Fondée en avril 2023 par trois chercheurs français, Arthur Mensch, Guillaume Lample et Timothée Lacroix, Mistral AI développe des LLM (open source et propriétaires) concurrents de ceux des grands acteurs américains (OpenAI, Google, etc.), dont :

- Mistral 7B (sept. 2023) : LLM open source avec 7 milliards de paramètres, soit bien moins que ses concurrents, ce qui le rend intéressant pour des usages spécialisés.

- Mistral 8x7B (déc. 2023) : LLM open source avec 47 milliards de paramètres.

- Mistral Large (févr. 2024) : LLM propriétaire (modèle fermé), disponible via le cloud de son nouveau partenaire Microsoft, et dont la performance est proche de celle de GPT-4.

En février 2024, elle lance aussi Le Chat, un chatbot similaire à ChatGPT bâti sur ses propres LLM.

Suite à une levée de fonds de 385 millions d'euros en décembre 2023, la société est valorisée à 2 milliards d'euros, ce qui en fait l'un des leaders européens en matière d'IA.

L'enjeu principal, désormais, concerne la mise en oeuvre de l'AI Act, ce qui impliquera de préciser les modalités concrètes d'application de chaque mesure en fonction des différents domaines d'application. En ce qui concerne les missions d'intérêt général relevant de la sphère fiscale et sociale, les enjeux semblent a priori limités. Le seul point de vigilance concerne l'interdiction de tout système de « notation sociale », qui vise principalement les systèmes de « crédit social » existant dans certains pays - la Chine, notamment -, mais qui au sens large pourrait concerner tout traitement de données visant à attribuer un « score » ou un « coefficient » quelconque à un dossier individuel. Une telle définition maximaliste est évidemment impensable, puisqu'elle conduirait de facto à interdire l'informatique dans le service public : un permis de conduire à points ou un dossier sur Parcoursup ne sont rien d'autre qu'un système de notation.

L'AI Act, entre protection des droits fondamentaux et soutien à l'innovation

Présenté en 2021 par le commissaire au marché intérieur, Thierry Breton, le projet de règlement européen sur l'intelligence artificielle, ou AI Act, a été élaboré avant l'apparition de ChatGPT et la diffusion spectaculaire de l'IA générative et des large language models (LLM).

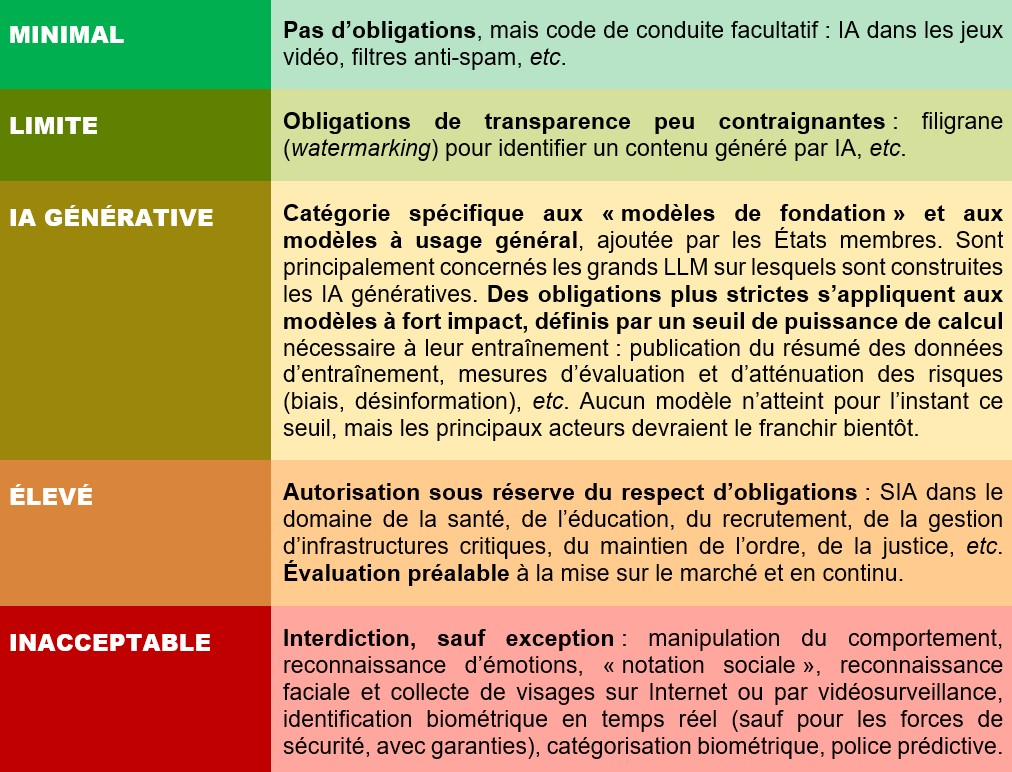

Consciente de la difficulté qu'il y aurait à réguler une technologie aux évolutions si rapides, la Commission a fait le choix d'une régulation des usages, en classant les systèmes d'IA (SIA) par niveau de risque pour les droits fondamentaux :

Un Bureau de l'IA, conseillé par un groupe scientifique d'experts indépendants, sera créé au sein de la Commission européenne pour superviser les modèles d'IA à usage général et faire appliquer des règles communes dans les États membres. Les amendes peuvent atteindre 35 millions d'euros ou 7 % du CA mondial (en cas de violation pour les règles sur les SIA interdits). Des plafonds plus faibles sont prévus pour les PME et les startups. L'AI Act ne sera pas applicable aux SIA utilisés exclusivement à des fins militaires ou de défense, ni aux SIA utilisés aux seules fins de la recherche et de l'innovation.

Négocié pendant plus de deux ans et révisé pour tenir compte du développement de l'IA générative, l'AI Act a fait l'objet d'un accord provisoire entre le Parlement et le Conseil, le 9 décembre 2023, puis d'un compromis final le 2 février 2024, suite à la levée des réserves de la France. Il a été adopté le 13 mars 2024 et entrera en vigueur progressivement à partir de mai 2024, avec un délai allant jusqu'à 36 mois pour les applications à risque élevé.

Comme RGPD avant lui, l'AI Act constitue une première mondiale.

Pour autant, il conviendra de faire preuve de vigilance, et ceci à chaque fois qu'un nouveau cas d'usage de l'IA dans le domaine fiscal ou social se présentera.

La Cnil aura ici un rôle fondamental à jouer, et elle s'est d'ailleurs déjà largement saisie du sujet, avec la création d'un service dédié à l'IA, la publication de « fiches pratiques » à destination des développeurs, et la mise en place d'un dispositif d'accompagnement (« bac à sable ») pour des projets d'IA dans le service public, notamment dans le domaine de la santé. Ses moyens devront être renforcés, comme le propose la Commission IA.

« Notre Commission recommande de poursuivre la modernisation de notre approche de la donnée en conjuguant mieux protection et innovation. [...] Nous recommandons notamment de supprimer des procédures d'autorisation préalable d'accès aux données de santé et de réduire les délais de réponse de la Cnil. Ce mouvement devrait s'accompagner d'une réforme du mandat qui est confié à la Cnil, pour y intégrer un objectif d'innovation. Cette évolution impliquera un ajustement de la composition de son collège, pour qu'une palette plus large de compétences soit représentée (innovation, recherche...), et un renforcement de ses moyens de fonctionnement. »

Rapport de la Commission IA, mars 2024, recommandation 15

La Commission IA propose également de réformer son mandat pour y intégrer un objectif de soutien à l'innovation et à l'expérimentation, et de supprimer les procédures d'autorisation préalable - lourdes et non prévues par le RGPD, qui leur préfère un contrôle ex post - afin notamment de faciliter l'accès aux données de santé. Ces propositions, moins consensuelles, ne concernent pas le domaine du présent rapport, où l'exploitation des données personnelles est déjà encadrée par des dispositions spécifiques protectrices.

En tout état de cause, la protection des libertés et droits fondamentaux passe par le principe de primauté humaine : l'IA peut proposer, mais jamais décider.